Laboratoria badawcze urządzeń elektronicznych

Badania urządzeń elektronicznych pod kątem spełnienia norm kompatybilności elektromagnetycznej, wpływu środowiska klimatycznego czy odporności mechanicznej są dzisiaj znamienną częścią procesów zapewnienia wysokiej jakości oraz integralną częścią procesu projektowania. Specjalizowane placówki badawcze zajmujące się takim testowaniem tym samym pełnią funkcję weryfikatora użytych rozwiązań, komponentów i metod projektowych.

Zainteresowanie kontrolą i oceną sprzętu elektronicznego zwiększa się z uwagi na coraz większą wiedzę firm w tym zakresie oraz świadomość ryzyka. Współpraca na arenie międzynarodowej i wspólny rynek europejski wymuszają na krajowych producentach urządzeń i systemów przeprowadzanie badań w niezależnych akredytowanych jednostkach. Z kolei konieczność minimalizacji kosztów zmusza do wprowadzania korekt w projekcie na wczesnym etapie, bo później, kiedy jest już w produkcji, jest to bardzo kosztowne, a czasem nawet niemożliwe do wykonania.

Obecnie wiele firm idzie krok dalej w kierunku poprawy jakości i tworzy własne, wewnętrzne laboratoria badawcze, które biorą udział w procesie projektowania i wdrażania nowych produktów, a także w kontroli serii produkcyjnych. Jest to dla takich firm niewątpliwie duży atut i potwierdzenie wysokiego poziomu technicznego i merytorycznego. W Polsce znajdziemy szereg placówek badawczych, które mogą przeprowadzić wiarygodną oceną zgodności urządzenia pod kątem obowiązujących norm. Wiele z nich ma wieloletnie doświadczenie w praktycznym rozwiązywaniu problemów związanych z brakiem zgodności i jest w stanie pomóc w projekcie.

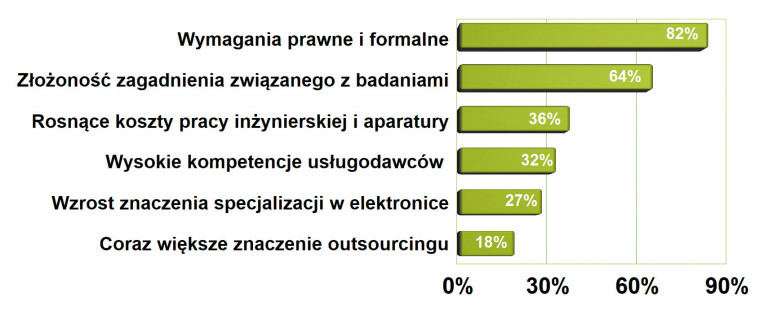

Czynniki sprzyjające zlecaniu badań do laboratoriów to głównie:

Na liście czynników, które w największym stopniu sprzyjają zlecaniu badań w placówkach badawczych, wyróżniają się dwie pozycje: wymagania prawne oraz złożoność zagadnień technicznych składających się na proces oceny. Te dwie pozycje można traktować jako stały element tego zestawienia, gdyż w poprzednich naszych opracowaniach sprzed dwóch i czterech lat było podobnie. Tym razem koszty pracy inżynierskiej i aparatury uplasowały się wyżej, co sygnalizuje, że stają się one jeszcze bardziej istotne niż dawniej.

Główne normy w ocenie urządzeń elektronicznych

Ocena zgodności z wymaganiami ma strukturę drzewiastą, a więc na szczycie znajdują się dyrektywy, które dalej rozszczepiają się na normy przypisane do zagadnień technicznych, grup wyrobów, takich jak na przykład oświetlenie, wymagań branżowych oraz specyficznych wymagań takich jak Ekoprojekt (ErP).

Główne i najważniejsze dyrektywy oceny zgodności urządzeń elektronicznych to oczywiście LVD i EMC. Wymagania tej pierwszej definiuje norma EN 62368-1, która zajmuje się tematem bezpieczeństwa. Kilka lat temu zastąpiła ona normę EN 60950. W przypadku oświetlenia równoważna norma bezpieczeństwa to EN 61347. Ponieważ "bezpieczeństwo" to pojęcie bardzo szerokie, trzeba koniecznie dodać, że chodzi tutaj o bezpieczeństwo ludzi z tytułu narażenia zdrowia, jakie mogą się pojawić podczas użytkowania. Katalog takich narażeń obejmuje oczywiście zagadnienia związane z ochroną przed porażeniem prądem elektrycznym, ale także ryzyko uszczerbku na zdrowiu od wysokiej temperatury, zapłonu, substancji szkodliwych, w tym wydzielanych podczas palenia się, a także ryzyka wynikającego z zasilania z baterii (np. eksplozji).

Grzegorz Modrykamień

dyrektor sprzedaży, członek zarządu EMC-FORTO

Jakie zmiany w podejściu firm do badań urządzeń elektronicznych warto zauważyć?

Odpowiedź na to pytanie zależy, jak długi czas przyjmiemy do analizy. Z mojej obserwacji jako konstruktora elektroniki w latach 2000–2007, z dzisiejszej perspektywy zmieniło się wszystko. Zarówno wyposażenie laboratoriów, dostępność, lista oferowanych badań w jednym miejscu i kompetencje zespołów oraz rozumienie potrzeby wykonywania testów uległo całkowitej zmianie. Charakterystyczne dla dawnych czasów wyobrażenie, że badanie musi być zrobione, "bo będzie kontrola" – wyewoluowało. Dziś rozumiane jest jako jeden z filarów wiedzy o własnej konstrukcji, jest istotnym składnikiem zapewnienia jakości, a także elementem walki konkurencyjnej. Innym aspektem zachodzących zmian jest konieczność dobrego przygotowania badań ze względu na złożoność sprzętu i oprogramowania firmware, a także to, że za uzyskanie zgodności jest odpowiedzialny cały zespół. Dziś trudno uwierzyć, że w przeszłości za wszystkie badania środowiskowe funkcjonalne i "zgodnościowe" bywał odpowiedzialny tylko konstruktor elektroniki.

Jak wyglądają możliwości badawcze laboratoriów w kraju dla firmy, której produkty można określić mianem high-end?

Zauważalny jest trend rozwijania wysokiej specjalizacji laboratoriów w Polsce. Temu celowi służył też projekt Lab-Net realizowany przez zespół laboratoriów w Polsce. Ale nawet placówki, które nie brały udziału w tej inicjatywie, ze względu na rosnącą konkurencję, potrzeby swoich klientów oraz na istotny fakt, że firmy zlecające badania najczęściej posiadają nieduży zestaw narzędzi podstawowych do badań odporności i emisji przewodzonej do celów wewnętrznych badań konstrukcyjnych – poszerzają swoją ofertę.

Oddzielną grupą klientów są firmy motoryzacyjne oraz związane z przemysłem obronnym. Z różnych powodów mają one przekrojowe możliwości wykonania badań. Zatrudniają kilkuset inżynierów testów, posiadają często po kilkadziesiąt komór termicznych, kilkanaście komór EMC wyposażonych w aparaturę i emulatory obciążenia.

Jakie obszary oferty polskich laboratoriów są jeszcze niezagospodarowane lub trudno znaleźć w Polsce/Europie stanowisko dla jakiejś branży?

Dziś czołowe laboratoria badawcze uzupełniają ostatnie luki w niszach jak np. max. wartość szczytowa surge, zakresy częstotliwości w testach odporności na pola o częstotliwościach radiowych 40 GHz 200V/m, czy też maksymalna moc symulatora sieci zasilania dla EVSE. Ale myślę, że w niedalekiej przyszłości, ze względu na dynamikę rozwoju elektroniki, możliwość wykonania badań kombinowanych, to znaczy np. RED+EMC+AI (od prostych asystentów wspierających nasze codzienne czynności do autonomicznych urządzeń powszechnego użytku z rozpoznawaniem danych cech) będzie poszukiwana. Wierzę, że Polskie laboratoria świetnie dostosują ofertę, a mają przewagę w Europie ze względu na dobre wykształcenie inżynierów, co akurat w badaniach np. EMC jest wielkim atutem. Ogólne perspektywy dla rynku badań w Polsce są bardzo dobre.

Dla urządzeń zasilanych z sieci EN62368-1 definiuje wymagania co do jakości izolacji, odstępów po powierzchni, napięcia dotykowego. Precyzuje, co mierzyć, w jakim układzie testowym i podaje graniczne wartości dla prawidłowego działania oraz warunków nienormalnych, a więc takich, gdy urządzenie ulegnie awarii. W takiej sytuacji, a więc gdy na przykład zasilacz ulegnie uszkodzeniu podczas burzy, norma wymaga, aby nie stał się zagrożeniem dla człowieka w chwili awarii i po niej.

Przywoływana norma ma około 400 stron i w wielu miejscach powołuje się na kilkadziesiąt innych regulacji, w których opisano procedury badań, wymagania szczególne związane z jakimiś parametrami, normy definiujące ocenę powiązanych subkomponentów. W ten sposób ocena bezpieczeństwa przykładowej ładowarki prowadzona wg EN 62368 odwołuje się do innych norm nt. wymagań jakościowych dla wtyczki sieciowej, przewodu AC, w celu określenia stopnia IP, oceny optoizolatora, odporności na przebicie izolacji drutu nawojowego w transformatorze, odporności termicznej tworzywa obudowy, skuteczności działania warystora i wielu innych. Do tych 400 stron trzeba więc dodać jeszcze minimum drugie tyle do przeczytania i zrozumienia. Nie jest to łatwa lektura, gdyż wymaga skupienia i poświęcenia dużej ilości czasu.

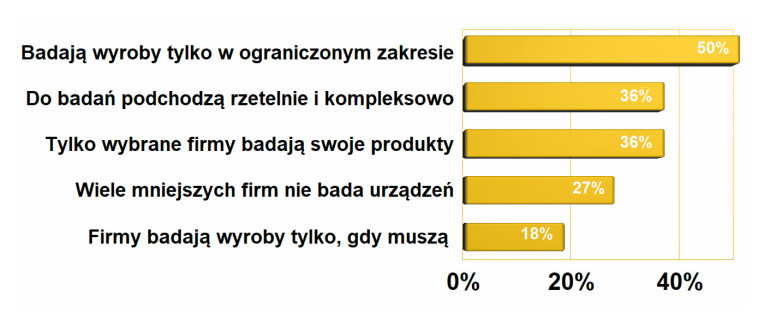

Podejście do badań krajowych firm elektronicznych

Przez wiele lat podejście krajowych firm do badań i obowiązków związanych z badaniami urządzeń z nimi się wiążących nie wyglądało najlepiej i praktycznie się nie zmieniało. Brakowało jakościowego przełomu, zamiast którego były drobne korekty lub przetasowania. Teraz zmiany są nieco większe i w dobrym kierunku. Liczba tych, którzy badają wyroby w ograniczonym zakresie, zmalała o 8%, tych, którzy robią to rzetelnie i kompleksowo, wzrosła aż o 15% Liczba tych przedsiębiorstw na pozycji trzeciej wykresu zmalała z 48% do 36%, a z pozycji czwartej z 42% na 27%. Wszystkie wymienione zmiany mają dobry kierunek i są znaczące. Oby przerodziły się w trwały trend.

Z EMC nie jest wcale łatwiej

Dyrektywa EMC określa wymagania formalne związane z kompatybilnością elektromagnetyczną. Dzieli się ona na dwie części. Pierwsza jest związana z emisją, a więc zaburzeniami wytwarzanymi przez urządzenie elektroniczne, na które narzucane są limity po to, aby nie stało się ono źródłem zakłóceń działania innego sprzętu. Wymagania w tym zakresie opisano w normie EN55032, która dotyczy większości popularnego sprzętu elektronicznego, równoważnej regulację EN55015 dotyczącej oświetlenia. Norma definiuje trzy klasy urządzeń (A, B i C) po to, aby wyprowadzić dla nich szczegółowe wymagania tj. poziomy emisji, zakresy częstotliwości. Różnice między EN55032 i EN55015 też w dużej części sprowadzają się do tego, że dzięki rozdziałowi dokumenty te uwzględniają specyfikę produktów. Do tego mamy jeszcze dyrektywę radiową RED, która dotyczy urządzeń wykorzystujących komunikację radiową.

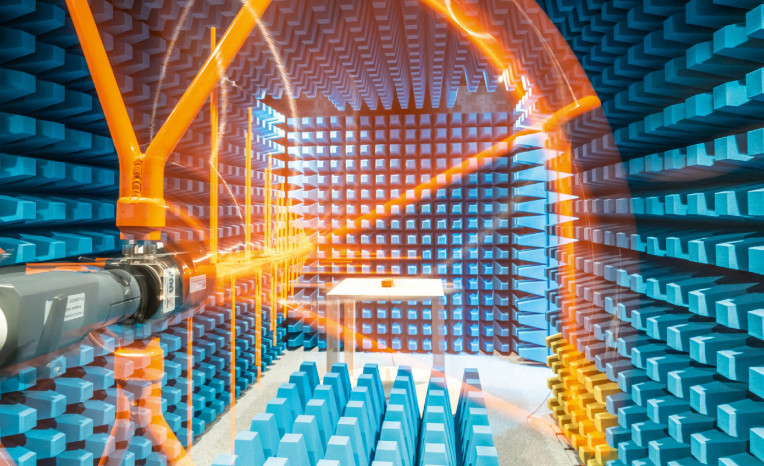

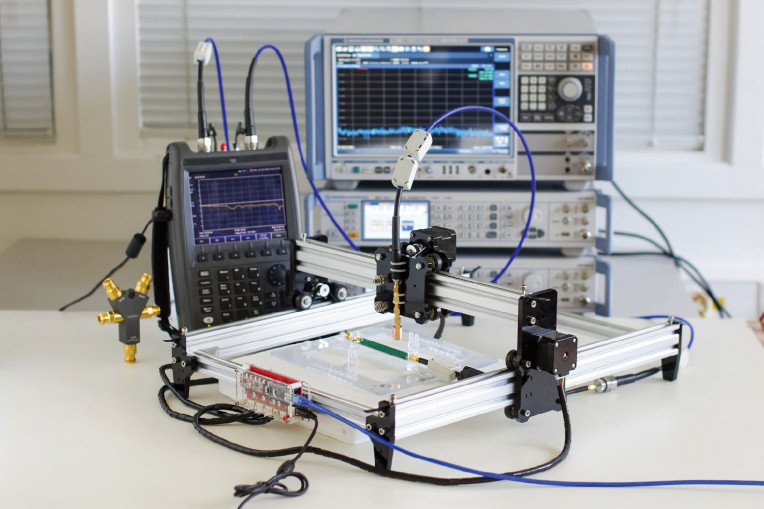

Procedura badań polega w przybliżeniu na tym, aby badane urządzenie umieścić w ekranowanej komorze pomiarowej, a następnie za pomocą anteny kierunkowej połączonej z analizatorem widma z każdej strony zbadać poziom emitowanych zaburzeń z odległości 3 m.

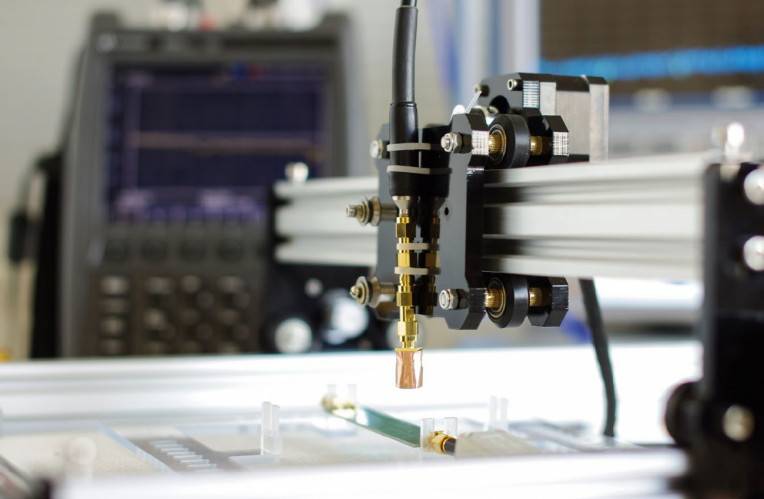

Druga część badań emisji dotyczy zaburzeń elektromagnetycznych przewodzonych. Pod tą nazwą kryją się sygnały emitowane do sieci energetycznej przez kabel zasilający (wprowadzane do sieci). Ta część jest prostsza w realizacji, bo nie jest potrzebna komora i antena. Pomiarów przewodzonych dokonuje się w paśmie do 30 MHz, zaś emisji do minimum 1 GHz, stąd też koszt analizatora (w branży nazywa się go "odbiornikiem") jest bardziej przystępny.

dr inż. Krzysztof Sieczkarek

portfolio manager ds. technologii radiowych i kompatybilności elektromagnetycznej w Łukasiewicz – Poznański Instytut Technologiczny

Jakie czekają nas zmiany w dyrektywie RED dotyczącej urządzeń radiowych? Czy dotyczyć będą one cyberbezpieczeństwa?

Komisja Europejska opublikowała Rozporządzenie Delegowane 2022/30 wprowadzające wymagania dotyczące cyberbezpieczeństwa. Niniejsze rozporządzenie wprowadza nowe wymagania zasadnicze dla urządzeń bezprzewodowych podłączanych do Internetu na podstawie zmodyfikowanego art. 3 ust. 3 lit. d), e) i f) dyrektywy dotyczącej urządzeń radiowych 2014/53/UE (RED). Zgodnie ze zmianami dodatkowe wymagania zasadnicze mają objąć zapewnienie cyberbezpieczeństwa w zakresie: ochrony sieci, ochrony danych osobowych i prywatności oraz ochrony przed oszustwami pieniężnymi.

Rozporządzenie weszło w życie w styczniu 2022 r. i będzie obowiązkowe dla produktów wprowadzanych na jednolity rynek UE od 1 sierpnia 2025 r. Nie warto jednak czekać do ostatniej chwil. Producenci lub autoryzowani przedstawiciele importujący produkty bezprzewodowe połączone z Internetem już teraz mogą skorzystać z usług strony trzeciej, jaką jest Łukasiewicz – PIT i zweryfikować swoje urządzenia na zgodność z wymaganiami planowanych norm zharmonizowanych.

Warto pamiętać, że dotychczasowe wymagania zasadnicze RED dotyczące bezpieczeństwa, kompatybilności elektromagnetycznej, efektywnego wykorzystania widma radiowego się nie zmieniają.

Po przebadaniu emisji czas na testowanie odporności, gdzie mamy normę EN61000. Tutaj chodzi o sprawdzenie, czy urządzenie będzie działać poprawnie w warunkach nieidealnych, a więc przy ekspozycji na różne zaburzenia. Celem jest doprowadzenie do takiej sytuacji, aby środowisko elektromagnetyczne, w którym mamy wiele źródeł promieniowania, nie doprowadziło do zakłócenia i nieprawidłowego działania badanego sprzętu.

W przypadku badań odporności także nie realizuje się jednego testu, ale cały zestaw wyrafinowanych pomiarów. Badana jest wrażliwość na promieniowanie radiowe o dużym natężeniu płynące z anteny, na wyładowania elektrostatyczne ze specjalnego pistoletu przypominającego zapalniczkę piezo do gazu, na przepięcia w sieci, zarówno jednorazowe, jak i całe serie (bursty), na silne pola magnetyczne itd.

Najważniejsze cechy, jakie biorą pod uwagę firmy zlecające badania swoich wyrobów

W tym roku w zestawieniu najważniejszych cech laboratoriów badawczych, które rozważają klienci, na szczycie jest wygoda. Firmy chcą mieć wykonany komplet oceny w jednym miejscu i jak najkrótszym czasie. Zapewne oferta kompleksowych badań w jednym miejscu też wiąże się z szybkością, stąd te dwa kryteria można w tym kontekście traktować łącznie. Na dalszych pozycjach uplasowały się tradycyjne wartości, jak posiadanie akredytacji, duże kwalifikacje kadry, która nie tylko sprawdzi, jak jest, ale też pomoże znaleźć przyczynę problemów. Znaczenie tego czynnika potwierdzają dodatkowo wysoko notowane konsultacje projektowe i godziny inżynierskie, możliwość uczestniczenia w badaniach i badania prototypów. Charakterystyczną cechą wykresu jest też to, że poza pierwszymi trzema górnymi polami i ostatnim na dole, cała reszta ma podobną wielkość.

Badania (oczywiście mówiąc w dużym przybliżeniu) polegają na odtworzeniu jednakowych warunków testu podanych w normie w kontekście budowy stanowiska pomiarowego, obwodów separująco-testowych pozwalających na wstrzyknięcie zaburzenia do działającego sprzętu oraz generatora tworzącego źródło zaburzenia. Konkretne badane zagadnienia opisują liczby wymienione po członie "61000", np. w 61000-2 chodzi o odporność na ESD. Wymagania EN61000 zapisane są na kilkuset stronach, a każda grupa pomiarów wymaga posiadania urządzeń do badań.

Ten krótki i bardzo przybliżony opis ilustruje doskonale, że samodzielna analiza wymagań prawnych zapisanych w normach nie jest łatwa. Są to obszerne dokumenty, w których często następują odwołania do innych szczegółowych definicji i analiza jest bardzo złożona. Nie ma też przewodnika zbiorczego, czegoś na kształt poradnika, jak poruszać się po normach, gdyż raczej zakłada się, że osoba zainteresowana da sobie radę.

Stąd dla większości osób wniosek jest prosty – trzeba poprosić o pomoc specjalistów.

Przemysław Stencel

Kierownik Laboratoriów Badawczych OBR CTM S.A.

Czego poszukują klienci laboratoriów?

Rynek elektroniki coraz bardziej się rozwija i pożąda za oczekiwaniami konsumenta. Producenci urządzeń elektrycznych i elektronicznych najczęściej poszukują laboratorium, które wykona kompleksowe badania w zakresie EMC, ale także testy środowiskowe: badania klimatyczne i mechaniczne. Poszukiwane są placówki, które mają możliwość przebadania urządzeń o dużych gabarytach i dużej wadze. Chociaż w Polsce powstaje coraz więcej laboratoriów z większymi możliwościami, to przebadanie takich urządzeń jest dość skomplikowane. Urządzenia te wymagają do pracy zasilania o znaczącej mocy, a często też potrzebują obciążenia, które zasymuluje pracę w rzeczywistych warunkach. Laboratoria OBR CTM S.A. posiadają możliwość przebadania urządzeń do wagi 5 ton w komorze SAC10, zarówno emisji i odporności przewodzonej, jak i promieniowanej.

Czy zainteresowanie wysoką jakością produktów i usług w branży elektronicznej jest widoczne w liczbie i zakresie zlecanych badań?

Branża elektroniczna nadal jest w fazie rozkwitu, co oznacza, że coraz więcej jest firm w Polsce i na świecie, które produkują i dostarczają urządzenia elektroniczne na rynek. Laboratoria Badawcze OBR CTM S.A. świadczą także usługi laboratoryjne dla przemysłu wojskowego w ramach akredytacji OiB (Obronność i Bezpieczeństwo). Obecnie jest ogromne zainteresowanie badaniami w zakresie norm obronnych. Produkcja nowych urządzeń elektronicznych dla wojska jest w tej chwili bardzo duża, dlatego też rośnie liczba zlecanych badań w tej dziedzinie. Niesamowicie ważne jest profesjonalne podejście, doświadczenie i najnowocześniejszy sprzęt laboratoryjny, aby deklarować spełnienie wymagań dla tego rodzaju urządzeń.

Wiedza, a w zasadzie problem, gdy jej brakuje

Bezsprzecznie, w obecnych czasach trzeba mieć wiedzę na temat zjawisk fizycznych związanych z badaniami, przynajmniej podstawowe kompetencje metrologiczne, a najlepiej też doświadczenie wynikające z wcześniejszych projektów. W ten sposób staje się wiadome, co trzeba kontrolować, jakie są limity, gdzie mogą się pojawić problemy. Jeśli firma ma taką wiedzę, uzyskanie zgodności z wymaganiami dyrektyw i normami jest łatwiejsze, gdyż większość środków ochronnych można zrealizować na etapie projektowania. Gdy rozeznania brakuje, wówczas projektowanie wiąże się z większą niepewnością co do wyników pomiarów oraz ryzykiem, że ewentualny problem trzeba będzie rozwiązać w kosztowny sposób. Na przykład za pomocą drogich materiałów ekranujących lub przez przeprojektowanie układu i płytki. Potem oczywiście trzeba będzie wykonać następne badania, co dodatkowo będzie kosztować i zabierze czas.

Jak sygnalizowano nam w komentarzach do ankiety, w kraju prowadzonych jest za mało szkoleń uświadamiających realny wpływ wyniku negatywnego badań na poziom generowanego zagrożenia podczas użytkowania takich urządzeń elektronicznych. Zdecydowanie najtrudniejszym zagadnieniem jest kompatybilność elektromagnetyczna, w obrębie której zjawiska nie są możliwe do zaobserwowania gołym okiem, stąd też dużo trudniejsze w zrozumieniu pryncypiów rządzących polem elektromagnetycznym i zaburzeniami.

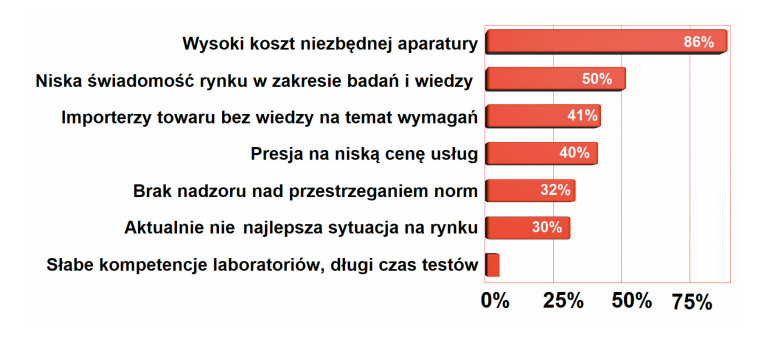

Główne czynniki oddziałujące negatywnie na rozwój rynku usług badawczych

Wysoki koszt aparatury pomiarowej niezbędnej do badań od lat jest na szczycie zestawienia najważniejszych czynników negatywnie oddziałujących na rozwój rynku usług badawczych. Zaawansowana aparatura jest bardzo kosztowna, wymaga okresowej kalibracji, a wyniki badań muszą być porównywane z innymi placówkami, co też jest kosztem. Ponieważ klienci żądają kompleksowości, sprzętu pomiarowego trzeba mieć na stanie dużo i stale w coś inwestować, aby dotrzymać kroku konkurencji, zmieniającym się normom i postępowi w technice. Z tej przyczyny najlepszy sprzęt mają placówki rządowe i uczelniane.

Walka o koszty prowadzi do działania "na krawędzi"

Ogólną regułą w projektowaniu elektroniki jest uzyskanie jak najlepszego balansu między kosztami oraz uzyskiwanym efektem. Odnosząc tę ogólną regułę do np. badań związanych z kompatybilnością elektromagnetyczną, można powiedzieć, że projektant będzie się starał zastosować w urządzeniu filtr sieciowy po to, aby ograniczyć przenikanie zaburzeń do sieci zasilającej. Niemniej skuteczność takiego filtru, a więc wielkość i koszt, trzeba dobrać tak, aby zmieścić się w narzuconym limicie z minimalnym zapasem (marginesem). Rozbudowany, skuteczny i drogi filtr zapewni oczywiście duży margines, ale nie będzie on wówczas opłacalny z punktu widzenia kosztu BOM. Stąd potrzebny jest taki element, aby zbić zaburzenia minimalnie poniżej limitu normy.

W efekcie walki o koszty wiele urządzeń jest zgodnych z wymaganiami, ale niekoniecznie z zapasem. Często ocena zgodności jest robiona na początku produkcji, a potem następuje kilkanaście zmian konstrukcyjnych i modernizacji. Trudności z dostępnością podzespołów nasiliły to zjawisko, że część hardware się często zmienia (są nowe rewizje) i jego skutkiem jest to, że często sprzęt nie spełnia wymagań. Bo był zaprojektowany na krawędzi, a potem przestał być kontrolowany. Stąd często biorą się problemy ze zgodnością w urządzeniach, które były badane i przeszły ścieżkę akceptacji.

Warto dodać, że inżynierowie także za bardzo wierzą w to, co widzą na ekranie, zapominając o niepewności pomiaru, dokładności przyrządów oraz samej specyfice realizowania badań. Potem często okazuje się, że u nich "jest dobrze", że sprzęt "w quasi-peakach przechodzi", a nadzór rynku ma inne zdanie. Czemu tak się dzieje, można opisać na przykładzie komory bezechowej.

Główne czynniki oddziałujące pozytywnie na rozwój rynku usług badawczych

Najważniejszy i wyraźnie wybijający się ponad resztę czynnik sprzyjający rozwojowi rynku usług badawczych w zakresie urządzeń elektronicznych to coraz większa świadomość rynku w zakresie konieczności badań urządzeń. Reszta też oczywiście ma znaczenie, niemniej jest ono równorzędne. Środowisko badawcze od zawsze przekonywało, że jego praca jest częścią zapewnienia wysokiej jakości urządzeń i z wykresu widzimy, że takie podejście trafia do świadomości.

Komora komorze nie jest równa

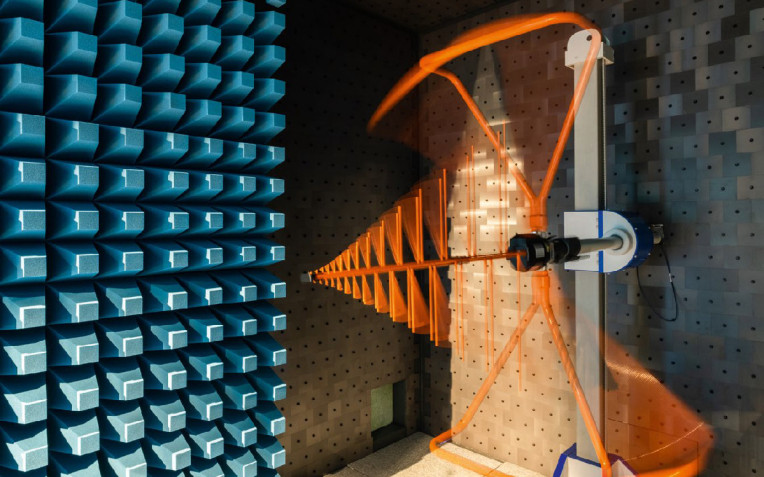

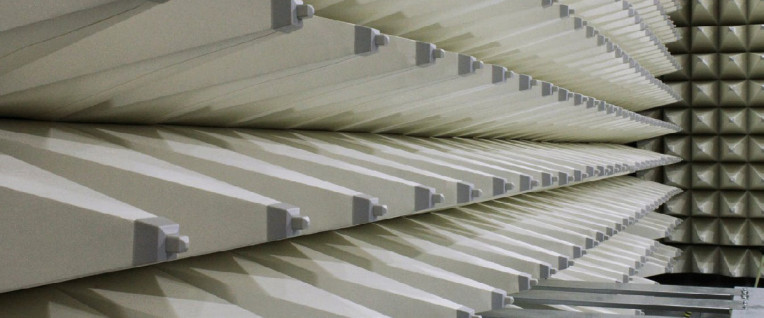

Pomiarów emisji EM dokonuje się w taki sposób, że badane urządzenie (DUT) umieszcza się wewnątrz ekranowanej elektromagnetycznie komory, w której w odległości 3 metrów jest realizowany pomiar. Urządzenie leży na drewnianym stoliku, a wytwarzane zaburzenia są przechwytywane przez kierunkową antenę połączoną z analizatorem widma. Pomiar realizowany jest z każdej strony i w tym celu urządzenie DUT się odwraca, np. kręcąc stolikiem. Odległość między DUT a anteną wynosi 3 metry, aby pomiar był realizowany w warunkach zbliżonych do rzeczywistej eksploatacji.

W takich warunkach komora tworzy duży i kosztowny obiekt. Musi być ona wykonana jako szczelna konstrukcja metalowa, którą następnie wykłada się ciężkimi płytkami ferrytowymi tłumiącymi promieniowanie w dolnym zakresie widma. Na nie mocowane są piramidalne absorbery tłumiące górną część widma. Razem zapewniają one, że do komory nie przedostaje się promieniowanie z zewnątrz, ale także nie ma odbić emisji z DUT. Na etapie budowy tłumienie jest kontrolowane, a anteny, kable i sam obiekt są kalibrowane za pomocą generatorów grzebieniowych o kulistej charakterystyce emisji.

Inne podejście zakłada wykorzystanie komory GTEM, znacznie mniejszej i niezawierającej takiego wielowarstwowego tłumika. Ma ona kształt ostrosłupa czworokątnego, w wierzchołku którego jest antena, a w centralnej części jest tzw. septum, czyli miejsce, gdzie umieszcza się DUT. W niej antena nie jest w odległości 3 m, tylko znacznie bliżej, samo urządzenie jest wielokrotnie mniejsze, stąd warunki pomiaru są inne i wyniki z takiego układu przeliczane są w oprogramowaniu na te zbliżone do wolnej przestrzeni. Oczywiście takie kalkulacje nie są dokładne, stąd w programie wyznaczane są marginesy błędów i poziomy ufności. Niemniej sprzęt zgodny "na styk" w takiej komorze niekoniecznie przejdzie badania w tej dużej, bo warunki są w niej inne.

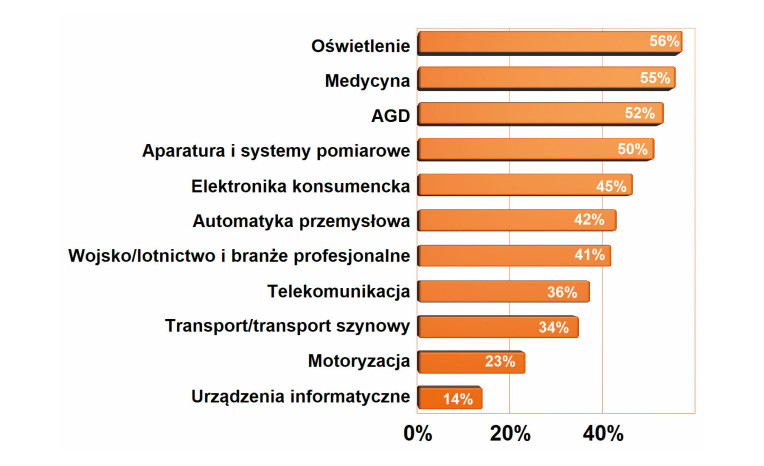

Które branże/grupy firm zlecają najczęściej badania do placówek?

W rankingu branży, które najczęściej korzystają z usług laboratoriów badawczych, czołówkę utworzyli producenci oświetlenia, branża medyczna i AGD. Do niedawna były one słabiej notowane i lokowały się mniej więcej w połowie zestawienia, ustępując miejsca szeroko rozumianemu przemysłowi. Może to być wynik zadyszki sektora przemysłowego w ostatnim czasie oraz rosnącej siły sektora oświetleniowego w Polsce, który szybko się rozwija i przynosi duże zyski.

Słaba propagacja wymagań i zmian w przepisach

Normy związane z oceną urządzeń zmieniają się co kilkanaście miesięcy. W ślad za postępem technicznym, nowymi technologiami konieczne są aktualizacje. Przygotowują je komitety techniczne, do których napływają uwagi środowiska branżowego, propozycje zmian, poprawki itd. Skutkiem jest pojawienie się dodatku, rewizji, a co parę lat całkowicie nowej edycji.

Przykładem może być norma bezpieczeństwa użytkowania EN60950, która funkcjonowała przez wiele lat i stała się kanonem oceny dla elektroniki zasilanej z sieci. Cztery lata temu norma ta została wycofana i na jej miejsce wprowadzono IEC/EN 62368-1, która była dużą zmianą jakościową w procesie oceny w kontekście podejścia do oceny poprzez analizę ryzyka. W kolejnym kroku zaczęły się pojawiać "rewizje", a w symbolu pojawiły się przyrostki roku, tak więc aktualnie mamy EN/ IEC 62368-1:2023.

Te zmiany są publikowane w Internecie na stronach Komisji Europejskiej, a autorami są zwykle IEC (Międzynarodowa Komisja Elektrotechniczna) oraz Cenelec (Europejski Komitet Normalizacyjny Elektrotechniki), ale w praktyce norm, poprawek, uzupełnień, raportów jest wiele i panowanie nad nimi zajmuje dużo czasu. W praktyce wiedzę o zmianach, czymś, co wchodzi, co zastąpiło co, jakie były zmiany, mają tylko specjaliści pracujący w laboratoriach i to w przypadku, gdy temat leży w ich zainteresowaniach zawodowych.

W typowym przypadku wiedza na temat aktualnych regulacji i zmian przenika do firm pocztą pantoflową, na bazie publikacji w mediach branżowych lub przy okazji konferencji i seminariów. Niestety nie dorobiliśmy się sprawnego systemu informowania środowiska branżowego o dziejących się zmianach formalnych i przyzwyczailiśmy się do tego, że na zmiany reagujemy z opóźnieniem, a nie przygotowujemy się do nich wcześniej.

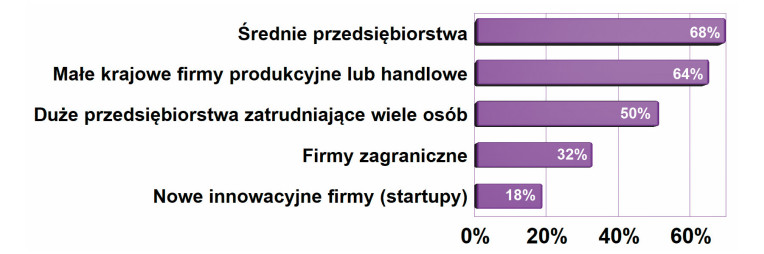

Typ przedsiębiorstw najczęściej zlecających badania

Głównym klientem dla placówek badawczych w Polsce są średnie przedsiębiorstwa krajowe, a w dalszej kolejności firmy małe. Działają one w takiej skali biznesu, że muszą dbać o długofalowe relacje z rynkiem i klientami i rozwój produktowy. Często takie firmy są powiązane z branżami profesjonalnymi (jak przemysł) i zagadnienia jakościowe są dla nich bardzo istotne. Duże przedsiębiorstwa mają na tyle duży potencjał, że często mają też własne laboratorium. Dawniej notowania dużych przedsiębiorstw były wyżej zarysowane, ale w ostatnich latach ich pozycja na wykresie obniża się. Prawdopodobnie właśnie z tej przyczyny.

Dlaczego sprzęt pomiarowy do EMC jest taki kosztowny?

Aby kontrolować jakiś parametr, posiadany przyrząd musi mieć odpowiednią klasę dokładności, np. o rząd wielkości lepszą rozdzielczość, zakres częstotliwości, plus stabilność długoi krótkoterminową i podobne własności. To w praktyce oznacza duże koszty, bo zaawansowana aparatura specjalistyczna, a więc produkowana w relatywnie małych seriach, jest bardzo droga. Taką aparaturę trzeba utrzymywać w jakości metrologicznej, czyli kalibrować i wzorcować, co w praktyce wymaga kupienia usługi, opłacenia transportu. Im więcej aparatury, tym większe koszty, stąd w praktyce koszt przyrządów ma duży wpływ na ceny usług.

Najbardziej złożone pod tym względem są badania kompatybilności elektromagnetycznej oraz urządzeń radiowych. Z tych przyczyn wielu producentów elektroniki mozolnie rozwija swój potencjał aparaturowy, a inwestycje często są współfinansowane z funduszy unijnych. W tych najbardziej zaawansowanych pomiarach dominują uczelnie i instytuty naukowe oraz placówki rządowe, które aparaturę do badań sprzętu elektronicznego kupują jako narzędzia do prowadzenia prac naukowych oraz do kształcenia studentów w ramach grantów badawczych lub też korzystają z programów edukacyjnych, jakie mają czołowi producenci sprzętu pomiarowego. Pozwalają one zgromadzić niezłe zaplecze pomiarowe, a dodatkowo kadra naukowa jest w stanie zapewnić wysoki poziom kompetencji badawczych.

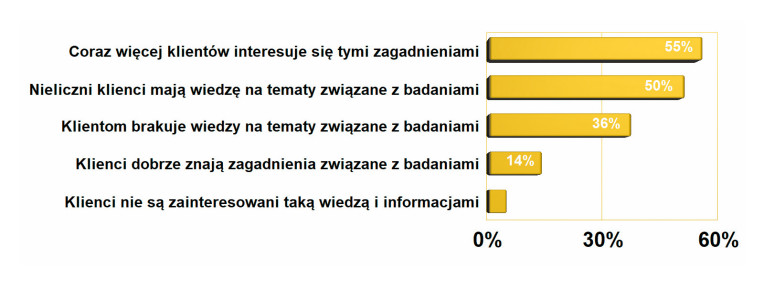

Ocena wiedzy firm na temat badań, norm i wymagań

Ocena wiedzy firm na tematy związane z badaniami urządzeń elektronicznych przedstawiona na wykresie wskazuje, że cały czas znajomość zagadnień technicznych i prawnych związanych z badaniami urządzeń elektronicznych i oceną zgodności z dyrektywami UE nie jest najlepsza. Co więcej, podobnie wyszło nam w ankietach przeprowadzanych dwa i cztery lata temu, co przekonuje, że mamy problem i dużo do nadrobienia. Pozytywną wiadomością jest to, że zainteresowanie branży jest podobne, jak chęć pogłębiania wiedzy. Widać to w zainteresowaniu publikacjami, seminariami poświęconymi tematyce EMC.

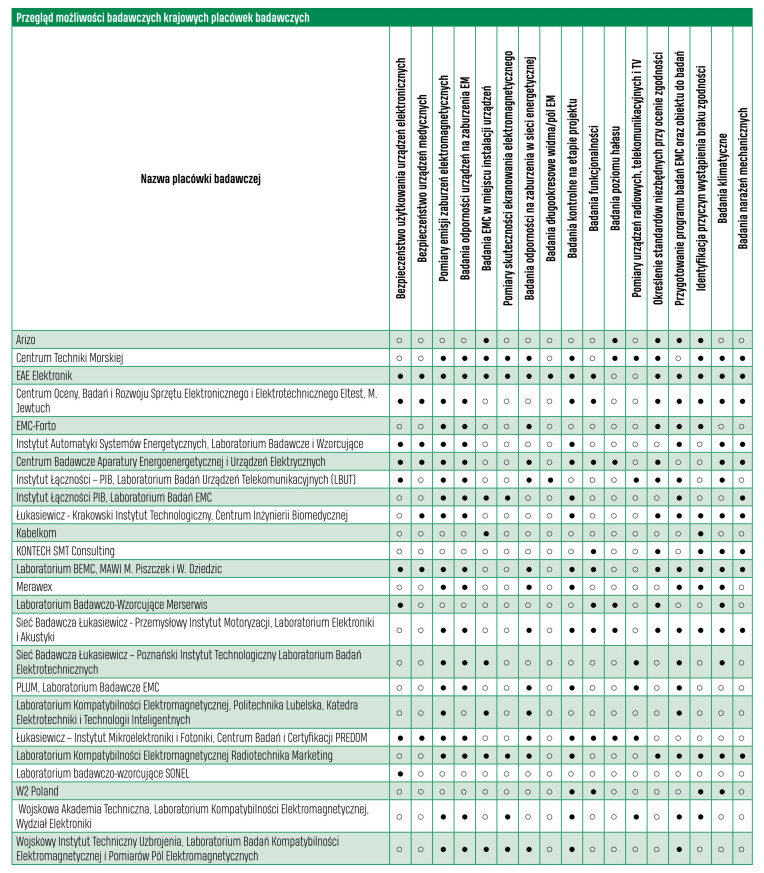

Placówki badawcze

Placówki badawcze zaliczają się w większości do jednej z trzech grup profilowych. Pierwszą tworzą jednostki przynależne do uczelni lub instytutu badawczego. Laboratoria takie są znakomicie wyposażone w aparaturę, mają kompetentną kadrę techniczną i w coraz większym stopniu otwierają się na współpracę z przemysłem.

Uczelnie i instytuty naukowe aparaturę do badań sprzętu elektronicznego kupują jako narzędzia do prowadzenia prac naukowych oraz do kształcenia studentów w ramach grantów badawczych lub też korzystają z programów akademickich producentów aparatury i oprogramowania. Pozwalają one zgromadzić niezłe zaplecze pomiarowe, a dodatkowo kadra naukowa jest w stanie zapewnić wysoki poziom kompetencji badawczych.

Drugą grupę tworzą działy badawcze istniejące przy producentach elektroniki, których laboratoria są częścią działalności badawczo-rozwojowej, zapewnienia jakości i kontroli produkcji. Takich działów w kraju mamy wiele, ale tylko część firm jest otwarta na klientów z zewnątrz. Ich oferta badań zwykle jest pochodną działalności produkcyjnej i dotyczy badań bezpieczeństwa, klimatycznych, wzorcowania i kalibracji aparatury pomiarowej.

Trzecią grupę tworzą dostawcy produktów związanych z kompatybilnością EMC, dystrybutorzy, którzy mają kompetencje, kontakty oraz wiedzę w tym zakresie oraz będące w zdecydowanej mniejszości laboratoria niezależne. Z reguły są to placówki bez akredytacji, skupiające się na wsparciu dla projektantów.