Pętlę prądową 4‒20 mA zaczęto wykorzystywać w latach 50. zeszłego wieku. Zastąpiła sygnały pneumatyczne 3‒15 psi (0,2‒1 bar) i szybko stała się dominującym analogowym standardem transmisji sygnałów w przemyśle. Z upływem lat wcale nie straciła na popularności. Wciąż jest to powszechny sposób konwersji sygnałów reprezentujących różne wielkości procesowe, na przykład temperaturę, ciśnienie, przepływ czy poziom, na sygnał elektryczny. To umożliwia ich przesyłanie nawet na spore odległości praktycznie bez strat.

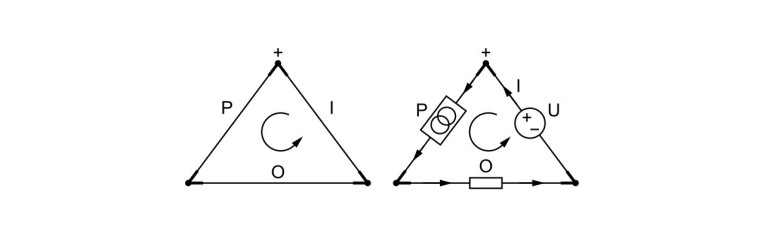

Na rysunku 1 przedstawiono uproszczony model koncepcyjny pętli prądowej. Ma on postać trójkąta. Każdy jego bok reprezentuje komponent pętli, a jego wierzchołki – połączenia przewodowe między nimi. W modelu tym lewy bok trójkąta, oznaczony literą P, odnosi się do przetwornika. Podstawa figury, podpisana literą O, oznacza odbiornik. Prawy bok trójkąta, oznaczony jako I, reprezentuje źródło prądu.

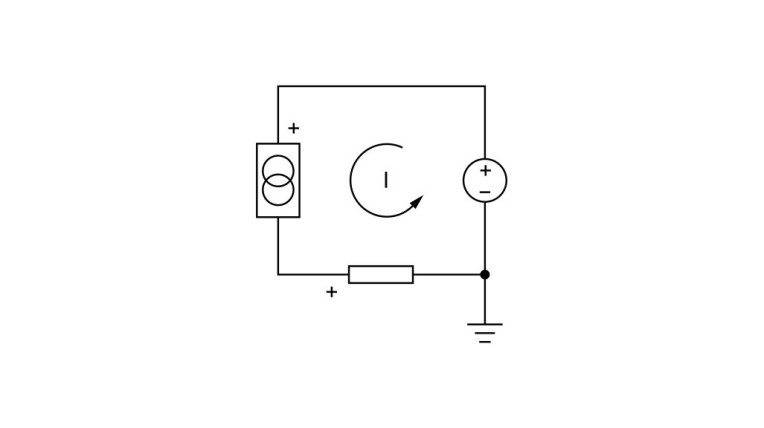

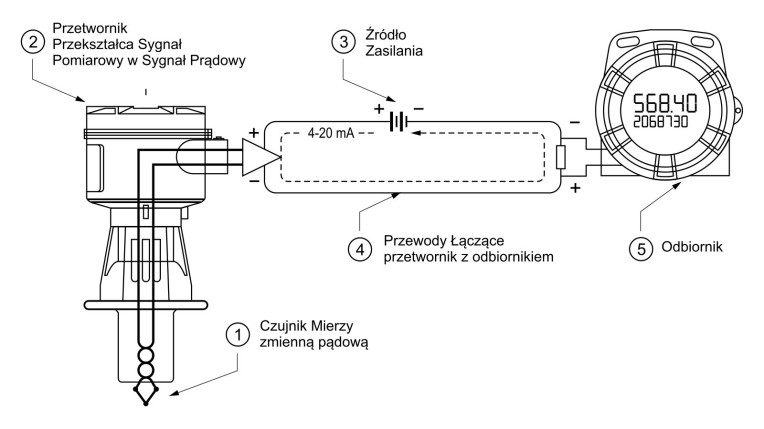

Na rysunku 2 przedstawiono schemat prostej pętli 4‒20 mA. Warto doprecyzować, że przetwornik nie jest źródłem prądu, ale odpowiada za regulację jego natężenia w zależności od wartości wielkości wejściowej, którą jest zwykle sygnał z czujnika. Prąd ten, płynąc przez odbiornik, powoduje spadek napięcia, który jest mierzony. Aby dokładniej wyjaśnić działanie pętli prądowej, najlepiej rozważyć każdy z jej komponentów: źródło zasilania, odbiornik, przetwornik i przewody, oddzielnie (rys. 3).

Komponenty pętli prądowej

Pętla prądowa zasilana jest ze źródła prądu stałego o napięciu najczęściej 24 V, chociaż spotykane są wartości 12 V, 15 V, 36 V, a w starszych realizacjach nawet jeszcze wyższe. Ważne, aby napięcie zasilania zostało dobrane odpowiednio większe (z zachowaniem wystarczającego zapasu) niż suma minimalnego napięcia wymaganego do działania przetwornika i spadku napięcia w odbiorniku. W przypadku dużych odległości transmisji trzeba w tym bilansie uwzględnić również spadek napięcia na przewodach. Obliczając spadki napięć, należy wziąć pod uwagę maksymalny prąd, jaki może płynąć w danej pętli – wbrew pozorom nie jest to 20 mA, ale wartość wyższa, która sygnalizuje przekroczenie skali albo błąd przetwornika. Problemy w działaniu pętli prądowych są przeważnie spowodowane właśnie zbyt niskim napięciem zasilania w stosunku do ich dodatkowego obciążenia w związku z nieuwzględnieniem spadków napięcia na długich przewodach albo z przyjęciem w obliczeniach zbyt niskiej wartości prądu maksymalnego.

Ponieważ łatwiej jest mierzyć napięcie, niż prąd, odbiornikiem w pętli prądowej jest rezystor, a w praktyce przeważnie wejście o określonej impedancji na przykład miernika panelowego, sterownika zaworu, sterownika PLC. Odbiornik przedstawia się więc jako rezystancję połączoną równolegle z woltomierzem. Napięcie, które odkłada się na oporniku w odbiorniku, można łatwo skalować przez zmianę rezystancji. Jej typowe wartości to 250 Ω (1‒5 V), 500 Ω (2‒10 V), 50 Ω (0,2‒1 V) oraz 100 Ω (0,4‒2 V). W zależności od źródła prądu w pętli odbiorniki są klasyfikowane jako aktywne (zasilające pętlę) i pasywne (zasilane z pętli). Można podłączyć szeregowo kilka odbiorników, o ile uwzględni się spadki napięć, które na nich wystąpią.

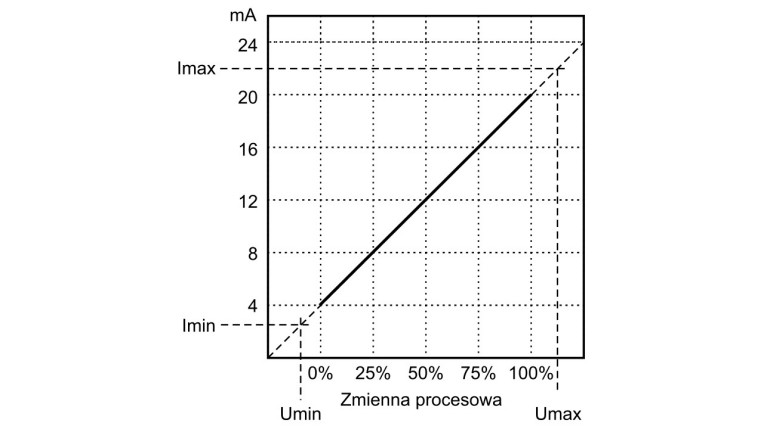

Natężenie prądu pętli jest regulowane przez przetwornik tak, żeby zmieniało się proporcjonalnie do sygnału z czujnika w zakresie od 4 do 20 mA. Zazwyczaj wartość 4 mA odpowiada zeru albo 0% zmiennej procesowej, a 20 mA wartości maksymalnej albo 100%. Przykład takiej charakterystyki przedstawiono na rysunku 4. Związek pomiędzy wartością prądu wyjściowego przetwornika a wartością zmiennej procesowej jest ustalany w czasie jego kalibracji. Bywa nawet odwrócony względem tego ogólnie przyjętego i wówczas 4 mA odpowiadają wartości maksymalnej, a 20 mA – wartości minimalnej zmiennej procesowej.

Często ignorowanym komponentem pętli prądowej są przewody. Spadki napięcia na tych krótkich rzeczywiście można pominąć. Wpływ tych dłuższych na działanie pętli trzeba jednak, jak pisaliśmy, uwzględnić. Przykładowo przy napięciu zasilania 24 V, jeżeli przetwornik wymaga 8 V, spadek napięcia na przewodach wynosi 1,73 V, a maksymalny prąd pętli 22 mA, maksymalną rezystancję odbiornika można obliczyć z prawa Ohma: (24 V‒ 8 V‒ 1,73 V)/0,022 A = 648 Ω. Jeżeli chcemy podłączyć więcej niż jeden odbiornik, suma ich rezystancji też nie może przekroczyć tej wartości.

Dlaczego nie 0?

Pytaniem, które od razu nasuwa się w przypadku pętli prądowej, jest to, dlaczego wykorzystywana jest dwupunktowa charakterystyka 4‒20 mA, a nie 0‒20 mA. Okazuje się, że z kilku powodów sygnał 0 mA jest w praktyce nieużyteczny. Dlatego standardem stał się przedział 4‒20 mA.

Jak pisaliśmy, przed wprowadzeniem pętli prądowej korzystano z sygnałów pneumatycznych 3‒15 psi. W tym przypadku również nie zdecydowano się na rozszerzenie tego zakresu w dół, do 0 psi. Wynikało to stąd, że ciśnienia poniżej 3 psi były trudno mierzalne. W efekcie realizacja systemu ich detekcji byłaby bardzo kosztowna. Ponadto, jeżeli poziom ciśnienia 3 psi odpowiadał 0% zmiennej procesowej, kiedy sygnał spadał do zera, oznaczało to wystąpienie usterki. Ułatwiało to wykrywanie awarii. Kiedy pętla prądowa zaczęła wypierać sygnały pneumatyczne, kierowano się analogicznymi powodami.

Sygnał 0 mA oznaczałby w praktyce obwód otwarty, w którym prąd nie płynie. Detekcja takiego stanu, jak i wykrywanie i rozróżnianie niskich wartości prądu byłyby trudne i kosztowne. Ponadto niemożliwe byłoby odróżnienie zerowego wyniku pomiaru od usterki, na skutek której sygnał spada do zera. Zaletą pętli prądowej 4‒20 mA jest właśnie odrębność dwóch stanów: live zero, w którym sygnał 4 mA odpowiada 0% zmiennej procesowej i dead zero, w którym mamy 0 mA, na skutek na przykład przerwania przewodów lub ich nieprawidłowego połączenia. Ważne jest także to, że w pętli 0‒20 mA przy dolnej wartości tego zakresu nie działałyby urządzenia, które są zasilane z pętli (przetwornik, wyświetlacze itp.).

Zalety pętli prądowej

Pętle prądowe 4‒20 mA stały się powszechnym standardem w przemyśle dzięki kilku zaletom. Największą z nich jest wysoka odporność na zaburzenia – szumy z typowych źródeł, o wartości rzędu kilkuset mikroamperów, nie wpływają w istotny sposób na sygnały na poziomie tych w pętli. Oprócz tego live zero poprawia stosunek sygnału do szumu, umożliwiając rozróżnianie sygnałów o niskich wartościach. Jest to kluczowa cecha zwłaszcza w przypadku transmisji na duże odległości w trudnych warunkach przemysłowych.

Kolejną zaletą jest bezstratność pętli prądowej. Dla sygnałów prądowych medium transmisyjne nie jest źródłem strat, inaczej niż dla sygnałów napięciowych, w przypadku których nieuniknione są straty w związku ze spadkami napięć na okablowaniu. Pętla prądowa umożliwia również szeregowe podłączenie dodatkowych urządzeń odbiorczych bez utraty sygnału.

Poza tym, jak pisaliśmy, uszkodzoną pętlę prądową można od razu wykryć, kiedy prąd przestaje płynąć. Przesunięcie sygnału względem zera pozwala też na ustalenie kilku poziomów alarmowych przy natężeniu prądu poniżej 4 mA, ale większym od zera, co umożliwia odbiornikom rozróżnianie awarii różnych typów. Live zero o wartości 4 mA pozwala również na zasilanie z pętli prądowej na przykład przetwornika, co upraszcza instalację i obniża koszty.

HART

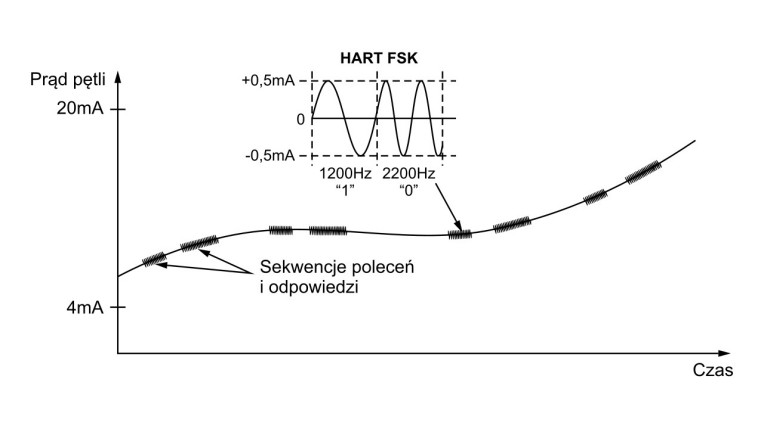

Protokół HART (Highway Addressable Remote Transducer) – wciąż popularny, choć coraz częściej zastępowany przez nowsze rozwiązania – stanowi "nakładkę" na pętlę prądową 4‒20 mA. Umożliwia on dwukierunkową cyfrową komunikację między urządzeniami. Pozwala to na przykład na zdalne zarządzanie nimi. Oprócz głównej zmiennej procesowej reprezentowanej przez prąd, jak temperatura czy ciśnienie, przetwornik może również w odpowiedzi na zdalne zapytanie przesyłać informacje diagnostyczne o swoim stanie. Za pośrednictwem protokołu HART mogą być ponadto wysyłane polecenia m.in. testowania pętli prądowej, zmiany jej zakresu, kalibracji.

W jego standardowej wersji wykorzystuje się modulację FSK (rys. 5), w której bity informacji są reprezentowane przez sygnały o różnej częstotliwości. Uzyskuje się wtedy prędkość transmisji 1200 b/s. Alternatywą jest modulacja C8PSK (Coherent 8-way PSK). Wykorzystuje się w niej nośną o częstotliwości 3200 Hz, zaś bity danych koduje się przez przełączanie fazy pomiędzy 8 wartościami. Zwiększa to prędkość transmisji do 9600 b/s. Pakiety danych w standardzie HART są przesyłane nie tylko za pośrednictwem pętli prądowej, ale również łączy RS-485.

RS-485

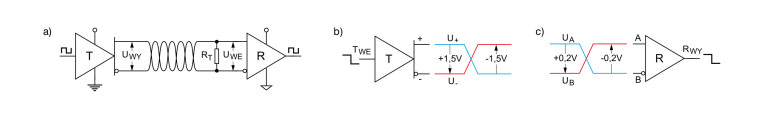

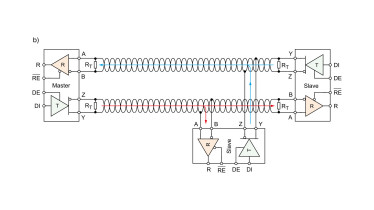

RS-485 to standard transmisji szeregowej. Do przesyłu sygnału różnicowego wykorzystuje skrętkę, co zapewnia wysoką odporność na zaburzenia z zewnątrz. Łączy ona nadajnik (T) z odbiornikiem (R) (rys. 6 a). To medium transmisyjne, o impedancji charakterystycznej Z0 = 120 Ω, po stronie odbiornika zakończone jest rezystorem dopasowującym (RT). Jego rezystancja powinna spełniać warunek RT = Z0.

Nadajnik konwertuje poziomy logiczne na wejściu (TWE) na różnicowe napięcia wyjściowe UWY ≥ ±1,5 V (rys. 6 b). Ma wyjście nieodwracające (+), w fazie z wejściem i wyjście odwracające (–), o fazie przeciwnej. Napięcie wyjściowe określa zależność: UWY = U+ – U–. Jeżeli zatem U+ > U–, UWY ≥ +1,5 V, a jeśli U+ < U–, UWY ≤ –1,5 V.

Odbiornikiem (rys. 6 c) jest komparator wykrywający różnicowe napięcie wejściowe (UWE = UA – UB) o wartości od ±0,2 V i konwertujący je na poziomy logiczne na wyjściu (RWY). Ma wejście nieodwracające (A), w fazie z wyjściem i wejście odwracające (B), o fazie przeciwnej. Jeżeli UWE ≥ +0,2 V, RWY = 1 (poziom wysoki). Jeżeli UWE ≤ –0,2 V, RWY = 0 (poziom niski).

Odbiornik wykrywa tylko różnicę napięć między wejściami, ignorując wszelkie napięcia wspólne, tj. współdzielone przez oba wejścia względem masy. Skrętka ma w związku z tym tę zaletę, że jej przewody są w równym stopniu narażone na zaburzenia zewnętrzne. W każdym indukują więc one takie samo napięcie (szum wspólny), które jest przez odbiornik różnicowy pomijane.

Funkcje nadajnika i odbiornika realizuje się w oddzielnych komponentach albo łączy się w jednym układzie transceivera. Po zmianie stanu odpowiedniego wejścia ten ostatni przełącza się, aktywując tryb nadawania lub odbioru.

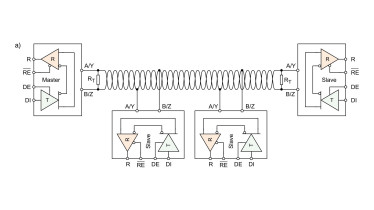

Transmisja w sieci RS-485

W magistrali RS-485 wyróżnia się jeden węzeł główny (master), który komunikuje się z wieloma węzłami podrzędnymi (slave). Węzeł główny zawsze inicjuje transfer danych. Węzły podrzędne odbierają od niego komunikaty i, jeżeli otrzymają takie polecenie, odpowiadają mu. Każdy węzeł powinien zatem mieć możliwość odbioru i wysyłania danych. Dlatego magistrala RS-485 jest określana jako wielopunktowa.

Obsługiwana jest transmisja w trybach half-dupleks i full-dupleks. W pierwszym węzeł wysyła albo odbiera komunikaty, ale nie jednocześnie. Wymaga to pojedynczego kabla. Z tego trybu korzysta się głównie w transmisji na większe odległości (do 1200 m), ale przy stosunkowo małej szybkości transmisji danych, do 100 kb/s (rys. 7 a). Z kolei w trybie pełnodupleksowym węzeł może wysyłać i odbierać dane jednocześnie. To znacząco zwiększa przepustowość. Z drugiej strony wymagane są dwa kable. Z tego powodu prowadzenie okablowania na dużych odległościach jest zbyt kosztowne. Przez to zastosowanie trybu full-dupleks jest ograniczone do transmisji na dystansach do 30 m, ale za to z szybkością do 50 Mb/s (rys. 7 b).

Zaletą magistral RS-485 jest prostota transceiverów i okablowania. Dzięki temu mają niskie koszty wdrożenia w porównaniu z innymi. Ponieważ zestandaryzowane zostały tylko ich charakterystyki elektryczne (warstwa fizyczna), opierają się na nich protokoły komunikacyjne wyższych warstw modelu OSI, jak popularny w automatyce przemysłowej Modbus.

Ethernet jednoparowy

Idea Przemysłu 4.0 zakłada połączenie obiektów rzeczywistych w różnej skali, od zakładów, przez maszyny, sterowniki, siłowniki, czujniki oraz narzędzia, po produkty, z technologiami cyfrowymi. Warunkiem zrealizowania tego celu jest zapewnienie ciągłości komunikacji pomiędzy wszystkimi poziomami piramidy automatyzacji, od tych najniższych, na których pracują urządzenia polowe i sterowniki, po najwyższe, które obejmują monitorowanie procesów (systemy SCADA), zarządzanie operacyjne (systemy MES), planowanie biznesowe i logistykę (systemy ERP) oraz chmurę. Problemem jest niestety niezgodność ich standardów transmisji danych – podczas gdy na wyższych poziomach dominuje Ethernet, na niższych wymiana informacji odbywa się w ramach sieci polowych, często w dalszym ciągu analogowo.

W odpowiedzi na potrzebę ujednolicenia komunikacji w przemyśle, a równocześnie jako bardziej kompaktowego następcę magistrali CAN, o większej przepustowości wymaganej w samochodach elektrycznych i przede wszystkim autonomicznych, opracowano standard Ethernetu jednoparowego. W SPE (Single Pair Ethernet) medium transmisyjnym jest pojedyncza dwuprzewodowa skrętka. W związku z dużymi nadziejami, jakie są pokładane w Ethernecie jednoparowym jako dominującym sposobie transmisji danych w inteligentnych cyfrowych fabrykach i nowoczesnych pojazdach, standaryzacja SPE cały czas postępuje, a produkty z takim interfejsem komunikacyjnym są już dostępne na rynku.

Standardy SPE

Jak do tej pory opracowano kilka standardów Ethernetu jednoparowego, a prace nad kolejnymi są w toku. Poszczególne specyfikacje są dedykowane konkretnym zastosowaniom.

Pierwszym standardem SPE był IEEE 802.3bw (100BASE-T1) wydany w 2015 roku. Definiował komunikację w architekturze point to point (P2P) o szybkości transmisji do 100 Mb/s na odległość do 15 m. Został opracowany z myślą o wykorzystaniu w samochodach.

W 2016 roku została ogłoszona wersja IEEE 802.3bp (1000BASE-T1). Zakłada ona transmisję z szybkością do 1 Gb/s, także w topologii P2P. W specyfikacji wyróżniono dwa typy: A, do przesyłu danych w obrębie aut z wykorzystaniem nieekranowanych kabli na odległości do 15 m oraz B, dla kabli ekranowanych o długości do 40 m, do wykorzystania w przemyśle.

Specyfikację IEEE 802.3cg, która obejmuje wersje 10BASE-T1S, 10BASE-T1M i 10BASE-T1L, wydano w 2019 roku. 10BASE-T1S definiuje komunikację w topologiach P2P i wielopunktowej na odległości do 15 m, a 10BASE-T1M – w topologii wielopunktowej o zasięgu co najmniej 25 m. Prędkości transmisji w obu przypadkach sięgają 10 Mb/s. Obie te wersje sprawdzają się w łączności w pojazdach, jak i w Przemysłowym Internecie Rzeczy. Umożliwiają także jednoczesną transmisję danych i zasilania dzięki technice PoDL (Power over Data Line), podobnie jak wersja 10BASE-T1L. Ta z kolei dopuszcza transmisję na odległość do 1 km w topologii P2P, także z prędkością 10 Mb/s.

Standard 802.3ch Multi-Gigabit Ethernet (10G/5G/2.5GBASE-T1) przewiduje przesyłanie danych z prędkościami 2,5 Gb/s, 5 Gb/s i 10 Gb/s na odległość 15 m. Specyfikacja ogłoszona w 2020 została opracowana pod kątem wykorzystania w pojazdach, by umożliwić obsługę zaawansowanych funkcji systemów wspomagania kierowcy, a w przyszłości przetwarzanie w czasie rzeczywistym wideo w wysokiej rozdzielczości, co będzie wymagane w pojazdach autonomicznych.

802.3da, wydany w 2023 roku, rozszerza możliwości wersji 10BASE-T1M, podwajając odległość transmisji do 50 m i dodając możliwość korzystania z mechanizmu dynamicznego PLCA (Physical Layer Collision Avoidance). Z kolei 802.3de ma rozszerzyć wersję 10BASE-T1L o zgodność z TSN (Time-Sensitive Networking) przy szybkości transmisji do 10 Mb/s na odległość co najmniej 500 m.

Jeżeli chodzi o okablowanie i złącza, to norma IEC 61156 klasyfikuje kable Ethernetu jednoparowego według typu instalacji, maksymalnej długości łącza i szybkości transmisji danych, natomiast złącza SPE są standaryzowane w normie IEC 63171.

Czym jest PLCA?

Ważną koncepcją w SPE jest PLCA. Jest to technika, której celem jest osiągnięcie determinizmu czasowego w sieciach wielopunktowych wykorzystujących mechanizm CSMA/CD. Zapewnia on losowe opóźnienia, które są powodowane możliwością wystąpienia kolizji danych, przez co nie jest odpowiedni w przypadku wielu zastosowań w automatyce przemysłowej ani w sterowaniu samochodami autonomicznymi. PLCA, gwarantując maksymalne opóźnienie, niweluje ograniczenia CSMA/CD, a jednocześnie zwiększa przepustowość sieci. W uproszczeniu jest to jakby nakładka na mechanizm CSMA/CD. Ten wprawdzie dalej kontroluje dostęp do medium transmisyjnego, ale PLCA zarządza przesyłaniem danych w taki sposób, by uniknąć ich kolizji.

Celem jest dynamiczne tworzenie możliwości (okienek) transmisji tak, by w konkretnym momencie wyłącznie jeden węzeł mógł skorzystać z medium do przesłania swojego pakietu danych. W PLCA osiąga się to w następujący sposób: każdy węzeł ma przypisany numer identyfikacyjny, węzeł o numerze 0 uzyskuje status koordynatora, cykl transmisji jest inicjowany, gdy koordynator wysyła specjalny komunikat. Pozostałe węzły synchronizują z nim swoje zegary. Cykl rozpoczyna okno czasowe 25 μs, które koordynator otwiera dla węzła o numerze 1. Przez ten czas może on wysłać swoje dane. Pozostałe węzły nasłuchują. Węzeł numer 2 zaczyna nadawać, kiedy wykryje, że ten z numerem 1 zakończył transmisję lub jeśli dobiegło już końca przypisane mu okno czasowe. Proces ten jest powtarzany – kolejne węzły nasłuchują, kiedy węzeł o numerze o jeden niższym od ich numeru przestaje nadawać albo mija przydzielone mu 25 μs. Cykl dobiega końca, gdy wszystkie węzły miały już okazję wysłać swoje pakiety. Wówczas koordynator inicjuje kolejny.

Opóźnienia transmisji w przypadku mechanizmu PLCA zależą od liczby węzłów. Wyróżnia się trzy sytuacje: minimalne opóźnienie występuje, jeżeli żaden węzeł w danym cyklu nie nadaje, średnie, gdy część węzłów wysyła pewną ilość danych, a maksymalne wtedy, gdy wszystkie węzły wysyłają pakiety o maksymalnym rozmiarze. Dzięki temu, że PLCA zapobiega fizycznym kolizjom danych w medium, transmisja nie jest przerywana. Ewentualne logiczne kolizje powodowane buforowaniem danych zachodzą wyłącznie w węzłach lokalnych zanim dojdzie do jakakolwiek fizycznej transmisji. Poza tym dzięki PLCA nie jest wymagany switch, co wpływa na obniżenie kosztów infrastruktury sieciowej.

Na czym polega PoDL?

Kolejny skrót wymieniany w specyfikacjach Ethernetu jednoparowego, który warto rozszyfrować, to PoDL. Jest to technika jednoczesnej transmisji danych i zasilania. Taka funkcjonalność od razu kojarzy się ze standardem PoE (Power over Ethernet). I rzeczywiście, PoDL, nazywany również SPoE (Single-pair Power over Ethernet), rozszerza tę koncepcję na Ethernet jednoparowy. Generalnie między tymi dwoma rozwiązaniami istnieją podobieństwa. PoDL i PoE umożliwiają zasilanie urządzeń przez Ethernet, jak również obsługują mechanizmy detekcji i klasyfikacji, umożliwiające odróżnienie urządzenia kompatybilnego z PoDL lub PoE od takiego, które nie może być tą drogą zasilane i doboru mocy zasilania właściwej dla danego odbiornika. Jest to konieczne, aby zapobiec jego uszkodzeniu. Sposób implementacji tych funkcjonalności jest jednak w przypadku obu standardów różny.

Jeśli chodzi o mechanizm detekcji, to w przypadku urządzenia zasilającego PoE PSE (Power Sourcing Equipment) mierzona jest rezystancja podłączonego urządzenia zasilanego PD (Powered Device), natomiast PoDL PSE po stronie PD wykrywa diodę Zenera. Z kolei w zakresie klasyfikacji PoE opiera się na rozwiązaniu analogowym – prąd pobierany przez PD definiuje klasę mocy, PoDL zaś wykorzystuje podejście cyfrowe – PSE i PD komunikują się za pośrednictwem protokołu SCCP (Serial Communication Classification Protocol).

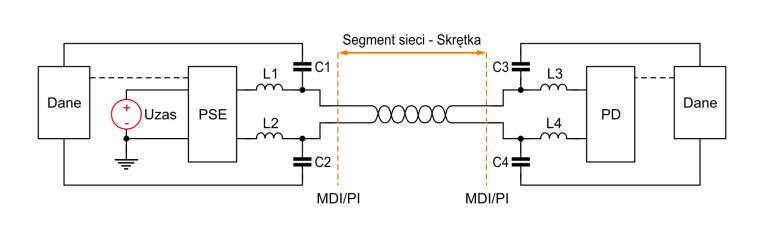

Poza tym w PoDL wprowadzono unikalną technikę sprzęgania mocy i danych w pojedynczej parze przewodów. W PoE zasilanie i dane są przesyłane jednocześnie oddzielnymi parami przewodów, zaś w SPoE są dipleksowane (separowane ze względu na częstotliwość) w pojedynczej skrętce. W związku z tym częścią PSE i PD zgodnych z PoDL jest interfejs MDI/PI (Media-Dependent Interface / Port interface) z obwodami odsprzęgania (rys. 8) danych – pojemnościowo (C1 – C4) i zasilania – indukcyjnie (L1 – L4).

DALI

DALI (Digital Addressable Lighting Interface), a w najnowszej wersji DALI-2, to protokół do cyfrowego sterowania oświetleniem oparty na standardzie IEC 623861. Zakłada wykorzystanie dwuprzewodowej magistrali do przesyłania poleceń i danych, jak również zasilania podłączonych urządzeń. DALI początkowo został opracowany z myślą o cyfrowym sterowaniu i konfigurowaniu stateczników lamp fluorescencyjnych, jako alternatywa dla prostej, jednokierunkowej analogowej komunikacji rozgłoszeniowej w standardzie 0/1‒10 V. W DALI transmisja rozgłoszeniowa wciąż jest obsługiwana, ale dostępna jest poza tym możliwość przypisania urządzeniom podłączonym do magistrali oddzielnych adresów. To pozwala sterować nimi niezależnie.

Urządzenia można grupować. Dzięki temu instalacje oświetleniowe są łatwo rekonfigurowalne programowo, bez konieczności dokonywania zmian fizycznych połączeń. Pozwala to na niezależne sterowanie oświetleniem na przykład w poszczególnych pomieszczeniach czy częściach budynku. Dwukierunkowa komunikacja pozwala także urządzeniom na zgłaszanie awarii i odpowiadanie na zapytania o ich status. Wyróżnikiem DALI jest ponadto prostota okablowania. Poza możliwością wykorzystania jednej pary przewodów do przesyłu danych i zasilania ważne jest to, że polaryzacja przewodów nie musi być przestrzegana, w przeciwieństwie do systemów 0/1‒10 V, w których błędne podłączenia są powszechne. Ze względu na małą prędkość transmisji okablowanie magistrali DALI nie wymaga też ekranowania.

Komponenty DALI

W IEC 623861 zdefiniowano trzy podstawowe typy komponentów: zasilacze, sterowniki i elementy sterujące. Możliwe są różne ich kombinacje w ramach jednego urządzenia.

Magistrala DALI wymaga zasilania o napięciu 16 V. Zasilacz musi dostarczać prąd do 250 mA. Jest to maksymalne dozwolone natężenie. Do drugiej kategorii zalicza się na przykład sterowniki LED w oprawie, w tym te umożliwiające zmianę koloru oświetlenia czy stateczniki lamp fluorescencyjnych. Elementy sterujące klasyfikuje się natomiast na: kontrolery aplikacji oraz urządzenia wejściowe.

Te pierwsze analizują dane z różnych źródeł, którymi mogą być sterowniki, urządzenia wejściowe, inne kontrolery aplikacji, zewnętrzne urządzenia albo sieci i wysyłają polecenia w celu sterowania, konfigurowania, odpytywania sterowników lub innych urządzeń, które są podłączone do magistrali DALI. Kontrolery aplikacji przeważnie obsługują określone urządzenia wejściowe oraz komunikaty zdarzeń.

Urządzenia wejściowe dostarczają informacji o zdarzeniach i/albo wyniki pomiarów. Dane te mogą pochodzić na przykład z przycisków, detektorów obecności, sensorów światła, pokręteł, suwaków, czujników temperatury. Urządzenia wejściowe nie mogą bezpośrednio sterować oświetleniem. Jest to zadaniem kontrolerów aplikacji. Wiele wejść może współdzielić magistralę DALI. Urządzenia wejściowe składają się z jednej albo z większej liczby instancji różnych typów (maksymalnie 32) identyfikowanych jednym adresem – na przykład może to być czujnik obecności i najwyżej 31 przycisków.

Topologie. Adresowanie

Magistrala może być zorganizowana w topologię szeregową, gwiazdy lub ich kombinacje. Nie jest dopuszczalne łączenie węzłów w pętli zamkniętej. Zaleca się stosowanie przewodów o średnicy 1,5 mm². Maksymalna odległość między dwoma najbardziej oddalonymi od siebie urządzeniami to 300 m (przy maksymalnym prądzie 250 mA). Warunek ten spełnia na przykład umieszczenie kontrolera aplikacji i zasilacza magistrali w centrum w topologii gwiazdy, jeżeli długość każdej gałęzi nie przekracza 100 m od kontrolera aplikacji. To daje maksymalnie 200 m między dowolnymi dwoma urządzeniami.

W pojedynczej magistrali DALI obsługiwane są 64 adresy dla sterowników i także 64 adresy dla elementów sterujących. Pierwsze można podzielić na 16 grup. Każdy sterownik może należeć do dowolnej ich kombinacji. W przypadku elementów sterujących dopuszczalne jest stworzenie aż 32 grup. Podobnie jak w przypadku sterowników, każdy element sterujący może należeć do dowolnej kombinacji grup. Również instancje, takie jak pojedyncze przyciski w panelu, można sklasyfikować na 32 grupy, ale każda z nich może należeć maksymalnie do 3 z nich.

Niektóre urządzenia, zwłaszcza sterowniki, mogą używać więcej niż jednego adresu. Przykładem jest sterownik LED, za pośrednictwem którego sterowane są niezależnie dwie lampy. Oznacza to, że obsługuje on dwie, oddzielne adresowane, jednostki logiczne.

Monika Jaworowska