Podstawowymi komponentami systemów chłodzenia centrów danych są CRAC (Computer Room Air Conditioner) i CRAH (Computer Room Air Handler). Pierwsze to klimatyzatory projektowane pod kątem wymagań kontroli temperatury i wilgotności powietrza w tego typu obiektach. Pracują w typowym cyklu chłodniczym – nagrzane powietrze jest schładzane podczas nadmuchiwania na wężownicę wypełnioną czynnikiem chłodniczym, cyklicznie sprężanym i rozprężanym, który parując, odbiera nadmiar ciepła. Klimatyzatory CRAC sprawdzają się w małych centrach danych. Ich zaletą jest przystępna cena. Główne wady to natomiast: duży pobór energii, złożona konserwacja, trudności z dostosowaniem do zmiennego obciążenia cieplnego i ze skalowaniem w razie rozbudowy obiektu.

W średnich i dużych centrach danych korzysta się z central chłodniczych CRAH. Zamiast czynnika chłodniczego używa się w nich wody lodowej z oddzielnego źródła. W porównaniu z CRAC mają one większy koszt początkowy, przez co zwykle nie są opłacalne w małych centrach danych. W dłuższej perspektywie są jednak tańsze w eksploatacji, ponieważ zużywają mniej energii.

Rozmieszczenie serwerów

Nadmiar ciepła próbuje się także usuwać przez odpowiednie rozmieszczenie wyposażenia centrów danych. Przykładem jest układ gorących/zimnych korytarzy (hot aisle / cold aisle). Jest to jeden ze starszych sposobów energetycznie efektywnego chłodzenia centrów danych – wprowadziła go w 1992 r. firma IBM. Od tego czasu jest to popularna metoda, szczególnie w większych obiektach tego typu.

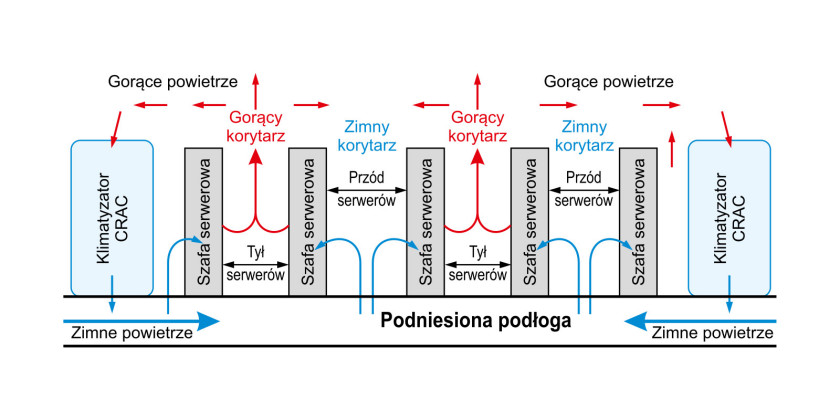

W podejściu tym szafy z serwerami ustawia się naprzemiennie. W jednym rzędzie zwraca się je do siebie frontami (wlotami schłodzonego powietrza), co prowadzi do utworzenia zimnego korytarza, a w drugim tyłami (wylotami nagrzanego powietrza). To tworzy korytarz gorący. Uzupełnieniem tego układu są podwyższone podłogi. Jest to dodatkowa powierzchnia nośna podniesiona ponad podłogę budynku. Przestrzeń między nimi wykorzystuje się w tym przypadku do rozprowadzania zimnego powietrza dostarczanego przez klimatyzator CRAC (rys. 1). Płynie ono przez perforacje w płytkach podłogowych do zimnych korytarzy, skąd jest zasysane przez front serwerów, schładzając je. Gorące powietrze, które jest z nich wywiewane, płynie gorącym korytarzu i unosząc się ku górze, wraca do wlotów klimatyzatorów CRAC. Rozmieszczenie szaf w konfiguracji gorących/zimnych korytarzy zapobiega mieszaniu się schłodzonego powietrza wlotowego z nagrzanym powietrzem wylotowym. To zapewnia oszczędności energii średnio od 10 do nawet 35%.

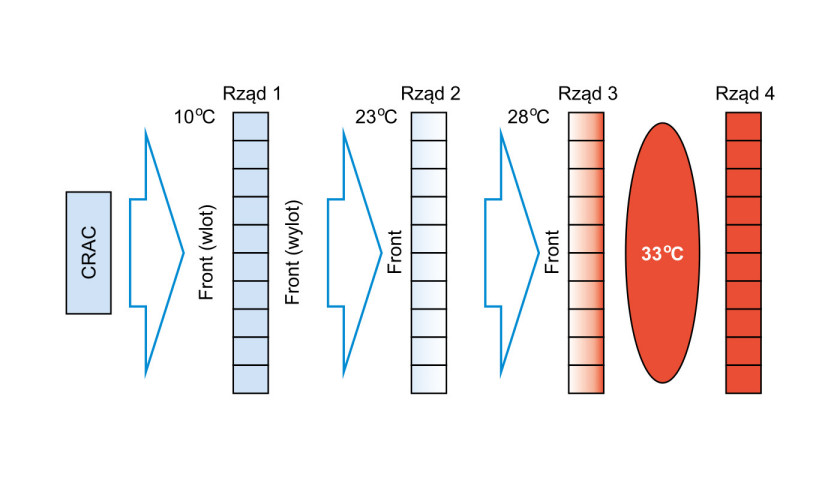

Takie rozmieszczenie szaf serwerowych zapobiega też sytuacji przedstawionej na rysunku 2. Jeżeli zostaną ustawione frontami skierowanymi w tę samą stronę, czyli w układzie: przód jednej szafy na wprost tyłu drugiej, gorące powietrze wylotowe z każdego kolejnego rzędu będzie wpływało przez fronty serwerów w rzędzie następnym. W efekcie temperatura powietrza wlotowego będzie sukcesywnie wciąż rosła, a jedynym sposobem na zapobiegnięcie przegrzaniu serwerów znajdujących się najdalej od klimatyzatora CRAC będzie nadmierne obniżenie temperatury w całym pomieszczaniu. Będzie się to wiązało z dużym marnotrawstwem energii.

Chłodzenie zlokalizowane

Duże centra danych wymagają specjalnego podejścia. Na potrzeby ich chłodzenia wykorzystuje się bardziej zaawansowane rozwiązania. Przykład to metoda chłodzenia direct to chip, w której dużą szybkość i skuteczność rozpraszania ciepła uzyskuje się przez ukierunkowanie na jego źródło.

W podejściu tym wykorzystywana jest płyta stykająca się bezpośrednio z najsilniej nagrzewającymi się podzespołami, jak procesory. Jest ona schładzana cieczą. Ta cyrkulując odprowadza na zewnątrz nadmiar ciepła przekazywanego do płyty przez gorące punkty.

Metoda direct to chip pozwala znacznie szybciej usunąć ciepło i zużywa znacząco mniej energii niż tradycyjne systemy chłodzenia, w których zimne powietrze z klimatyzatorów przepływa przez całe szafy serwerowe. W takim przypadku bowiem opływa ono wszystkie podzespoły. Duża część tego powietrza ma więc kontakt z komponentami, takimi jak na przykład interfejsy sieciowe i dodatkowe elementy PCB, które słabo się nagrzewają i nie są głównymi źródłami ciepła. Oznacza to, że zimne powietrze jest marnowane. Dzięki działaniu zlokalizowanemu na najsilniej nagrzewające się punkty metoda bezpośrednia rozprasza więcej ciepła przy mniejszym zużyciu energii.

Niestety ma kilka wad i ograniczeń. Przeważnie jest droższa niż tradycyjne systemy chłodzenia z klimatyzatorami. Problemem jest ryzyko wycieku płynów chłodzących. Chociaż nie stanowią one zagrożenia dla sprzętu elektronicznego, ponieważ są nieprzewodzące, przeciekanie powoduje awarię systemu chłodzenia. To prowadzi do niebezpiecznego przegrzania.

Ponadto media chłodzące nie są przyjazne środowisku. Oznacza to ryzyko zanieczyszczenia w razie ich niekontrolowanego wypływu i problemy z utylizacją. Dodatkowo, ponieważ systemy direct to chip chłodzą jedynie główne źródła ciepła, istnieje niebezpieczeństwo, że inne części serwera, takie jak dyski twarde, mogą się przegrzać.

Chłodzenie zanurzeniowe

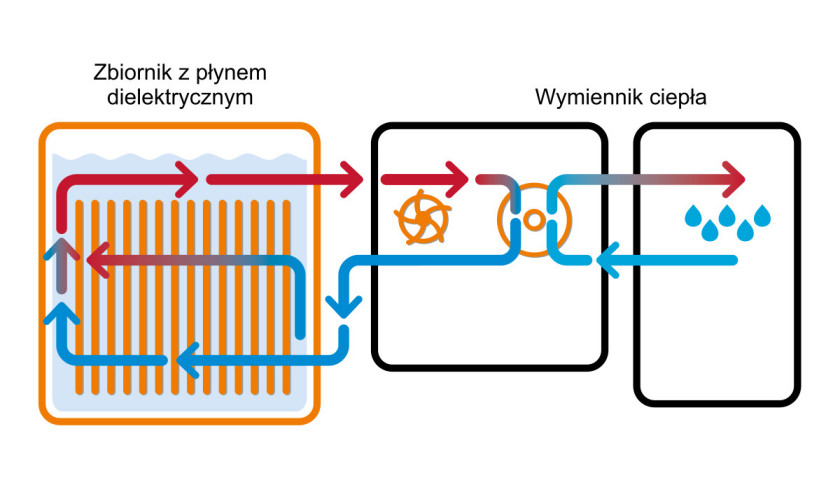

Kolejny przykład metody wykorzystywanej w dużych centrach danych to chłodzenie zanurzeniowe. Nadmiar ciepła jest w tym przypadku usuwany dzięki umieszczeniu serwerów w zbiorniku, który jest wypełniony cieczą dielektryczną, która jest lepszym przewodnikiem ciepła niż powietrze. W zależności od jej typu wyróżnia się dwie wersje tej techniki: jedno- oraz dwufazową.

W pierwszej zwykle stosuje się dwa rodzaje płynów: ciecze dielektryczne na bazie węglowodorów i oleje syntetyczne. Nadmiar ciepła wydzielanego przez nagrzewające się podzespoły elektroniczne jest przekazywany do chłodziwa, które jest pompowane do wymiennika ciepła. Schłodzona ciecz wraca do zbiornika zanurzeniowego.

W porównaniu z chłodzeniem z wykorzystaniem klimatyzatorów ta technika zużywa mniej energii (nawet o 50%). To znacząco zmniejsza koszty operacyjne obiektu. Dodatkowo płyn dielektryczny działa jako środek gaśniczy, ograniczając ryzyko pożaru w centrum danych.

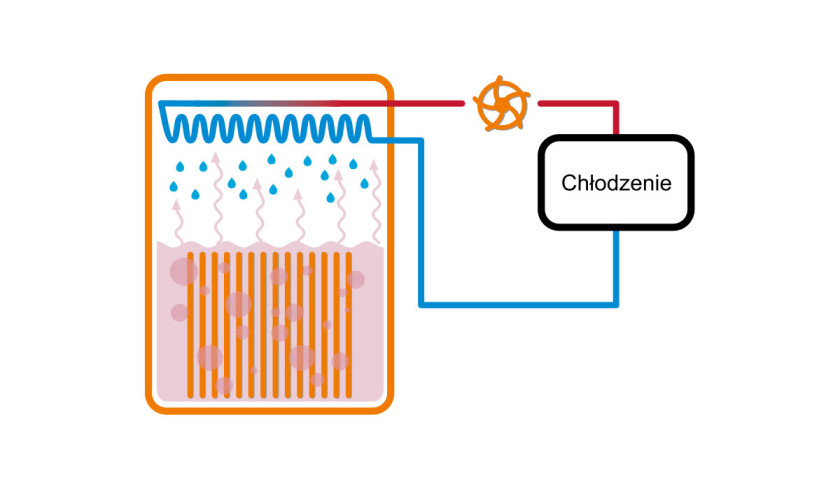

W metodzie dwufazowej serwery także zanurza się w nieprzewodzącej cieczy, ma ona jednak inne właściwości niż płyny w wersji jednofazowej. W tym przypadku zwykle używa się płynów na bazie fluorowęglowodoru. Ich wyróżnikiem jest niska temperatura wrzenia – typowo poniżej +50°C. Kiedy temperatura podzespołów elektronicznych przekroczy tę wartość, ciecz dielektryczna zaczyna wrzeć i ulega przemianie fazowej. Para, która wtedy powstaje, unosi się do góry pojemnika i ponownie skrapla się, oddając ciepło. Ochłodzona ciecz wraca do zbiornika.

Inne metody

Mikrokanałowe chłodzenie jest rozszerzeniem techniki bezpośredniego chłodzenia direct to chip. W tym przypadku ciecz, zwykle woda albo mieszanina wody i glikolu, jest pompowana przez kanały (rurki) w płycie, która styka się z gorącymi punktami. Przewody te są zwykle wykonane z miedzi albo z aluminium i mają tylko kilka milimetrów szerokości.

Kolejnym przykładem jest technika Calibrated vector cooling (CVC), również opracowana przez firmę IBM. W podejściu tym powietrze jest kierowane do tych części serwera, które nagrzewają się najbardziej.

W rozwiązaniu Rear Door Heat Exchange (RDHx) z kolei wykorzystuje się wymienniki ciepła zamontowane na tylnych drzwiach szaf serwerowych. Są to wymienniki pasywne albo aktywne. Pierwsze z nich do tłoczenia gorącego powietrza wykorzystują wewnętrzne wentylatory szaf, a drugie wentylatory dodatkowe.

Monika Jaworowska