Obsługa bez użycia rąk jest też wygodniejsza i bardziej intuicyjna. Ponadto urządzenia sterowane głosem nie muszą być wyposażone w klawiaturę ani w wyświetlacz. Upraszcza to ich konstrukcję i zapewnia większą swobodę projektowania wyglądu.

Miniona dekada była przełomowa dla tego rodzaju rozwiązań. Wirtualni asystenci aktywowani głosem przez ten czas sukcesywnie ewoluowali, od specjalistycznych zastosowań o ograniczonym zasięgu, do tych coraz powszechniejszych w życiu codziennym. Podobnie zmieniało się nastawienie użytkowników, którzy początkowo Siri, Alexę czy Cortanę uznawali za ciekawostkę, a obecnie zaczynają je traktować jak standardową funkcjonalność.

Jak to się zaczęło, czyli kiedy pojawił się pierwszy asystent głosowy?

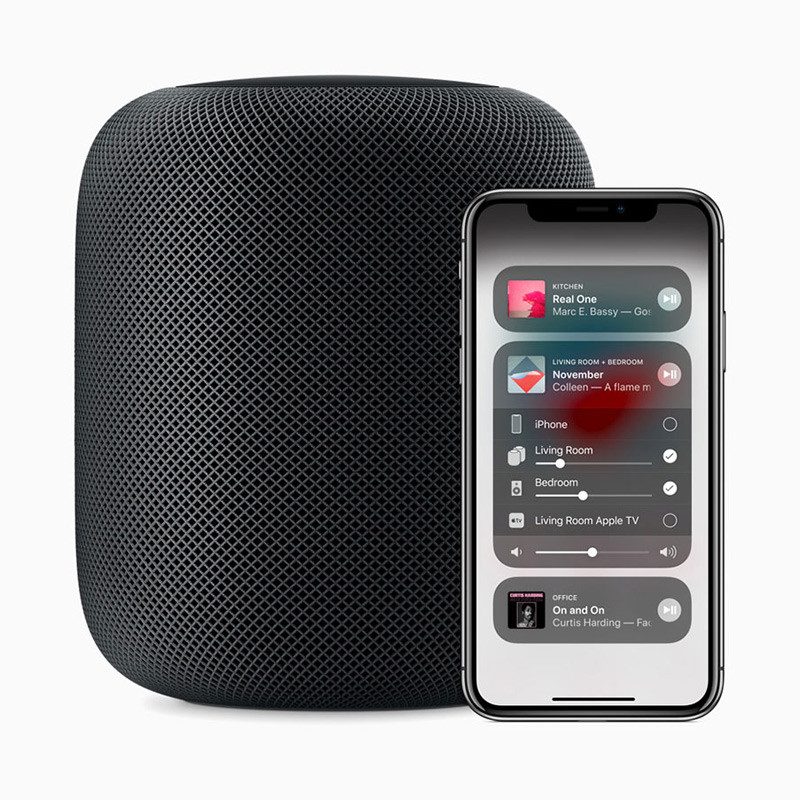

W historii wirtualnych asystentów głosowych wyróżnić można kilka przełomowych zakresów. W 2010 Siri zostało udostępnione jako aplikacja mobilna na iPhone'y. Szybko dostrzegając jej potencjał, Apple przejęło firmę, która ją stworzyła. Począwszy od modelu iPhone 4S, Siri stała się integralną częścią urządzeń tego producenta, w tym inteligentnych głośników i elektroniki noszonej. Ponieważ dzięki temu dla wielu użytkowników była pierwszą taką aplikacją, ukształtowała ich oczekiwania wobec wirtualnych asystentów aktywowanych głosem, stając się na lata punktem odniesienia dla ich następnych generacji.

Kolejnym ważnym momentem było rozszerzenie w 2011 roku wyszukiwarki Google o możliwość głosowego wprowadzania zapytań. Choć funkcjonalność ta była dostępna tylko w przeglądarce Google Chrome, zyskała dużą popularność jako nowy sposób interakcji ze stronami w Internecie. W 2013 roku Microsoft udostępnił Cortanę, a rok później Amazon wprowadził na rynek inteligentny głośnik Echo z asystentem Alexą.

Asystentów głosowych przybywa

Od tego czasu Alexa pod względem popularności wyprzedziła Siri i Cortanę do tego stopnia, że stała się synonimem wirtualnego asystenta głosowego. W 2016 roku Google wprowadziło do sprzedaży inteligentny głośnik Google Home z Google Assistant. Rok później na ten rynek weszli chińscy giganci technologiczni, firmy Baidu oraz Alibaba.

Liczba asystentów głosowych w użyciu na świecie liczona jest w miliardach sztuk. Przykładowo na początku 2019 roku było to ponad 3 mld, natomiast w 2023, według Juniper Research, liczba tego typu asystentów sięgnie 8 mld. Warto zatem wiedzieć, jakie rozwiązania są stosowane w tej niezwykle popularnej nowince technologicznej.

Czym jest key word spotting?

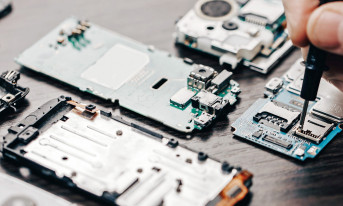

Wirtualni asystenci głosowi rozpoznają słowa i frazy z całego słownika Key Word Spotting (KWS) z dużą dokładnością. Taka funkcjonalność wymaga dużej pamięci i mocy obliczeniowej, które są poza zasięgiem urządzeń, takich jak smartfony czy inteligentne głośniki. Ograniczenie to jest rozwiązywane w taki sposób, że do zasadniczego rozpoznawania mowy wykorzystywane są zasoby w chmurze.

Do niej z kolei urządzenia te podłączają się warunkowo. W tym celu implementuje się w nich mało obciążający algorytm rozpoznawania zestandaryzowanych słów kluczowych. Polega on na nasłuchiwaniu na określone wyrazy, których wystąpienie w określonej kolejności inicjuje połączenie z chmurą. Przykładami fraz aktywujących w najpopularniejszych wirtualnych asystentach głosowych są: "hej, Siri", "ok, Google", "Alexa", "hej, Cortana".

Wymagania stawiane algorytmom Key Word Spotting

Po ich rozpoznaniu urządzenie łączy się z chmurą i przesyła do niej wszystko, co "słyszy". Tam wypowiedź ta jest przetwarzana i interpretowana. Potem odsyłana jest stosowna odpowiedź.

Ponieważ użytkownik może się odezwać w dowolnym momencie, urządzenie powinno przez cały czas nasłuchiwać. Ma to wpływ na jego sprawność energetyczną, dlatego tak ważne jest to, żeby algorytm Key Word Spotting został zaimplementowany jak najwydajniej. Powinien również działać całkowicie niezależnie od reszty systemu w chmurze, z którą połączenie może być nawiązywane wyłącznie warunkowo.

W przeciwnym razie, czyli gdyby transmisja ta była ciągła, dochodziłoby bowiem do naruszenia prywatności użytkownika. Ponadto biorąc pod uwagę już teraz ogromną, a wciąż rosnącą popularność asystentów głosowych, łatwo można sobie wyobrazić, jaki ruch sieciowy generowałaby ta usługa w Internecie. Oprócz tego, że niepotrzebnie obciążałoby to sieć, pogarszałoby jakość rozpoznawania mowy. Błędy i opóźnienia tym spowodowane tylko zniechęcałyby użytkowników do korzystania z wirtualnych asystentów głosowych.

Czym są sieci neuronowe?

Wirtualni asystenci jak Siri i Alexa bazują na algorytmach sieci neuronowych implementowanych w centrach danych. Sieci neuronowe są szkolone przy wykorzystaniu milionów próbek głosowych metodą przypominającej sukcesywną aproksymację.

W tym przypadku błędy są początkowo bardzo duże, ale stopniowo są redukowane przez ponowne wprowadzanie danych o nich do algorytmu, który na tej podstawie koryguje parametry sieci. Dzięki temu błędy zmniejszają się w każdym kolejnym cyklu treningowym. Ten ostatni jest powtarzany wielokrotnie, aż uzyskany wynik będzie prawidłowy. Odbywa się to dla każdego słowa i dla każdej frazy w danym zestawie danych.

Dzięki temu sieci neuronowe mogą "nauczyć się" rozpoznawania i prawidłowego interpretowania poszczególnych słów, fraz, jak również specyficznych cech mowy, jak akcent czy intonacja. W ten sposób są w stanie imitować ludzką inteligencję, ucząc się na podstawie doświadczeń.

Na czym polega głębokie uczenie się?

W wirtualnych asystentach głosowych wykorzystywany jest szczególny rodzaj sieci neuronowych, tzw. technika głębokiego uczenia się (deep learning). Nazwa ta wynika stąd, że algorytm ten polega na wchodzeniu głęboko w kilka warstw sieci, która obejmuje także warstwy ukryte. Im głębiej, tym można pozyskać bardziej złożone dane.

Poziomy początkowe pozwalają sieci na "przyswojenie" prostych informacji. Z każdym nowym poziomem przybywa dodatkowych danych, które sieci neuronowe łączą z tym, czego "nauczyły się" wcześniej. Tego typu hierarchiczna struktura z dużą precyzją imituje złożone procesy ludzkiego logicznego myślenia.

W praktyce w przypadku algorytmów głębokiego uczenia się wykorzystywanych przez asystentów głosowych najpierw podejmowana jest próba rozróżnienia słów w ich potoku oraz rozpoznania na przykład różnych intonacji. Na wyższych poziomach zbierane są informacje na temat słownictwa. Do tych dodawane są ustalenia z poprzednich poziomów. Na kolejnych analizuje się podpowiedzi, a następnie wszystko się scala. Na najwyższym poziomie struktury hierarchicznej sieć neuronowa "umie" już wystarczająco dużo, aby móc właściwie zinterpretować intencje użytkownika.

Kontrowersje wokół wirtualnych asystentów głosowych

Olbrzymiej popularności wirtualnych asystentów głosowych towarzyszą nie mniejsze kontrowersje. Podstawowym problemem jest kwestia prywatności - chodzi o to, kto ma dostęp do nagrań, które są pozyskiwane za ich pośrednictwem oraz to, co jest rejestrowane na przykład przez inteligentne głośniki.

Jeśli chodzi o pierwszą kwestię, pojawiały się dotychczas doniesienia o tym, że niektórzy operatorzy asystentów głosowych udostępniali nagrania firmom trzecim, z którymi współpracują, o czym użytkownicy nie zostali poinformowani i na co w związku z tym nie wyrazili wcześniej zgody.

Ponadto dochodziło do przypadkowych "wybudzeń". To oznaczało, że asystent głosowy czasami rejestrował prywatne informacje, których udostępnienie nie było intencją użytkowników.

Tego typu sytuacje mają ogromny wpływ na opinię oraz nastawienie tych ostatnich. Na kwestię tę większość ludzi jest na tyle wyczulona, że nawet niepotwierdzone pogłoski na temat zagrożenia ich prywatności mogą na trwale zniechęcić do danego dostawcy usługi asystenta głosowego. W tym przypadku bowiem zaufanie do urządzenia sterowanego głosem, które staje się integralną częścią życia codziennego, jest dla użytkowników ważniejsze niż jego rozbudowana funkcjonalność czy wyszukany design.

Monika Jaworowska