Trenowanie modeli odpowiedzialnych za tę technologię wymaga mocy obliczeniowej rodem z chmury i ogromnych klastrów GPU. Trening jest jednak tylko jedną częścią dobrego systemu. Powinien być on również płynny i bezproblemowy w działaniu dla samego użytkownika.

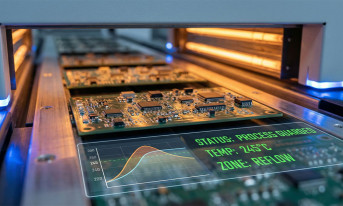

W przypadku rozpoznawania mowy liczy się więc przede wszystkim przepustowość i niskie opóźnienia. System musi przetwarzać ogromną liczbę strumieni audio w czasie rzeczywistym, a odpowiedź powinna pojawiać się w ciągu zaledwie kilkudziesięciu milisekund. Gdy ten łańcuch się zatka lub spowolni, użytkownik natychmiast czuje różnicę. Opóźnienia zabijają naturalność interakcji – sprawiają, że system głosowy staje się drętwy, sztuczny i irytujący. A momentami nawet po prostu niedziałający i stanowiący źródło frustracji, chociażby dla kierowców. GPU świetnie radzą sobie z dużymi obciążeniami, ale ich mechanizmy przetwarzania danych potrafią generować nieprzewidywalne przestoje. CPU za to zwyczajnie nie nadążają – nie dysponują wystarczającą mocą obliczeniową. Z kolei projektowanie wyspecjalizowanych układów ASIC trwa latami, a kiedy trafiają na rynek, modele AI zdążą już wyewoluować.

Jednym z potencjalnych rozwiązań tego problemu mogą być układy FPGA, czyli programowalne macierze bramek. Umożliwiają implementację zrównoleglonych ścieżek przetwarzania danych, implementację niestandardowych akceleratorów sprzętowych, zachowując przy tym mały narzut czasowy i deterministyczną latencję. Działają więc praktycznie tożsamo do specjalizowanych układów scalonych, ale umożliwiają reprogramowanie w locie. W tak zmieniającym się środowisku jak modele AI to olbrzymia zaleta, przekładająca się bezpośrednio na oszczędności.

Elastyczność i efektywność energetyczna FPGA

To, co czyni FPGA wyjątkowo atrakcyjnymi w tym kontekście, to ich elastyczność. W zadaniach związanych z rozpoznawaniem mowy pełna precyzja zmiennoprzecinkowa zwykle nie jest potrzebna. Zmniejszenie głębokości bitowej do 16 lub 8 bitów praktycznie nie wpływa na dokładność modeli. W niektórych warstwach można zejść jeszcze niżej – do 4 bitów, a nawet wartości trójstanowych – i nadal uzyskać użyteczne rezultaty. Nie potrzeba jakości studyjnej, żeby rozpoznać mowę. Algorytmy i tak sprowadzają dźwięk do sekwencji punktów – ich działanie nie jest zakłócane przez niższą jakość strumieni danych. W praktyce oznacza to nie tylko elastyczny układ przetwarzania, ale taki, który można precyzyjnie dostroić, przebudować lub skalować w miarę ewolucji architektury modeli – bez konieczności zaczynania wszystkiego od zera.

Kolejna kwestia to jeden z najważniejszych tematów współczesnej elektroniki – zapotrzebowanie na energię. Rosnące zużycie energii stało się problemem o znaczeniu globalnym. Ogromne centra danych budowane pod potrzeby AI mają pochłaniać gigawaty mocy. Dla porównania: jedno wielkoskalowe centrum przeznaczone do treningu AI potrafi zużyć tyle energii, co średniej wielkości miasto. Dlatego obliczenia w zredukowanej precyzji mają tak duże znaczenie. Ograniczenie zapotrzebowania mocy w systemach rozpoznawania mowy nie tylko obniża koszty utrzymania, ale też poprawia ich zrównoważenie. Emisja CO2, zużycie wody na chłodzenie – kiedy mówimy o AI, każdy z tych czynników ma wręcz kolosalne znaczenie. Dodatkowo ograniczenie zapotrzebowania mocy w systemach rozpoznawania mowy nie tylko obniża koszty utrzymania, ale też poprawia ich zrównoważenie. Jeśli uda się zmniejszyć zużycie energii na jedną inferencję o połowę, można obsłużyć dwa razy więcej użytkowników bez rozbudowy całej infrastruktury.

Koszty posiadania

FGPA wydają się naturalnym rozwiązaniem dla dynamicznie rozwijających się systemów rozpoznawania mowy. Sam zakup sprzętu to najmniejsza część wydatków – prawdziwe koszty pojawiają się dopiero przy jego wieloletniej eksploatacji, zasilaniu i chłodzeniu. Każdy wat mniej to realna oszczędność, a możliwość przedłużenia życia sprzętu poprzez jego rekonfigurację, zamiast konieczności wymiany, staje się równie istotna. I w gruncie rzeczy o to w tym chodzi: na dużą skalę rozpoznawanie mowy nie jest wyścigiem o największy model, lecz o takie samo wyniki przy możliwie małym poborze mocy, minimalnych opóźnieniach i długowiecznym sprzęcie. Rozpoznawanie mowy to nie tylko nauczanie maszyn poprawnego interpretowania ludzkiej mowy. Równie ważne jest zrobienie tego w sposób racjonalny ekonomicznie. I szybko się staje jasne, że równocześnie z poszanowaniem środowiska.