Dlatego w urządzeniach tego typu spopularyzowały się metody interakcji za pośrednictwem dotyku, gestów, czy głosu, należące do grupy naturalnych interfejsów użytkownika (Natural User Interface, NUI). Na wstępie wyjaśniamy, czym powinny charakteryzować się NUI i jak je projektować. Nie wystarczy bowiem, że użytkownik może sterować urządzeniem bezpośrednio dłonią albo głosem, aby dany interfejs mógł zostać zaliczony do tej kategorii.

Czym jest NUI?

NUI nie jest łatwo zdefiniować. Generalnie jednak tym termin opisuje się interfejsy, w których interakcja pomiędzy człowiekiem, a urządzeniem jest bezpośrednia, tzn. nie korzysta się jak w przypadku tradycyjnych graficznych interfejsów użytkownika (Graphical User Interface, GUI) z myszki, ani z klawiatury, i jest zgodna z naturalnym ludzkim zachowaniem.

NUI nie jest łatwo zdefiniować. Generalnie jednak tym termin opisuje się interfejsy, w których interakcja pomiędzy człowiekiem, a urządzeniem jest bezpośrednia, tzn. nie korzysta się jak w przypadku tradycyjnych graficznych interfejsów użytkownika (Graphical User Interface, GUI) z myszki, ani z klawiatury, i jest zgodna z naturalnym ludzkim zachowaniem.

Czyni to obsługę urządzenia łatwiejszą, ponieważ użytkownik może korzystać z umiejętności już nabytych i nie musi przyswajać nowych. Jest to ważna zaleta zwłaszcza dla osób, które wcześniej sprzętów danego typu nigdy nie używały.

Z podanej definicji wynika, że aby interfejs można było uznać za NUI, muszą być jednocześnie spełnione oba warunki. Dlatego nawet jeżeli interakcja zachodzi bezpośrednio, na przykład za pośrednictwem gestów, ale nie są one intuicyjne, nie jest to NUI.

Interfejs intuicyjny, czyli jaki?

Za takie większość użytkowników z pewnością uzna przesuwanie palcem po ekranie w lewo/prawo lub góra/ dół przy przewracaniu kolejnych stron e-booka i nawigowaniu po zawartości witryny internetowej. W przypadku tych czynności, a zwłaszcza pierwszej, granica między światem cyfrowym a rzeczywistym zaciera się, bowiem w obu są one wykonywane w zasadzie w ten sam sposób.

Przykładem przeciwnym jest iPad, w którym w celu przełączenia się między uruchomionymi aplikacjami trzeba przesunąć po ekranie w lewo albo w prawo czterema albo pięcioma palcami. Aby z kolei wrócić do widoku startowego, tyle samo palców należy zsunąć. W obu przypadkach związek pomiędzy akcją użytkownika a reakcją urządzenia nie jest oczywisty.

Dlatego musi mu zostać wyraźnie wskazany, inaczej w ogóle nie będzie z tych funkcji korzystał. Taką właśnie cenę płacą projektanci nieintuicyjnych interfejsów - ich wysiłki często pozostają niedoceniane przez użytkowników, którzy są nieświadomi istnienia niektórych opcji.

Kontekst użytkowania

Naturalny interfejs powinien wykorzystywać umiejętności, które ma każdy człowiek. Dzięki temu zmniejsza się obciążenie związane z koniecznością zapamiętania obsługi poszczególnych funkcji, które może zniechęcać do korzystania z urządzenia.

Oprócz tego NUI powinno się projektować, uwzględniając kontekst użytkowania, tzn. to, kto i gdzie będzie z urządzenia korzystał. Nie jest oczywiście możliwe, żeby interfejs był naturalny w obsłudze zawsze, w każdych warunkach i jednakowo dla wszystkich użytkowników.

Na przykład podczas jazdy samochodem urządzeniami pokładowymi najwygodniej steruje się głosem. Jest to także bezpieczniejsze od obsługi ręcznej, gdyż w mniejszym stopniu absorbuje kierowcę. Dzięki temu nie musi on odwracać uwagi od prowadzenia auta, żeby włączyć radio albo wybrać numer telefonu, jeżeli chce zadzwonić.

Interfejs głosowy nie sprawdzi się natomiast w urządzeniach używanych w zatłoczonych, głośnych miejscach, zarówno przez to, że komendy będą trudno rozpoznawalne, jak i dlatego, że wszyscy w pobliżu będą mogli usłyszeć wypowiadane polecenia. To może właściciela urządzenia krępować.

Projektowanie NUI

Projektując NUI, warto przestrzegać kilku zasad. Jedną z nich, o której pisaliśmy już wcześniej, jest to, aby obsługę interfejsu opierać na umiejętnościach, które użytkownik już ma, zaoszczędzając mu w ten sposób wysiłku wymaganego do nauki nowych. W tym zakresie stosowane są dwa podejścia. W pierwszym wykorzystywane są umiejętności, które są powszechne dla wszystkich ludzi, jak na przykład zdolność mówienia.

Dzięki temu projektant nie musi poświęcać czasu na dostosowanie obsługi urządzenia do różnych grup odbiorców. W zamian wystarczy, że przyjmie za pewnik, że wszyscy użytkownicy, jako ludzie, są w stanie daną czynność wykonać. Jest to dla projektanta znaczącym ułatwieniem i zalecanym podejściem w projektowaniu NUI.

W drugiej ze wspomnianych praktyk wykorzystuje się umiejętności specyficzne dla konkretnej grupy ludzi, na przykład danej grupy zawodowej. Z przyjęciem założenia, że wszyscy, których można do niej zaliczyć, posiedli je w jednakowym stopniu, wiąże się jednak spore ryzyko, gdyż niekoniecznie musi tak być.

Akcja - reakcja

Powinno się również uwzględnić stopień zaawansowania użytkowników. Początkujących należy przeprowadzić przez proces uczenia się obsługi urządzenia, krok po kroku, począwszy od funkcji łatwiejszych po te trudniejsze. Trzeba przy tym uważać, żeby nie przytłoczyć ich zbyt dużą liczbą informacji do opanowania jednocześnie.

Inaczej trzeba traktować użytkowników zaawansowanych. Jeżeli od razu nie będą w stanie wykorzystać umiejętności, które już posiadają i zostaną zmuszeni do przejścia etapów dla początkujących, jest bardzo prawdopodobne, że wówczas wielu z nich się szybko zniechęci.

Ponadto NUI powinien zostać zaprojektowany w taki sposób, by akcja wywoływała reakcję bez zbędnych opóźnień. Dzięki temu użytkownik będzie miał poczucie rzeczywistej interakcji, jak przykładowo przy powiększaniu i zmniejszaniu obrazu na ekranie, którego rozmiar zmienia się płynnie w zależności od rozstawu jego palców.

Ważne jest też, aby w przypadku dynamicznych przejść nie przytłoczyć użytkownika nadmierną ilością informacji wyświetlanych na ekranie. W tym celu trzeba je ograniczyć tylko do tych najważniejszych i nie przedłużać czasu ich prezentacji dłużej niż to konieczne. Na przykład informacja o aktualnym powiększeniu jest przydatna tylko do momentu ustawienia przez użytkownika tego pożądanego.

Klasyfikacja interfejsów

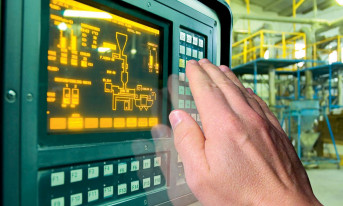

Interfejsy użytkownika możemy podzielić generalnie na dwie grupy: dotykowe oraz bezdotykowe. Pierwsze w postaci ekranów dotykowych, przede wszystkim pojemnościowych, są podstawowym interfejsem smartfonów i tabletów. Instaluje się je również w kioskach elektronicznych i coraz częściej w laptopach. Projektanci urządzeń, którzy chcą je wyposażyć w ten typ wyświetlaczy, muszą jednocześnie spełnić wiele warunków, inaczej może się to negatywnie odbić na jakości użytkowej urządzenia.

Jednym z podstawowych wymogów, wspomnianych już wcześniej, jest natychmiastowa reakcja na akcję użytkownika. W tym celu kontroler ekranu dotykowego musi z odpowiednio dużą częstością (report rate) sprawdzać stan czujników wykrywających dotyk. Dzięki temu położenie palców na ekranie jest zawsze znane. To umożliwia aktualnie używanej aplikacji szybką interpretację ich ruchu.

Ekran dotykowy powinien reagować zarówno na dotknięcie palcami, jak i rysikiem. O ile bowiem pierwsze ułatwiają dostęp do treści prezentowanych na wyświetlaczu, to drugie są wygodniejsze przy jej tworzeniu, na przykład rysowaniu na ekranie.

Wymagania stawiane interfejsom dotykowym

Ważnym aspektem jest pobór prądu. W przypadku urządzeń przenośnych użytkownicy oczekują jak najdłuższego czasu pracy na zasilaniu bateryjnym, dlatego pobór prądu przez ich podzespoły musi być ograniczony do niezbędnego minimum. Kontroler ekranu dotykowego nie jest w tym zakresie wyjątkiem. Ekran dotykowy powinien być też odporny na zaburzenia elektromagnetyczne.

Ponadto urządzenia elektroniki użytkowej powinny być coraz cieńsze, lżejsze i tańsze. Wkład, jaki w osiągnięcie tych celów wnoszą projektanci ekranów dotykowych, polega m.in. na: zmniejszaniu liczby warstw szkła, tworzywa sztucznego i spoiw, z których budowane są wyświetlacze.

W przypadku elektroniki użytkowej ważny jest również czas wprowadzenia urządzenia na rynek, który w dobie silnej konkurencji powinien być jak najkrótszy. Nic zatem dziwnego, że projektanci ekranów dotykowych nie są pod tym względem wyjątkiem i poszukują gotowych rozwiązań, które łatwo można zintegrować z urządzeniem, nad którym pracują.

Przykładem są kontrolery ze standardowym oprogramowaniem firmware. Zamiast od podstaw tworzyć kod do obsługi podstawowych funkcji interfejsu dotykowego, wybierając ten gotowy, jedynie dostosowują go do swoich potrzeb. Znacząco skraca to czas projektowania i testowania urządzenia.

Projektowanie ekranów dotykowych

Konieczność jednoczesnego spełnienia powyższych wymagań jest dla projektantów interfejsów dotykowych wyzwaniem. Niektóre z nich mogą bowiem ze sobą kolidować, w związku z czym trzeba znaleźć rozwiązanie kompromisowe, aby jednej z cech nie uzyskiwać całkiem kosztem drugiej. Przykładem jest konieczność pogodzenia wymogu konstruowania coraz cieńszych, lżejszych i tańszych urządzeń z zapewnieniem odporności na zaburzenia elektromagnetyczne.

Jak już napisaliśmy, aby spełnić pierwszy warunek, trzeba zmniejszyć liczbę warstw, z których wykonuje się ekrany dotykowe. Zwykle rezygnuje się z warstwy ekranującej, która tradycyjnie chroni czujniki przed zaburzeniami emitowanymi przez podzespoły umieszczone poniżej. W rezultacie zdarza się, że te drugie są silniejsze niż sygnał pomiarowy. Właściwa interpretacja zakłóconego sygnału przez kontroler ekranu jest wówczas utrudniona. W związku z tym trzeba zastosować w nim specjalne rozwiązania, które pozwolą na odfiltrowanie zakłóceń.

W tym celu można by wykorzystać fakt, że zaburzenia emitowane przez wyświetlacze są okresowo zmienne - powstają podczas odświeżania obrazu, a następnie zanikają w przerwach pomiędzy jego kolejnymi cyklami. Okres pauzy, podczas którego poziom zaburzeń maleje, może "wykorzystać" kontroler. Praktyczna realizacja takiego podejścia jest jednak utrudniona i to z kilku powodów.

Kompromis

Przede wszystkim nie zawsze dostępny jest sygnał z wyświetlacza, który umożliwiałby innym urządzeniom, takim jak kontrolery ekranów dotykowych, zsynchronizowanie się z cyklami odświeżania obrazu. Po drugie przerwy między nimi są często zbyt krótkie, aby mogły być użyteczne i nie zawsze poziom zaburzeń jest wtedy odpowiednio niski. Ponadto konieczność synchronizacji ogranicza możliwość wyboru częstotliwości pracy kontrolera i trudno jest uniknąć zakłóceń z innych źródeł.

Przede wszystkim nie zawsze dostępny jest sygnał z wyświetlacza, który umożliwiałby innym urządzeniom, takim jak kontrolery ekranów dotykowych, zsynchronizowanie się z cyklami odświeżania obrazu. Po drugie przerwy między nimi są często zbyt krótkie, aby mogły być użyteczne i nie zawsze poziom zaburzeń jest wtedy odpowiednio niski. Ponadto konieczność synchronizacji ogranicza możliwość wyboru częstotliwości pracy kontrolera i trudno jest uniknąć zakłóceń z innych źródeł.

Alternatywnym rozwiązaniem jest programowe filtrowanie zaburzeń emitowanych przez wyświetlacze. Jest to sposób uniwersalny. Dzięki temu, że nie wymaga synchronizacji z wyświetlaczem, jego skuteczność nie zależy od jego typu ani rozdzielczości.

Niestety w tym przypadku potrzebny jest wspomniany kompromis. Filtrowanie programowe jest bowiem operacją bardzo obciążającą obliczeniowo, co może negatywnie odbić się na szybkości reakcji ekranu na dotyk i zwiększyć pobór mocy. Dlatego zwykle dla osiągnięcia najlepszych rezultatów konieczne jest jednoczesne zastosowanie rozwiązań sprzętowych i programowych.

Przykładem są kontrolery z akceleratorami sprzętowymi zoptymalizowane pod kątem realizacji algorytmów filtrowania zaburzeń emitowanych przez wyświetlacze. Zapewniają one skuteczne eliminowanie zakłóceń, bez wpływu na inne cechy użytkowe urządzenia.

Interfejsy bezdotykowe

Według Markets and Markets wartość globalnego rynku kontrolerów ekranów dotykowych będzie rosła średnio co roku o ponad 15% aż do 2022 roku, kiedy przekroczy 9 mld dol. Przyczyni się do tego przede wszystkim większe zapotrzebowanie na ekrany tego typu instalowane w samochodach i w elektronice noszonej.

Interfejsom dotykowym stopniowo wyrasta jednak coraz silniejsza konkurencja w postaci tych bezdotykowych. Od niedawna na popularności zyskują interfejsy głosowe, zaś już jakiś czas temu zaczęło się upowszechniać sterowanie gestami. Według Grand View Research wartość globalnego rynku rozwiązań do rozpoznawania tych ostatnich przekroczy w 2025 roku 33 mld dol., co będzie oznaczać średni coroczny wzrost o ponad 20%.

Prace nad rozwojem technologii sterowania gestami rozpoczęto już dość dawno temu. Początkowo jednak ich rezultaty nie były na tyle zadowalające, aby urządzenia z takim interfejsem można było wprowadzić do sprzedaży.

Sterowanie gestami

W latach 70. zeszłego wieku zbudowano pierwsze rękawice rejestrujące ruchy ręki wyposażone w czujniki, optyczne oraz rezystancyjne, które wykrywały zgięcia na złączach. Ponieważ były to urządzenia przewodowe, były niewygodne w użytkowaniu. Przez to nie zyskały powszechnego uznania i wykorzystywano je przede wszystkim w celach badawczych.

Pierwsze przewodowe rękawice dostępne w powszechnej sprzedaży pojawiły się dopiero pod koniec lat 80. zeszłego wieku. Wykorzystywano je do obsługi gier.

Wraz z upływem lat technologia rękawic przewodowych była sukcesywnie rozwijana, dzięki czemu rejestrowały one ruchy użytkownika z coraz większą dokładnością. Były także coraz lżejsze, co przekładało się na zwiększenie komfortu ich użytkowania. Mimo to konieczność włożenia rękawicy w dalszym ciągu stanowi barierę dla upowszechnienia się tego typu interfejsów.

Równolegle prowadzono prace nad alternatywnymi sposobami rozpoznawania gestów przy użyciu kamer i specjalnego oprogramowania. Pierwsze rejestrują ruch ręki, zaś drugie analizują te dane. W porównaniu do rękawic wyposażonych w sieć czujników metody te wymagają zazwyczaj większej mocy obliczeniowej, choć istnieją również ich prostsze wersje.

Rozpoznawanie gestów

Przykładowo jeden z łatwiejszych sposobów polega na wykrywaniu w obrazie zarejestrowanym przez kamerę 2D charakterystycznych punktów na dłoni. Metoda ta sprawdza się w głównie w prostszych zadaniach, na przykład wówczas, kiedy trzeba policzyć palce. Na wiarygodność wyników mają jednak w jej przypadku duży wpływ oświetlenie i zabarwienie skóry.

Innym rozwiązaniem jest porównywanie zapisanego obrazu z innymi z biblioteki różnych gestów. W taki sposób skutecznie można rozpoznać te najprostsze, jak na przykład otwarcie i zamknięcie dłoni, którym przypisuje się czynności takie jak na przykład uruchomienie i zamknięcie programu albo odblokowanie i zablokowanie urządzenia.

Bardziej złożona interakcja z obiektami w przestrzeni trójwymiarowej wymaga użycia bardziej zaawansowanych rozwiązań. Przykładem są te zastosowane w kontrolerze ruchu Kinect firmy Microsoft , który wyposażono m.in. w dwie kamery, w tym jedną na podczerwień.

Aplikacja a realizacja

Z upływem czasu, w miarę rozwoju technologii sterowania gestami, przybywa wariantów jej implementacji. Są one zoptymalizowane pod kątem różnych specyficznych cech interakcji, na przykład o różnym zasięgu, bliskim i dalekim, rozpoznawania ruchów o małej rozdzielczości przestrzennej i interpretacji ruchów całego ciała, ciągłego śledzenia ruchu oraz rozpoznawania tego krótkotrwałego. Z każdym z tych wariantów wiąże się inny kontekst użytkowania.

Na przykład krótki zasięg jest wymagany zwykle w przypadku urządzeń przenośnych, takich jak smartfony czy tablety, z większej odległości ruchem ręki steruje się natomiast m.in. telewizorami czy dekoderami. W obu przypadkach priorytetem jest wygoda użytkownika oraz skuteczność rozpoznania gestów, jednak różnica w dystansie ma znaczący wpływ na szczegóły realizacji, podobnie jak fakt, że nawigując po menu smart TV, użytkownik wykonuje drobne gesty, natomiast grając, porusza całym ciałem.

Podobnie projektant interfejsu bezdotykowego tego typu powinien uwzględnić specyfikę rozpoznawania gestów krótkotrwałych, jakie wykonuje czytelnik, machając dłonią z lewej na prawą lub w odwrotnym kierunku, aby przewrócić stronę e-booka, czy słuchacz, który przełącza się na kolejny utwór z playlisty, a inaczej podejść do zadania ciągłego monitorowania ruchu ręki podczas nawigowania po menu smart TV.

Każda z aplikacji ma zatem specyficzne wymagania, których spełnienie uzależnione jest od właściwego skonfigurowania najważniejszych komponentów systemu rozpoznawania gestów, tzn. procesora o odpowiedniej mocy obliczeniowej, czujników o właściwej rozdzielczości i algorytmów przetwarzania odpowiednio interpretujących zarejestrowane obrazy. Wysiłki podejmowane w tym celu będą się opłacać, bowiem technologia sterowania ruchem ręki na odległość ma ogromny potencjał.

Ważna zaleta sterowania gestami

Sterowanie gestami ma wiele zalet. Poza tym, że jest intuicyjne i wygodniejsze dla użytkownika, warto również podkreślić aspekt praktyczny interfejsów bezdotykowych - sterowanie gestami nie zużywa urządzenia w takim stopniu, jak używanie tradycyjnej klawiatury czy ekranu dotykowego. Choć prawidłowo zaprojektowane mogą działać bez problemu przez lata, regularne korzystanie z nich prowadzi nieuchronnie do ich stopniowego niszczenia się.

Przewiduje się, że sterowanie gestami zapewni zupełnie nowe możliwości w zakresie interakcji człowiek-urządzenie i to w wielu dziedzinach, w których do tej pory w tym zakresie były one raczej ograniczone. Jedną z nich jest handel.

W tym przypadku sterowanie gestami w połączeniu z techniką rozpoznawania twarzy ułatwi nawiązywanie relacji z klientami. Na przykład rozszerzenie funkcjonalności wyświetlaczy, na których obecnie prezentowane są predefiniowane treści promocyjne, o możliwość ich wybierania przez kupujących sprawi, że dotychczas bierny ekran stanie się dla nich cyfrowym konsultantem. Zwiększy to ich zainteresowanie ofertą sklepu, co z pewnością przełoży się na większą sprzedaż.

Przewiduje się też, że sterowanie gestami znajdzie wiele zastosowań w samochodach, i to zarówno w interakcji z urządzeniami pokładowymi, jak i na zewnątrz auta.

Sterowanie gestami - przegląd zastosowań

W tym drugim przypadku można wykorzystać kamery systemów bezpieczeństwa zainstalowane z tyłu pojazdu, zapewniające kontrolę cofania i te w lusterkach bocznych, będące częścią systemu, który informuje kierowcę o pojawieniu się obiektów w martwym polu. Kamery powinny się automatycznie uruchamiać, gdy czujnik zbliżeniowy wykryje, że kierowca podchodzi do samochodu. Wtedy będzie on mógł gestem otworzyć drzwi albo klapę bagażnika auta.

Wewnątrz pojazdu sterowanie urządzeniami pokładowymi za pomocą gestów jest bezpieczniejsze, szybsze i wygodniejsze niż korzystanie z przycisków czy pokręteł, w celu na przykład odebrania połączenia telefonicznego albo zmiany ustawienia urządzeń multimedialnych, których w autach przybywa.

Ruchem ręki będzie też można z pewnością sprawniej sterować dronami. Prace nad bezzałogowymi statkami powietrznymi tego rodzaju, którymi będzie można kierować zdalnie bez korzystania z konsoli, już trwają.

Interfejsy bezdotykowe tego typu mogą okazać się przydatne również dla osób niepełnosprawnych, które nie są w stanie korzystać z klawiatury, myszki, a nawet ekranu dotykowego. Prowadzi się ponadto badania nad wykorzystaniem technik rozpoznawania gestów do tłumaczenia języka migowego na tekst albo mowę.

Sterowanie głosem

Na koniec przedstawiamy jeszcze jedną technologię interfejsów bezdotykowych - sterowanie głosem. Interfejsy głosowe VUI (Voice User Interface) pozwalają na interakcję użytkownika z maszyną za pośrednictwem komend słownych, bez konieczności używania rąk, a nawet kontaktu wzrokowego. Dzięki temu nie musi on skupiać całej uwagi na takim urządzeniu.

Przykładami VUI są: inteligentne głośniki Apple Home Pod z osobistym asystentem Siri, głośniki smart Google Home oraz głośniki Amazon Echo z inteligentnym osobistym asystentem Alexą. Do tej grupy zalicza się też aplikacje z interfejsem głosowym, które są uzupełnieniem tradycyjnych graficznych interfejsów użytkownika na przykład w smartfonach czy smart TV.

Projektując VUI, nie można opierać się na podobnych zasadach jak w projektowaniu GUI. Podstawową tego przyczyną jest to, że w przypadku tych pierwszych nie ma możliwości wizualnego oddziaływania na użytkownika. I choć wciąż trudno oczekiwać, że korzystanie z interfejsu głosowego dorówna rozmowie z drugim człowiekiem, w dziedzinie VUI w ostatnich latach nastąpił znaczący postęp. Aby komunikacja człowiek-maszyna była w tym przypadku jak najefektywniejsza, spełnionych musi być jednak kilka warunków.

Przede wszystkim użytkownika powinno się poinformować o tym, co może za pośrednictwem VUI osiągnąć. Inaczej, niż w przypadku GUI, w którym można wizualnie wyróżnić poszczególne opcje, w VUI nie ma bowiem możliwości pokazać mu tego na ekranie. Dlatego nowi użytkownicy swoje oczekiwania będą opierać na doświadczeniach z konwersacji z ludźmi.

W efekcie mogą zadawać pytania niezrozumiałe dla urządzenia lub zlecać zadania, których nie będzie w stanie wykonać. Rozwiązaniem jest przedstawienie listy funkcji dla każdej z opcji. Ważne jest, aby jedną z nich była możliwość zrezygnowania w dowolnym momencie i powrotu do głównego menu.

Inaczej, niż w przypadku GUI, w VUI użytkownik może też mieć trudność ze zorientowaniem się, z jakiej funkcji aktualnie korzysta. Dlatego odpowiedź z systemu powinna nieść ze sobą jak najwięcej informacji przydatnych w rozeznaniu się, czego dotyczy. Na przykład, jeżeli użytkownik zapyta o prognozę pogody, urządzenie odpowiadając, powinno doprecyzować, dla jakiej daty i lokalizacji podaje te dane.

Projektowanie VUI

W przykładach, ilustrujących korzystanie z VUI, warto zasugerować użytkownikowi, aby komunikując się z nim, był jak najbardziej precyzyjny, przekazując jak najwięcej informacji dotyczących swojego zapytania. Ludzie bowiem komunikując się, stosują często skróty myślowe, których VUI oczywiście nie zrozumie.

W przykładach, ilustrujących korzystanie z VUI, warto zasugerować użytkownikowi, aby komunikując się z nim, był jak najbardziej precyzyjny, przekazując jak najwięcej informacji dotyczących swojego zapytania. Ludzie bowiem komunikując się, stosują często skróty myślowe, których VUI oczywiście nie zrozumie.

Bardzo ważne dla pozytywnego odbioru interfejsu głosowego jest również to, aby nie przytłoczyć użytkownika nadmierną ilością informacji. Dużej liczby opcji może on nie zapamiętać, a rozbudowana odpowiedź może go wprawić w zakłopotanie, jeżeli jej nie zapamięta bądź w natłoku danych jej nie zrozumie.

Istotne jest również to, aby mimo wszystko, w jakiejś możliwie najprostszej wizualnej formie przekazywać użytkownikowi potwierdzenie tego, że urządzenie "słucha" jego przekazu. W przeciwnym wypadku, jeżeli VUI zareaguje dopiero wówczas, kiedy człowiek skończy mówić, w trakcie swojej wypowiedzi może on nie być pewny, czy urządzenie działa.

To z kolei rodzi frustrację podobną do tej, jaką odczuwamy podczas rozmowy przez telefon, gdy nasz rozmówca nie reaguje na to, co mówimy. Dlatego na przykład interaktywne głośniki, takie jak Alexa, po ich wywołaniu sygnalizują nasłuchiwanie przez włączenie lub zmianę koloru oświetlenia zainstalowanego w ich obudowie. Można to przyrównać do niewerbalnego potakiwania przez poruszanie głową przez bierną ze stron "prawdziwej" rozmowy.

Nie ulega wątpliwości, że zaprojektowanie interfejsu głosowego, który już na wstępie nie rozczaruje użytkowników, nie jest łatwym zadaniem, a już na pewno dużo trudniejszym niż zaprojektowanie GUI. Niemniej jednak warto podjąć ten wysiłek, bowiem skoro już udało się VUI skomercjalizować, z pewnością głosowe sterowanie będzie się upowszechniać.

Monika Jaworowska