Aby ten efekt zmniejszyć, równocześnie rozwijano techniki stabilizacji obrazu. Ich zadaniem jest niedopuszczenie do zniekształcenia obrazu przez rozmycie pikseli i powstanie niepożądanych artefaktów dzięki skompensowaniu drgań aparatu w czasie wykonywania zdjęcia.

Trzeba w tym miejscu wyraźnie zaznaczyć, że chodzi jedynie o wstrząsy o stosunkowo niewielkim nasileniu spowodowane tym, że fotografujący trzyma aparat w ręku. Funkcja stabilizacji obrazu nie zapobiega bowiem jego rozmywaniu się spowodowanemu przez ruch fotografowanego obiektu ani też przez nienaturalne (celowe) i silne poruszanie aparatem.

Mechanizm drżenia

Warto w tym właśnie miejscu zaznaczyć, że drżenie jest naturalnym (fizjologicznym) odruchem, który występuje u wszystkich ludzi. Można je opisać jako: mimowolny ruch oscylacyjny części ciała generowany bezpośrednio przez mięśnie podczas ich aktywności, gdy kurczą się i odprężają w powtarzalny sposób. Nie jest ono dostrzegalne wyraźnie gołym okiem. Nie zależy również od wieku, natomiast na jego nasilenie ma wpływ indywidualna zdolność mięśni do utrzymania ciała w pozycji ustalonej przez przeciwdziałanie sile grawitacji. Przykładem sytuacji, w której występuje opisywane drżenie, w tym przypadku mięśni ramion, jest stanie i jednocześnie trzymanie smartfona w wyciągniętych przed siebie rękach.

Obraz próbuje się stabilizować różnymi metodami. Dwie najpopularniejsze to: elektroniczna stabilizacja obrazu (Electronic Image Stabilization, EIS) oraz optyczna stabilizacja obrazu (Optical Image Stabilization, OIS).

Na czym polega EIS?

EIS to metoda kompensacji cyfrowej, w której w celu zminimalizowania wpływu drżenia rąk na finalną jakość obrazu korzysta się ze skomplikowanych algorytmów przetwarzania obrazów. W tym przypadku zatem stabilizacja jest realizowana wyłącznie programowo.

W praktyce (w uproszczeniu) polega to na tym, że w pamięci zapisywana jest ramka odniesienia, z którą następnie będą porównywane kolejno wykonywane ujęcia. Na podstawie analizy różnic występujących pomiędzy nimi następujące po sobie klatki zostają odpowiednio skorygowane.

Dokładniej polega to na tym, że w ramce odniesienia wyszukiwane są punkty, które przyjmuje się za wzorcowe. Ich położenie jest odnotowywane. Dalej są one wyszukiwane w kolejnych ramkach i obraz jest modyfikowany w taki sposób, żeby zachować ich w miarę niezmienione współrzędne.

Zalety i wady metody EIS

Wśród zalet tej metody wymienić należy: niski koszt implementacji i oszczędność miejsca w urządzeniu ze względu na to, że jako technika realizowana wyłącznie programowo EIS nie wymaga doposażenia urządzenia w żadne dodatkowe mechanizmy sprzętowe i niezawodność, również ze względu na brak elementów mechanicznych, które mogłyby podczas użytkowania na przykład smartfona zostać uszkodzone albo ulec awarii.

Najważniejsze ograniczenie elektronicznej (cyfrowej) metody stabilizacji obrazów to natomiast słabsza jakość oraz mniejsza rozdzielczość obrazu w porównaniu do metody optycznej. Są one skutkiem poddania go stratnym przekształceniom według wyżej opisanego algorytmu.

Ponadto, ponieważ EIS opiera się tylko na danych z czujnika obrazu, mogą wystąpić trudności z korekcją obrazów, które wymagają odróżnienia rozmycia spowodowanego rzeczywistym ruchem obiektu szybko przemieszczającego się przed kamerą od tego wywołanego przez drgania dłoni. Jakość zapewniana przez EIS jest oprócz tego niższa przy dużym powiększeniu i słabym oświetleniu.

OIS

W przeciwieństwie do stabilizacji elektronicznej metoda optyczna nie wymaga modyfikowania zarejestrowanego obrazu. W zamian, ścieżka optyczna pomiędzy fotografowanym obiektem a czujnikiem obrazu jest śledzona i mechanicznie korygowana przez stosowne przemieszczenie kamery (a w praktyce jej elementów, o czym piszemy dalej). W rezultacie, nawet wtedy, gdy ręce fotografa będą się trzęsły, dzięki OIS trajektoria padania światła na czujnik obrazu nie ulegnie zmianie.

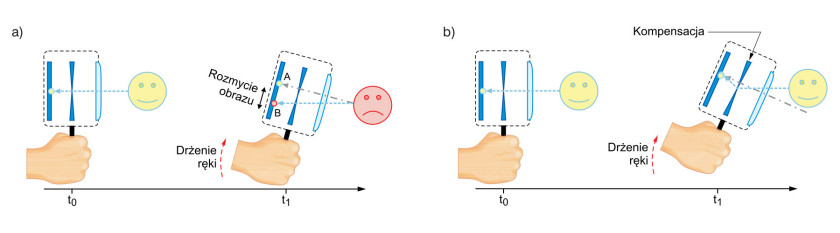

Zasada działania optycznej stabilizacji obrazu – w uproszczeniu i tylko w jednym kierunku, została wyjaśniona na rysunku 1. W przykładzie tym przyjęto, że wykonywane jest zdjęcie nieruchomego obiektu, zaś migawka pozostaje otwarta przez czas równy Δt. Na rysunku 1a przedstawiono, jak zmienia się trajektoria padania światła w przypadku braku kompensacji obrotu kamery spowodowanego mimowolnym ruchem ręki. Wynika z niego, że rozprasza się ono dla pojedynczego piksela na odcinku, który dzieli punkt A od punktu B. To niepożądane rozmycie zachodzi dla wszystkich pikseli, powodując rozmazanie całego obrazu.

Natomiast w razie zastosowania optycznej stabilizacji obrazu, jak wynika z rysunku 1b, soczewka przesunie się przeciwnie do kierunek obrotu kamery. Dzięki temu obraz zostanie ustabilizowany, tzn. obraz zarejestrowany w chwili t1 będzie się pokrywał z obrazem zarejestrowanym w chwili t0 (punkt A będzie równy punktowi B).

Realizacja OIS

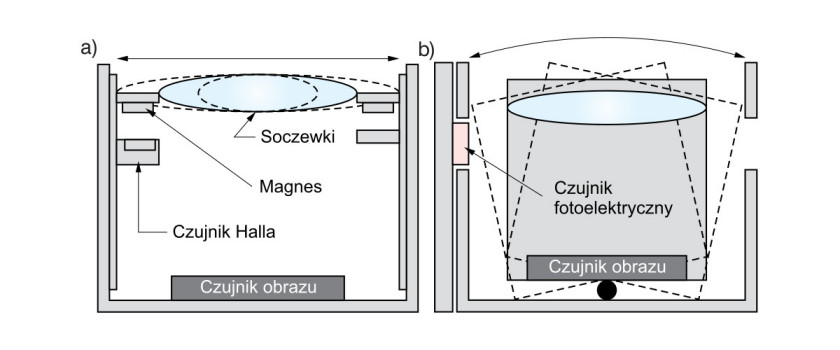

Optyczną stabilizację obrazu według powyższej zasady można zrealizować na kilka sposobów. Różnią się one zasadniczo elementem kamery, którego położenie jest korygowane w zależności od jej odchylenia spowodowanego drżeniem ręki (rys. 2). Jednym z rozwiązań jest korekcja ścieżki padania światła na światłoczułą matrycę poprzez regulację wyłącznie położenia soczewki modułu czujnika obrazu (rys. 2a). Alternatywą jest zmiana ustawienia całego modułu składającego się z sensora obrazu i układu optycznego, które to elementy pozostają względem siebie nieruchome (rys. 2b).

Drugie podejście pozwala na skompensowanie niekontrolowanych ruchów ręki użytkownika w większym zakresie. Kolejną jego zaletą jest zachowanie stałej odległości ogniskowej pomiędzy soczewkami a czujnikiem obrazu.

Komponenty OIS

Ważnym elementem konstrukcyjnym modułu kamery z optyczną stabilizacją obrazu są czujniki położenia, za pośrednictwem których śledzony jest ruch soczewki lub modułu czujnika. W tym zastosowaniu korzysta się najczęściej z jednego z dwóch typów sensorów. Są to, jak wynika z rysunku 2, czujniki Halla, które wykrywają zmiany natężenia pola magnetycznego lub sensory fotoelektryczne. W czujniki pierwszego rodzaju przeważnie wyposażane są układy optycznej stabilizacji obrazu, w których ruchomym elementem są soczewki modułu czujnika obrazu.

Sensory fotoelektryczne są z kolei najczęściej częścią układów, w których przemieszcza się cały moduł. Oprócz tego niezbędnym komponentem układów OIS, poza procesorem aplikacyjnym i elementami wykonawczymi, które wprawiają w ruch soczewki albo moduł czujnika obrazu, są żyroskopy.

Czym się mierzy drżenie kamery?

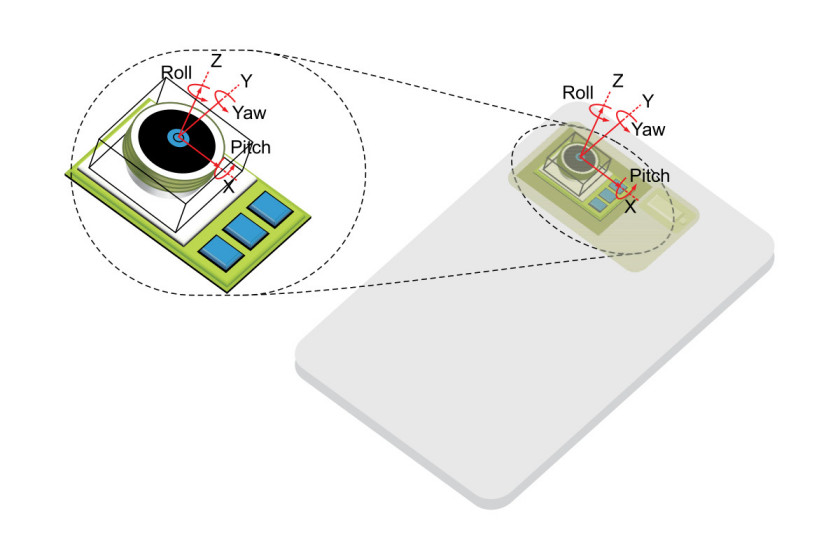

Dla wykrycia mierzy się prędkość kątową obiektów obracających się wokół jednej osi x (tzw. roll), y (pitch) lub z (yaw). Możliwe jest także wyznaczenie na tej podstawie (przez całkowanie) wartości kąta obrotu. W zależności od ustawienia czujnik przeznaczony do pomiaru prędkości kątowej wokół jednej aktywnej osi może również mierzyć ruch wokół pozostałych dwóch.

Czujniki żyroskopowe lepiej sprawdzają się w pomiarach drgań ręki niż akcelerometry, ponieważ efekt rozmycia obrazu, który jest powodowany liniowymi przesunięciami kamery, jest popomijalny w porównaniu z efektem wywołanym przez składową obrotu kątowego. Oznacza to, że drgania ręki człowieka, przeniesione na kamerę, najdokładniej mogą być mierzone przez śledzenie przemieszczenia kątowego przez żyroskop zintegrowany z modułem rejestratora obrazów. Na rysunku 3 zobrazowano, w jaki sposób system referencyjny czujnika żyroskopowego staje się systemem odniesienia całej platformy po umieszczeniu systemu optycznej stabilizacji obrazu wewnątrz urządzenia mobilnego.

Parametry żyroskopów

Można zaryzykować stwierdzenie, że żyroskop jest najważniejszym komponentem systemu optycznej stabilizacji obrazu, od jego dokładności zależy bowiem precyzja wyznaczania przemieszczenia kamery, a więc i dokładność, z jaką w stosunku do niego można będzie korygować ustawienie soczewki albo modułu obrazu.

Inne ważne parametry tego typu czujników to: możliwie najmniejsze opóźnienie fazowe, jak najbliższy zeru off set, odpowiedni zakres pomiarowy i szybkie interfejsy komunikacyjne, dzięki którym komunikacja z procesorem aplikacyjnym nie będzie źródłem dodatkowych niepożądanych opóźnień. Ze względu na integrację czujnika z urządzeniem mobilnym ważne parametry to także: jak najmniejszy rozmiar oraz energooszczędność.

Zalety OIS. Czym jest AIS?

W porównaniu z EIS, OIS redukuje rozmycie obrazu bez pogarszania jego jakości, szczególnie jeżeli porównać obie opisane w artykule techniki w przypadku ich zastosowania do obrazów rejestrowanych w słabym oświetleniu i z dużej odległości. Z drugiej jednak strony wymaga doposażenia urządzenia mobilnego w dodatkowe podzespoły. Z tym z kolei wiążą się: większe koszty realizacji, większa zajętość miejsca, jak również możliwość uszkodzenia albo awarii tych komponentów.

Chociaż obecnie obie przedstawione techniki stabilizacji obrazów w urządzeniach mobilnych dominują, przyszłość może należeć do metody AIS (Artificial Intelligence Stabilization). Opiera się ona na technikach sztucznej inteligencji. Pierwsze tego typu rozwiązania, stanowiące uzupełnienie standardowej optycznej stabilizacji obrazu, są już dostępne w urządzeniach mobilnych firmy Huawei.

Monika Jaworowska