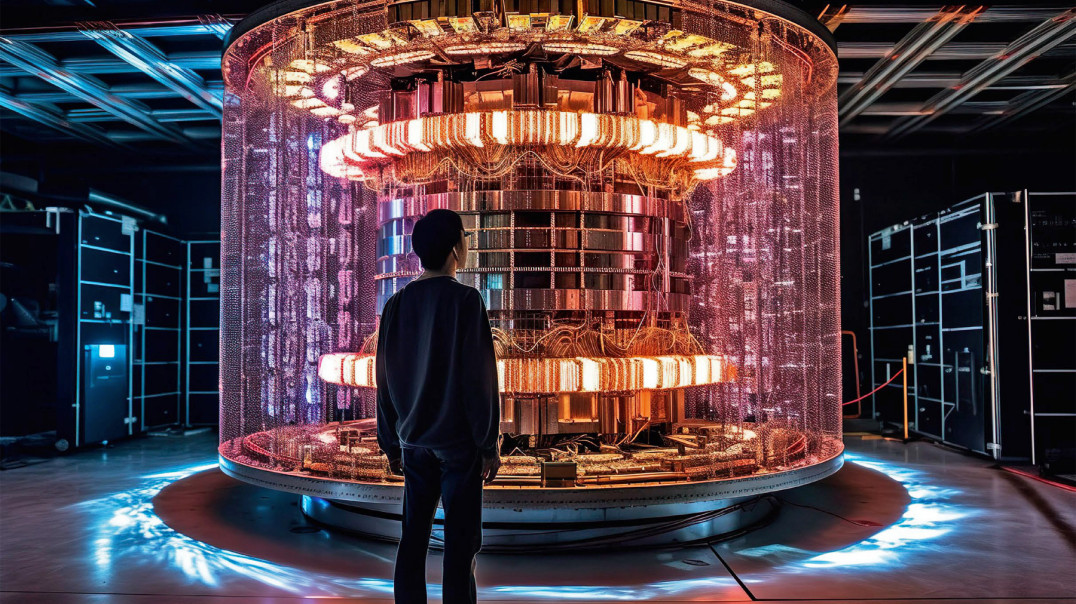

Komputery kwantowe nie są aż tak nowe, jak mogłoby się wydawać. Początki tej koncepcji sięgają 1981 roku i wizjonerskiej idei Richarda Feynmana. Zauważył on, że klasyczne komputery mają ograniczoną zdolność do symulowania zjawisk kwantowych, dlatego zaproponował stworzenie maszyny działającej zgodnie z prawami rządzącymi światem na najgłębszym, fundamentalnym poziomie. Podstawą działania komputerów kwantowych są kubity, które dzięki zasadzie superpozycji mogą znajdować się w dwóch stanach jednocześnie. Ta cecha sprawia, że urządzenia te oferują wykładniczo większą moc obliczeniową w porównaniu do tradycyjnych komputerów, umożliwiając rozwiązywanie zadań, które wcześniej uznawano za niewykonalne.

Zasada działania jest na pierwszy rzut oka trudna do pojęcia. Tradycyjny bit w komputerach może przyjmować wartość 1 lub 0. Kubit może przyjąć równocześnie 1 i 0. Choć technologia ta wciąż znajduje się na stosunkowo wczesnym etapie rozwoju, to dzięki wykorzystaniu zasad mechaniki kwantowej przy rozwiązywaniu złożonych problemów wzbudza ogromne zainteresowanie. Powstał więc termin kwantowej przewagi. I o nią toczy się technologiczna walka.

Kwantowa przewaga

Kwantowa przewaga to moment, w którym komputer kwantowy jest w stanie rozwiązać zadanie całkowicie nieosiągalne dla znanych nam maszyn. Nawet najszybszych i największych superkomputerów. Osiągnięcie takiego poziomu uznawane jest za jeden z głównych celów badań nad tą technologią, a w ostatnich latach wiele firm i instytucji ogłaszało, że udało im się tego dokonać. Uczciwie należy dodać jednak, że w bardzo kontrolowanych warunkach i jedynie w problemach teoretycznych, bez przełożenia na rzeczywistość i bez konkretnej wartości.

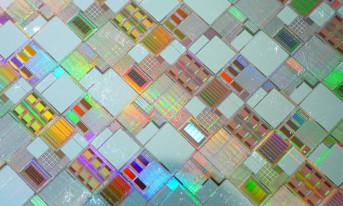

Jednym z najbardziej znanych przykładów jest procesor Sycamore opracowany przez Google. W 2019 roku zaprezentowano jego możliwości podczas eksperymentu z losowym próbkowaniem obwodów. W ramach testu zastosowano przypadkowe bramki kwantowe do tworzenia i pomiaru stanów kwantowych, a firma ogłosiła, że tego typu zadanie jest niewykonalne dla klasycznych systemów obliczeniowych. Faktycznie tak było, niemniej użyteczność tego rozwiązania była zerowa i czysto akademicka. Niemniej Google stało się kwantowym liderem. Ale na chwilę.

Dzięki swojej serii komputerów kwantowych Zuchongzhi, Chiny wyrosły na poważnego rywala w wyścigu kwantowym, podważając twierdzenia Google o całkowitej dominacji tego pola. Najnowsza wersja, Zuchongzhi 3.0, dysponuje 105 kubitami i charakteryzuje się wyjątkową dokładnością i wiarygodnością obliczeniową. Wykorzystując 83-kubitowy, 32-cyklowy obwód losowy, Zuchongzhi 3.0 również przeprowadził eksperyment próbkowania losowych obwodów, generując milion próbek w ciągu kilku sekund.

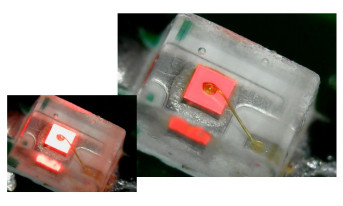

Wśród największych graczy nie może zabraknąć też IBM, który od dawna rozwija technikę tzw. cięcia obwodów, czyli rozbijania dużych układów na mniejsze fragmenty. Te podobwody mogą być wykonywane niezależnie na różnych jednostkach kwantowych, a następnie ich wyniki łączy się za pomocą obliczeń klasycznych. Rozwiązanie to pozwala działać poza naturalnymi ograniczeniami pojedynczych kwantowych jednostek obliczeniowych. Firma zademonstrowała tę metodę, łącząc dwa procesory Eagle po 127 kubitów każdy i uzyskując stany kwantowe obejmujące nawet 142 kubity.

Komputery kwantowe - niestety jesteśmy dekady od użyteczności

Pytanie, które ciśnie się jednak na usta brzmi „co dalej?”. Wizje przyszłości są niezmiernie intrygujące, ale ciężko nie mieć wrażenia, że mowa o przyszłości co najmniej odległej. Jensen Huang, prezes Nvidii, podkreśla, że według niego praktyczne zastosowania tej technologii wciąż są marzeniami. Huang szacuje, że naprawdę użyteczne komputery kwantowe pojawią się dopiero za 15–20 lat. Podobnie ostrożne podejście prezentuje wielu ekspertów, zwracając uwagę, że zanim komputery kwantowe osiągną pełnię możliwości, niezbędne są dalsze badania i rozwój.

Rozwój technologii kwantowej nie jest jednak dyscypliną indywidualną, którą naprzód posunie jedna sprawna firma. Złożoność zagadnień związanych z obliczeniami kwantowymi sprawia, że żadna firma ani nawet kraj nie zdoła samodzielnie doprowadzić projektu do perfekcji. Podobnie jak w przypadku lotu na Księżyc czy sekwencjonowania ludzkiego genomu, również tutaj sukces zależy nie tylko od pracy naukowców, lecz także od wieloletniego zaangażowania sektora publicznego i prywatnego. Potrzebne będą wspólne inwestycje, wymiana wiedzy i dalekosiężna dyplomacja naukowa, które umożliwią stworzenie globalnego ekosystemu kwantowego. A samo to wydaje się równie wielkim, jeśli nie nawet większym wyzwaniem od konstrukcji i projektowania maszyn.

Tym razem motywacja jest jednak większa. Rosnące potrzeby obliczeniowe AI pokazują, że świat już teraz zbliża się do granic możliwości klasycznych komputerów. Już teraz firmy takie jak OpenAI, Meta czy Google pracują nad olbrzymimi centrami danych zasilanymi własnymi elektrowniami. Dalszy rozwój w pewnym momencie przestanie być możliwy i dojdziemy do maksymalnej skali tradycyjnej komputeryzacji.