Mikrokontrolery i IoT - dobry zestaw startowy to dzisiaj podstawa

Coraz tańsze zestawy ewaluacyjne, nierzadko proste od strony sprzętowej, ale o dużych możliwościach oraz udostępniane za darmo środowiska programistyczne, biblioteki procedur, dotyczących obsługi elementów dotykowych lub zaawansowanej grafiki, powodują, że zacząć dzisiaj pracę z nową rodziną mikrokontrolerów nie jest tak trudno, jak kiedyś.

Coraz tańsze zestawy ewaluacyjne, nierzadko proste od strony sprzętowej, ale o dużych możliwościach oraz udostępniane za darmo środowiska programistyczne, biblioteki procedur, dotyczących obsługi elementów dotykowych lub zaawansowanej grafiki, powodują, że zacząć dzisiaj pracę z nową rodziną mikrokontrolerów nie jest tak trudno, jak kiedyś.

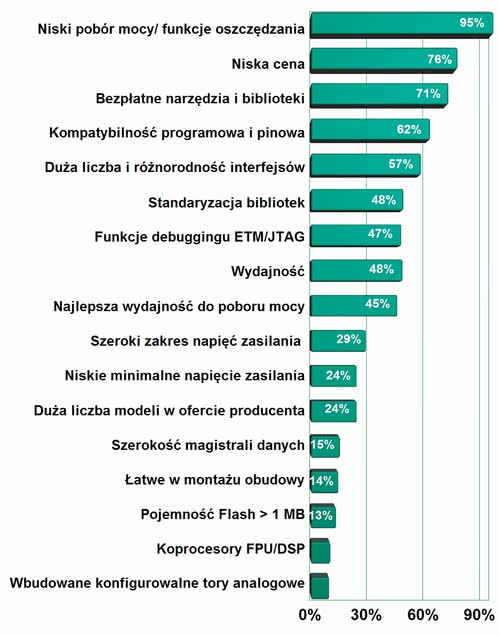

Niemniej pytania, który dostawca jest kompetentny, kogo się radzić w sprawach technicznych i czyje wskazówki brać pod uwagę, są cały czas aktualne, a nawet zyskują na wartości w miarę, jak tempo pojawiania się nowości się zwiększa. Stąd wybór dostawcy mikrokontrolerów oraz narzędzi staje się jednym z ważniejszych problemów związanych z mikrokontrolerami, bo podczas projektowania aplikacji z reguły można wybierać pomiędzy wieloma równorzędnymi układami i architekturami.

Dostępność i możliwości funkcjonalne zapewniane przez narzędzia projektowe dla mikrokontrolerów mają potencjalnie największy wpływ na rozwój tego sektora rynku. Płytka zawierająca mikrokontroler oraz inne specyficzne dla niej chipy, takie jak układ komunikacyjny, konwerter zasilający oraz czujniki, w praktyce stanowi większą część platformy sprzętowej dla popularnych aplikacji. Projektant oszczędza mnóstwo czasu z jej użyciem, bo może pracę zacząć natychmiast, ponosi mniejsze ryzyko projektowe, opierając się na sprawdzonym rozwiązaniu oraz chroni się przed pomyłkami, które jak wiadomo zdarzają się wszystkim.

Często zysk na czasie jest jeszcze większy, bo producent zestawu daje w komplecie oprogramowanie, biblioteki kluczowych procedur, stosy komunikacyjne lub narzędzia do konfiguracji. W innym przypadku trzeba by je tworzyć samemu lub samemu implementować kod ogólnie dostępny, a to znowu oznacza czas i pieniądze oraz niepotrzebne ryzyko. Nawet jeśli zestaw startowy, płytka ewaluacyjna lub testowa nie są za darmo, to per saldo i tak praca z ich użyciem się opłaca, bo dzisiaj czas inżynierski jest kosztowny.

Zestawy projektowe są dzisiaj w centrum uwagi rynku mikrokontrolerów także dlatego, że ogólnie liczba nowości, technologii, które warto znać i stosować, szybko się zwiększa. Nie ma już chyba fachowców, którzy samodzielnie byliby w stanie zrealizować cały skomplikowany projekt. Nikt nie zna się na wszystkim, obowiązuje specjalizacja i dzielenie się zadaniami. Wykorzystanie zestawów jest elementem takiej wspólnej pracy.

Coraz więcej narzędzi projektowych

Na skutek opisanych zjawisk w ostatnich trzech latach asortyment i dostępność w sieci sprzedaży płytek projektowych znacznie się polepszyły. Przełomem było pojawienie się komputera Raspberry Pi, ale dużo dobrego przyniosła wcześniej także platforma Arduino. One wielu biznesmenom otworzyły oczy.

Zestawy projektowe są też wdzięcznym materiałem do szkoleń i warsztatów, stając się bazą do tego, aby w ciągu jednego dnia przygotować przynajmniej szkielet aplikacji. Nierzadko uczestnicy szkoleń mogą zabrać wykorzystywane zestawy ze sobą, po to, aby pracować na nich dalej. To, że inżynierowie są tym zainteresowani widać po dużej frekwencji na szkoleniach.

Kolejny ważny trend zmieniający rynek mikrokontrolerów jest taki, że zestawy projektowe, nawet te darmowe lub oferowane za symboliczne sumy, mają całkiem spore możliwości. Producenci dotują takie konstrukcje, instalując tam kosztowne elementy, takie jak FPGA lub nowoczesne czujniki MEMS itp. Działania te mają na celu popularyzację nowych technologii i sztandarowych produktów, bo wiadomo, że w handlu detalicznym (katalogowym) nie wszystko pojawia się od razu ani też nie dzieje się automatycznie. Tylko producent jest w stanie wypuścić na rynek zestaw ewaluacyjny równolegle z premierą nowego mikrokontrolera i taka możliwość jest wykorzystywana.

Miniaturyzacja i montaż SMT

Ostatnią kwestią wpływającą na szybko rosnącą popularność zestawów projektowych jest miniaturyzacja. Wraz z rosnącym znaczeniem elektroniki konsumenckiej na rynku, duża część wolumenu produkcyjnego producentów chipów trafia do urządzeń produkowanych masowo. Wytwórcy ograniczają więc liczbę dostępnych obudów, nierzadko wyłącznie do tych najmniejszych, jak BGA i QFN. Jeszcze kilka lat temu były one zarezerwowane dla złożonych układów cyfrowych, takich, które stanowią jądro systemu cyfrowego (procesor, układ graficzny, matryca programowalna), ale widać, że obecnie montowane są w nich także układy średniej skali integracji, na przykład kontrolery zasilaczy, wzmacniacze operacyjne, układy komunikacyjne.

Montaż płytki prototypowej wymaga skorzystania z procesu SMT, co nie zawsze jest możliwe, łatwe, tanie i szybkie. Dlatego płytka ewaluacyjna, nawet jeśli zawiera jedynie chip i złącze, jest dla konstruktora zawsze cenna. Miniaturyzacja i coraz większa złożoność projektów zmuszają też konstruktorów do sięgania po płytki wielowarstwowe. O ile płytkę dwuwarstwową można zlecić stosunkowo niedrogo i wykonać w parę dni, o tyle 4-warstwowa to już wyraźnie większy wydatek i dłuższy termin realizacji.

Projektować aplikację razem z klientem

Skoro mikrokontroler jest centralną częścią prawie każdej aplikacji, wybór tego a nie innego układu przez konstruktora staje się zagadnieniem kluczowym dla rynku dystrybucji. Wiele działań obliczonych jest na to, aby nie czekać na pytanie ofertowe, ale podejmować takie działania, aby jak najwięcej układów z listy BOM pochodziło z własnej oferty handlowej.

W praktyce oznacza to właśnie opisane wyżej mechanizmy, a więc prowadzenie szkoleń i warsztatów, przekazywanie próbek chipów i zestawów startowych, dokumentacji i konsultacje inżynierskie. Ukierunkowany szkoleniami konstruktor, wzbogacony o narzędzia, z większym prawdopodobieństwem zdecyduje się na proponowany chip w projekcie, a potem jego decyzja zaowocuje sprzedażą. Strategia tych działań jest jasna - ofertę trzeba prezentować klientom jak najwcześniej, najlepiej gdy rysują schemat.

Wersje specjalizowane pod aplikacje

Mówiąc ogólnie, mikrokontroler tym różni się od mikroprocesora, że jest w stanie funkcjonalnie pracować bez konieczności dołączania z zewnątrz dodatkowych obwodów peryferyjnych. Patrząc wstecz, nietrudno dostrzec, że wraz z każdą kolejną generacją i nową architekturą mikrokontrolery zawierają coraz więcej obwodów peryferyjnych oraz tracą swój ogólny charakter. Wiele jednostek jest ukierunkowanych do pracy w określonych aplikacjach i zawiera zestaw obwodów peryferyjnych kompletny z punktu widzenia zastosowań aplikacyjnych

. Przykładem mogą być układy z obwodami analogowymi przeznaczone do pracy w zasilaczach cyfrowych, jednostki z wbudowanym transceiverem do komunikacji bezprzewodowej lub mikrokontrolery o bardzo niskim poborze mocy i z wysokorozdzielczym przetwornikiem A/C, a także blokiem obliczeniowym do kalkulacji zużycia mediów.

Wersje specjalizowane kierowane są także do motoryzacji, do aplikacji przetwarzających sygnały (z funkcjami DSP i koprocesorem matematycznym), do urządzeń ze sterownikiem ekranu lub przycisków dotykowych, kontrolerem wyświetlacza i tak dalej. Wymagania rynku są takie, że z czasem będzie ich jeszcze więcej, bo zawsze rozwiązanie maksymalnie zintegrowane będzie w centrum uwagi, nie tylko z uwagi na cenę.

Silnie połączona z tematyką mikrokontrolerów jest komunikacja bezprzewodowa, co wynika z ekspansji aplikacji IoT oraz popularności połączeń tego typu w każdej dziedzinie techniki. Mikrokontrolery z wbudowanymi transceiverami przebijają się coraz częściej w aplikacjach, bo wiedza i doświadczenie projektantów jest znacznie bogatsze niż pięć-dziesięć lat temu, a producenci półprzewodników znacznie lepiej wspierają tych, którzy się decydują na taki krok.

Przy wykorzystaniu projektów referencyjnych, narzędzi i oprogramowania dostarczanego przez producentów ryzyko niepowodzenia jest minimalne, dlatego gdy tylko skala projektu wchodzi w zakres średnich serii, a produkt ma charakter konstrukcji zamkniętej, rozwiązania scalone jednoukładowe stają się konkurencją dla modułów komunikacyjnych.

Niski pobór mocy

Rosnące znaczenie elektroniki mobilnej, sieci rozproszonych, komunikacji bezprzewodowej, a więc urządzeń zasilanych najczęściej z baterii, przekłada się na rynek mikrokontrolerów w tematyce niskiego poboru mocy. Aplikacje zużywające do swojego działania minimalną ilość energii są na topie i co chwila padają jakieś rekordy, np. w zakresie czasu pracy na jednym komplecie baterii.

Nowe technologie pozwalają na usypianie działania procesora i szybkie wybudzanie, automatyczne dopasowanie wydajności do realizowanych zadań, skalowanie napięcia zasilania i inne podobne techniki. Są układy z autonomicznie działającymi układami peryferyjnymi, które mogą samodzielnie wymieniać dane bez udziału procesora. W zakresie niskiego poboru mocy producenci z pewnością nie powiedzieli jeszcze ostatniego słowa, wraz z kolejnymi rekordami można liczyć na wzrost popularności zasilania energią wolnodostępną (energy harvesting), przed którą widać wielki potencjał i która powinna być głównym źródłem zasilającym dla aplikacji elektroniki noszonej (wearables).

Ceny maleją

Mikrokontrolery są coraz tańsze, co może niekoniecznie widać w cenach bezwzględnych, ale z pewnością daje się dostrzec pod względem stosunku ceny do możliwości (wydajność, pamięć, układy peryferyjne). Funkcjonalność, jaką dostaje się za symbolicznego dolara, jest bardzo duża i niemożliwa do osiągnięcia w jakimkolwiek rozwiązaniu bazującym na elementach dyskretnych. Wydajność i zasoby sprzętowe wielu mikrokontrolerów 32-bitowych dostępnych na rynku od firm, takich jak Microchip, Atmel, TI oraz oczywiście ARM, są na tyle imponujace, że można na nich zainstalować "duży" system operacyjny, jak Linux lub Android.

Projektanci przez cały czas szukają oszczędności na najdroższych układach stosowanych w modułach elektronicznych, stąd wynika prawdopodobnie zapotrzebowanie na tanie mikrokontrolery, które nie muszą być uniwersalne. To zapewne też przyczyna, dla której jednostki 8-bitowe cały czas znajdują chętnych, bo takiego mikrokontrolera opłaca się użyć nawet do prostych funkcji logicznych.

Kolejną odsłonę możliwości integracji i obniżki cen przynoszą układy SoC (system na krzemie) zawierające w jednym chipie praktycznie całą aplikację (procesor, pamięć, komunikację).

ARM-y i SoC-e

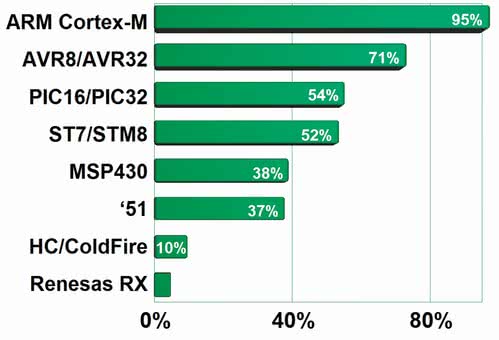

Jak doskonale wiadomo, w zakresie wydajnych mikrokontrolerów największe znaczenie na rynku mają 32-bitowe układy ARM Cortex. Ich atutem jest niska cena, dobra możliwość integracji w ramach jednochipowego układu SoC, niski pobór mocy, możliwość instalacji i obsługi systemu operacyjnego Android lub Linux Embedded oraz wsparcie ze strony dużych producentów półprzewodników zaangażowanych w ARM-y, np. NXP/Freescale (i.MX, LPC), Texas Instruments (Sitara i OMAP), Atmel (SAM), STMicroelectronics (STM32).

Pod każdą z tych nazw kryją się całe rodziny układów różniące się taktowaniem, pamięcią, układami peryferyjnymi itd. tak, że w sumie całość obejmuje kilka setek jednostek, dla których dostępna jest masa narzędzi projektowych i oprogramowania.

ARM-y zawojowały świat mikrokontrolerów i widać, że rodzina ta stała się standardem takim, jak kiedyś była słynna 51. Na ARM- y przechodzą powoli nawet najbardziej konserwatywni projektanci, znają je młodzi inżynierowie kończący studia, co dobrze wróży na przyszłość.

Znaczenie układów ARM powiększają rozwiązania SoC, które stają się bazą małych komputerków jednopłytkowych i rozwiązań modułowych. Niby to już inna kategoria układów i segment rynku, ale od strony architektury to dalej homogeniczna całość.

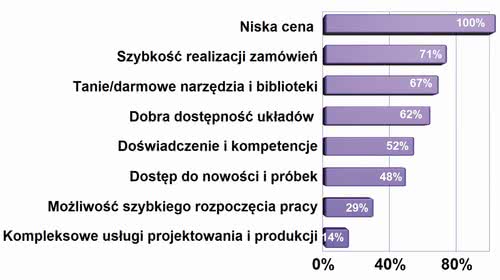

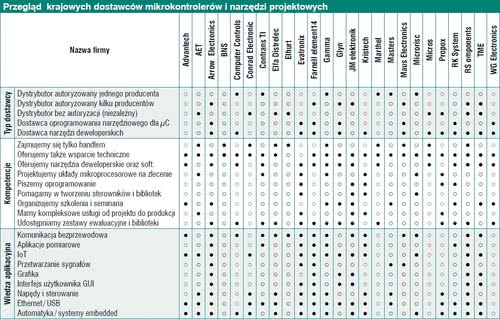

Dostawcy mikrokontrolerów

W zasadzie można powiedzieć, że wszystkie firmy dystrybucyjne, które sprzedają półprzewodniki, mają też mikrokontrolery, bo inne działania byłyby nienaturalne. Niemniej czasem zaangażowanie jest wyraźnie większe i sięga znamion specjalizacji, zwłaszcza gdy dystrybutor jest związany ze znanym producentem i występuje na rynku jako autoryzowany dystrybutor.

Są to np. Arrow, Masters i Future, mające w ofertach wiele linii takich produktów, często wszystkie popularne, a także TME i Gamma (Microchip), JM elektronik (Atmel i Holtek) oraz Contrans TI (Texas Instruments). Druga grupa dostawców łączy firmy powiązane umowami z mniej popularnymi producentami mikrokontrolerów, jak Marthel (Nuvoton Technology), Glyn (Renesas).

Osobną kategorię tworzą przedsiębiorstwa, które sprzedają głównie narzędzia projektowej, takie jak oprogramowanie, programatory i płytki uruchomieniowe do projektów. Takie oferty mają WG Electronics, Evatronix, Computer Controls, Kamami i RK-System, w części także Propox.

Tytułową tematyką zajmują się wszystkie firmy katalogowe (Farnell, RS, Elfa, Conrad, TME), które w ostatnich latach znacznie i przekrojowo poszerzyły swoje oferty w zakresie narzędzi projektowych, bo chipy sprzedawały zawsze, a także grono firm niezależnych w omawianym obszarze (Elhurt, Micros, BNS i inne). W gronie dostawców są też firmy od przemysłowego IoT takie jak Advantech, bo od tej strony wiele granic też się już zaciera.

Komponenty i moduły do komunikacji przewodowej i bezprzewodowej

Rynek sprzętu do komunikacji kryje w sobie ogromny asortyment produktów, jest ich na tyle dużo, że nietrudno pogubić się w analizie dostępnych wykonań, standardów, pasm częstotliwości pracy, wydajności, dostępnych zasobów sprzętowych, przeznaczenia aplikacyjnego, nie mówiąc już o szczegółach takich, jak zakres temperatur pracy lub odporność środowiskowa. Wiele produktów jest podobnych do siebie i nierzadko różni się jedynie drobnymi niuansami technicznymi, co utrudnia analizę ich właściwości oraz komplikuje proces doboru najlepszej opcji do danej aplikacji.

Rynek sprzętu do komunikacji kryje w sobie ogromny asortyment produktów, jest ich na tyle dużo, że nietrudno pogubić się w analizie dostępnych wykonań, standardów, pasm częstotliwości pracy, wydajności, dostępnych zasobów sprzętowych, przeznaczenia aplikacyjnego, nie mówiąc już o szczegółach takich, jak zakres temperatur pracy lub odporność środowiskowa. Wiele produktów jest podobnych do siebie i nierzadko różni się jedynie drobnymi niuansami technicznymi, co utrudnia analizę ich właściwości oraz komplikuje proces doboru najlepszej opcji do danej aplikacji.

Z pewnością łatwo wymienić kilka czynników sprzyjających rozwojowi rynku komunikacji, ale najlepiej skupić się na tych najważniejszych. Do takich trendów zaliczyć można Internet Rzeczy (IoT) oraz jego odmiany przemysłowe IIoT oraz Przemysł 4.0, a także Smart City i AMR. Pojęcia te szybko zmieniają współczesny świat techniki i sposób, w jaki rozwiązywane są problemy z dostępem do informacji rozproszonej (przetwarzanie w chmurze i aplikacje Big Data). Jeśli prognozy rynkowe opisujące rozwój rynku takich produktów i związanych z nimi usług sprawdzą się nawet tylko częściowo, w kolejnej dekadzie rzeczywistość przemysłowa i konsumencka zmieni się nie do poznania.

Komunikacja bezprzewodowa zawsze była elementem swobody działania, za który wiele osób było skłonnych płacić więcej. Dzisiaj elementy infrastruktury na tyle potaniały (usługi, sprzęt), że w wielu przypadkach komunikacja przewodowa jest droższa pod względem inwestycyjnym.

W niebyt odeszło również przekonanie co do zawodności medium bezprzewodowego. Przez lata kabel był postrzegany jako coś znacznie pewniejszego do wymiany danych w przemyśle. Automatycy bardzo nieufnie podchodzili nawet do Wi-Fi w halach produkcyjnych, a wszystkie nowinki musiały długo czekać na zainteresowanie lub przynajmniej przejść przez żmudny proces walidacji i dostosowania do wymogów rynku profesjonalnego. Ten niepokój to też już przeszłość i dzisiaj komunikacja bezprzewodowa jest normalną częścią przemysłu, wojska, medycyny. Co więcej, nie tylko nie jest elementem pogarszającym jakość, ale przeciwnie - za pomocą systemów komunikacji bezprzewodowej tworzone są alternatywne kanały komunikacji na wypadek awarii.

Technologie komunikacji są dzisiaj narzędziem do zapewnienia wysokiej jakości w produkcji, w usługach, logistyce i wielu innych dziedzinach. Wiele z nich pozwala jednocześnie obniżyć koszty i a nakłady inwestycyjne i modernizacyjne szybko się zwracają. Rynek zaczyna więc przypominać kulę śnieżną na zboczu góry.

Rynek M2M osiągnął już na tyle duży potencjał, że wspierają go operatorzy sieci komórkowych poprzez system taryf dopasowanych do potrzeb telemetrii, obsługę chipowych kart SIM i oprogramowanie pozwalające zarządzać dużą liczbą kart. Takie wsparcie jest ważne, bo sprzyja powstawaniu większych projektów.

Na koniec warto zauważyć, że czynnikiem sprzyjającym rozwojowi rynku są nowe technologie komunikacji o właściwościach ściśle dopasowanych do wymogów aplikacyjnych. Coraz częściej okazuje się, że popularne i szeroko dostępne technologie jak oczywiście GSM słabo pasują do wymagań świata IoT (za duża wydajność), a w innych aplikacjach unika się standardów wymagających płacenia licencji lub opłaty za dzierżawę częstotliwości. Z jednej strony coraz większa liczba rozwiązań komunikacyjnych przeszkadza w budowaniu świadomości rynku, ogranicza wiedzę użytkowników oraz skazuje wiele inicjatyw na porażkę, z drugiej strony trudno wyobrazić sobie rozwój w oparciu o jedno medium komunikacyjne.

Wiele produktów i standardów

Atrakcyjność rynku komunikacji, zwłaszcza tej bezprzewodowej ściąga na rynek wielu producentów, przez co nierzadko obok siebie funkcjonują produkty o równoważnej funkcjonalności, są tylko sprzedawane przez inne firmy dystrybucyjne. Problemy z selekcją produktów pogłębia powierzchowna wiedza wielu dostawców i klientów, którzy nierzadko zamiast wyjaśniać, pogłębiają bałagan. Warto więc przez chwilę skupić się na tym, co jest dostępne.

Atrakcyjność rynku komunikacji, zwłaszcza tej bezprzewodowej ściąga na rynek wielu producentów, przez co nierzadko obok siebie funkcjonują produkty o równoważnej funkcjonalności, są tylko sprzedawane przez inne firmy dystrybucyjne. Problemy z selekcją produktów pogłębia powierzchowna wiedza wielu dostawców i klientów, którzy nierzadko zamiast wyjaśniać, pogłębiają bałagan. Warto więc przez chwilę skupić się na tym, co jest dostępne.

Ogólną kategoryzację rynku najłatwiej zacząć od produktów elementarnych, czyli chipów komunikacyjnych. Ich zadaniem jest zwykle budowa warstwy fizycznej łącza, a więc modemu i analogowej części radiowej odpowiedzialnych za modulację i emisję, bardziej skomplikowane wersje mają też część cyfrową odpowiedzialną za pakietowanie danych, realizację protokołu lub obsługę danego standardu.

Same chipy komunikacyjne są zwykle mało użyteczne, gdyż wymagają najczęściej dodania mikrokontrolera zarządzającego ich pracą, stworzenia oprogramowania integracji wewnątrz urządzenia oraz co jest także bardzo istotne - przeprowadzenia badań całości pod kątem spełniania wymogów prawnych. Z uwagi na powyższe chipy komunikacyjne to propozycja dla producentów działających w dużej skali i dysponujących zapleczem badawczo-rozwojowym.

Na bazie chipów liczni producenci wytwarzają moduły komunikacyjne, a więc komponenty stanowiące funkcjonalną i przetestowaną całość. Zawierają one kompletną platformę sprzętową, nierzadko też część cyfrową zarządzającą transmisją danych tak, aby dla aplikacji transmisja była prosta. Moduły są badane na zgodność z EMC, a jeśli działają w jakimś standardzie własnościowym (np. Bluetooth LE), to jego producent bierze na siebie też kwestie opłat licencyjnych.

Skomplikowanie modułów i ich funkcjonalność jest nierzadko diametralnie różna: najprostsze są zdolne przesłać jedynie sygnał cyfrowy przez medium komunikacyjne, najbardziej złożone biorą na siebie całe zadanie wysłania pakietu danych lub nawet udostępniają zasoby własnego procesora, pamięci i portów, dzięki czemu można z nich zrobić całe urządzenie, pisząc prosty program w języku wysokiego poziomu i podłączając zasilanie.

Moduły wizualnie niewiele różnią się od chipów, są może minimalnie większe, ale miniaturyzacja posunęła się tak bardzo, że nawet złożone konstrukcje przypominają duże układy scalone (obudowa LGA). Stąd pewnie biorą się pomyłki, co jest chipem, a co modułem.

Na bazie modułów i chipów tworzone są gotowe urządzenia komunikacyjne, a więc takie, które mają obudowę, zasilanie, gniazda, a w środku kompletną platformę pozwalającą dołączyć za jego pomocą urządzenie do sieci, spiąć razem dwa urządzenia, bez konieczności budowy hardware i pisania software’u. Gotowe urządzenia mają też kontrolki i przełączniki oraz wyjście na antenę zewnętrzną, a także bardzo rozbudowaną funkcjonalność w zakresie oprogramowania wewnętrznego, np. wbudowany webserwer, system operacyjny, wyświetlacz LCD i nierzadko obsługują kilka standardów radiowych i pasm częstotliwości.

Azjatycka tandeta

Podobnie jak w wielu innych sektorach rynku elektroniki, relacje na rynku komunikacji psuje azjatycka tandeta - chodzi głównie o przypadkowej jakości moduły GSM, pochodzące od nieznanych producentów oraz podróbki rozwiązań markowych. Podobnym problemem są moduły bez certyfikatów oraz wniesionych opłat licencyjnych za korzystanie z chronionych rozwiązań intelektualnych.

Urządzenia te są niebezpieczne dla biznesu, bo tutaj problemy mogą się ujawnić znacznie później, gdy produkt będzie już u użytkownika końcowego i np. okaże się, że źle pracuje w sieci, generuje zaburzenia zakłócające pracę innych węzłów lub nie jest zgodny w pełni z deklarowanym standardem, bo nikt go nie badał, a "certyfikacja" polegała na przygotowaniu nalepki. Problemy takie wcale nie są wyimaginowane, bo wiele sieci M2M ma charakter publiczny i działa w oparciu o wspólne platformy informatyczne i telekomunikacyjne. Takie ułomne urządzenia tworzą dziury i stają się zagrożeniem bezpieczeństwa i integralności danych.

Jak wspomniano wcześniej, z roku na rok na rynku jest coraz więcej produktów komunikacyjnych. To samo można powiedzieć o dostawcach tych produktów, co ma oczywiście duży wpływ na to, że konkurencja w tym sektorze jest silna.

Każdy chce mieć swój standard

Ankietowani specjaliści zwracali w ankietach uwagę, że co chwilę pojawiają się nowe standardy komunikacji, zwłaszcza bezprzewodowej, niemniej widać, że wiele z tych nowych propozycji nie ma wielkich szans na sukces biznesowy. Przyczyna leży najczęściej po stronie skali przedsięwzięcia i potencjału finansowego pomysłodawcy, który jest za mały do tego, aby stworzyć masę krytyczną dla rozwoju technologii. Wystarczy przypomnieć tutaj WiMAX lub UWB.

Ankietowani specjaliści zwracali w ankietach uwagę, że co chwilę pojawiają się nowe standardy komunikacji, zwłaszcza bezprzewodowej, niemniej widać, że wiele z tych nowych propozycji nie ma wielkich szans na sukces biznesowy. Przyczyna leży najczęściej po stronie skali przedsięwzięcia i potencjału finansowego pomysłodawcy, który jest za mały do tego, aby stworzyć masę krytyczną dla rozwoju technologii. Wystarczy przypomnieć tutaj WiMAX lub UWB.

Takie pomysły na protokoły, modulacje i podobne rozwiązania są też na wyrost nazywane standardami. Faktycznie są to własnościowe rozwiązania konkretnej firmy, rzadziej stowarzyszenia, które liczy po wypromowaniu na kasowanie opłat za licencje. W praktyce, aby dany pomysł-projekt się przebił i został standardem, musi wnieść dużą zmianę i wartość dodaną dla użytkowników. Inaczej szanse ma słabe, a świadomi użytkownicy skierują się ku otwartym protokołom alternatywnym.

Ponieważ nie da się ocenić nic z góry ani od razu stwierdzić, czy dane rozwiązanie zyska szerokie uznanie rynku i faktycznie miano standardu (oczywiście nie firmowego, ale uznanego przez IEEE), w praktyce dominuje ostrożność i rezerwa w decyzjach.

Przykładem opisanych procesów mogą być sieci Sigfox i LoRa zaliczane do kategorii LPWAN dla potrzeb aplikacji IoT. Pierwszą firmuje francuska firma Sigfox założona w 2009 roku, do której należą prawa intelektualne, druga została opracowana przez firmę Semtech, obecnie rozwój technologii koordynowany jest przez organizację non profit LoRa Alliance skupiającą ponad setkę firm członkowskich. LoRa promowana jest jako "standard otwarty", niemniej specjaliści dodają do tego określenia słowo "prawie".

Są to rozwiązania o zbliżonej funkcjonalności, które zapewniają duży zasięg kosztem niewielkiej prędkości transmisji i są reklamowane jako alternatywa dla sieci komórkowych. Aktualnie ich przyszłość wydaje się mieć niezłe perspektywy, ale już się słyszy, że w sieciach komórkowych też powstanie protokół o charakterze LPWAN - ma on się nazywać LTE-M, a drugi to Narrowband Cellular IoT powstający jako tzw. 3rd Generation Partnership Project (3GPP) Release 13. Jest jeszcze 6LoWPAN oraz Thread - koncepcja firm Google, Samsung, ARM, Freescale i Silicon Labs.

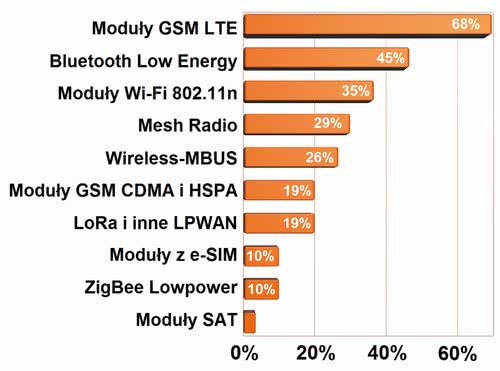

Obecnie konstruktor ma do wyboru nie tylko kilka generacji Wi-Fi (równolegle używanych), kilka generacji sieci komórkowych różniących się nie tylko przepustowością, ale i poborem mocy oraz kilka generacji Bluetooth, z których nie wszystkie są ze sobą kompatybilne. Do dyspozycji są też własnościowe protokoły, takie jak MiWi, wspomniana LoRa i Sigfox, JenNet, kilka przemysłowych (np. Wireless M-Bus), a na horyzoncie jest już ZigBee 3.0. Jeśli ktoś myślał, że sytuacja w protokołach się z czasem wyklaruje, to raczej nie ma na to szans.

Czy będzie renesans Zigbiego?

Kolejnym standardem, w którym ostatnio również zachodzą zmiany, jest ZigBee. I tak jak Bluetooth zyskał na popularności kilka lat temu, tak ZigBee zaczyna zyskiwać teraz, bo przez wiele lat był ale rozwój dreptał w miejscu a ceny modułów w tym standardzie odstraszały wielu chętnych - równoważne rozwiązania były znacznie tańsze.

ZigBee zadomowił się w zasadzie tylko w zastosowaniach przemysłowych, gdzie cena nie jest krytyczna, a koszt członkostwa ZigBee Alliance nie odstraszał. Pozycję lidera ZigBee straciło również na rynku sensorów. Nadzieja na renesans wynika z faktu, że teraz wychodzi poza świat automatyki przemysłowej, wkraczając najpierw do automatyki domowej i dobrze wpisuje się w trend IoT.

Głównymi zaletami ZigBee są niewielki pobór mocy, obsługa sieci o topologii kraty oraz fakt, że standard ten przyjęło wiele ważnych firm na rynku. Na przestrzeni lat, oprócz kolejnych wersji protokołu ZigBee (np. ZigBee Pro), powstały też liczne profile aplikacji, podobnie jak w przypadku Bluetooth. Należą do nich m.in. ZigBee Home Automation, ZigBee Smart Energy, ZigBee Remote Control, ZigBee IP, ZigBee Retails Services, ZigBee Green Power czy ZigBee Light Link.

Występują one w różnych, nie zawsze ze sobą kompatybilnych wersjach, a niektóre z nich bardzo znacząco się różnią. Tworzą one pewien zamęt, stąd ZigBee Alliance ostatnio zdecydowało się zunifikować wszystkie te obszary zastosowań, tworząc nową wersję standardu - ZigBee 3.0. Niemniej jest to standard wstecznie kompatybilny - korzysta z częstotliwości 2,4 GHz i protokołu ZigBee Pro do transmisji danych.

Sieci komórkowe są cały czas najważniejsze

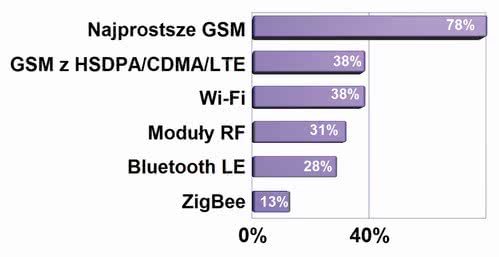

Moduły GSM ciągle stanowią główny nurt rozwoju aplikacji wykorzystujących komunikację bezprzewodową, a czynnikiem sprzyjającym jest ciągły spadek ich cen. Najważniejszym powodem jest to, że pozwalają one tworzyć duże systemy pomiarowe bazujące na obszarze całego kraju, związane z np. z transportem lub telemetrią, przy relatywnie niewielkich kosztach. Producenci modułów do sieci telefonii komórkowej implementują w nich coraz więcej funkcjonalności, dzięki czemu klient dostaje coraz bardziej zaawansowany moduł w cenie często niższej niż model poprzedni. Upraszcza to tworzenie urządzeń i obniża koszty docelowej aplikacji, gdyż nierzadko zewnętrzny mikrokontroler lub dodatkowe układy stają się zbędne.

Jeszcze do niedawna zdecydowana większość sprzedawanych modułów to były głównie moduły GPRS/EDGE, czyli sieci 2G, obecnie coraz częściej są to sieci 3G i moduły obsługujące technologię 3G/HSDPA/HSUPA i HSPA+, a w ostatnich miesiącach także przemysłowe moduły LTE. To, że na rynku pojawiają się takie szybkie modemy, to też wynik tego, że w podstawowym kształcie sieć GSM/GPRS jest już produktem bardzo dojrzałym, stąd markowi producenci uciekają w stronę sieci 3G i LTE, bo tam są w stanie konkurować.

Komunikacja przewodowa

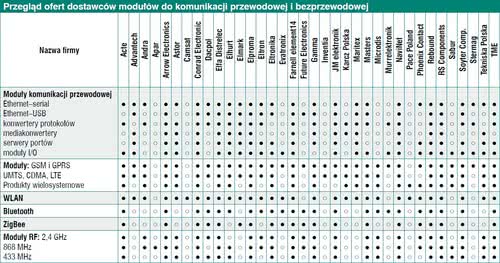

W zakresie komunikacja przewodowej oferta rynku skupiona jest na Ethernecie, gdyż tego typu sieci komunikacyjne są podstawą infrastruktury przedsiębiorstw przemysłowych, systemów kontroli dostępu i monitoringu obiektów, urządzeń pomiarowych i innych obszarów. Poza uniwersalnością i możliwościami komunikacyjnymi urządzenia infrastrukturalne, za pomocą których buduje się sieci komunikacji przewodowej, można zasilać poprzez kabel sieciowy - PoE i PoE+ (Power over Ethernet).

Korzystanie z możliwości sieci bazujących na Ethernecie wymaga stworzenia infrastruktury komunikacyjnej, do której poza okablowaniem, przełącznikami (switchami) i routerami tworzącymi fizyczną podwalinę sieci konieczny jest sprzęt taki, jak konwertery sieciowe (konwertery mediów, mediakonwertery, urządzenia typu gateway). Są to przede wszystkim urządzenia z interfejsami do sieci szeregowych i innych przetwarzające komunikaty na standard ethernetowy, moduły służące do zmiany medium transmisyjnego - w szczególności Ethernetu miedzianego na światłowodowy.

Do produktów tego typu należą też serwery portów, czyli inaczej konwertery interfejsów sieciowych, wyposażone we własny komputer zapewniający możliwość programowania i ustawiania parametrów oraz karty sieciowe. Często są to wersje wieloportowe, co pozwala na komunikację z wieloma innymi urządzeniami, stosując jedną kartę instalowaną przykładowo w komputerze przemysłowym.

Osobą grupę stanowią moduły we-wy, które pozwalają na podłączenie wielu sygnałów/urządzeń i komunikację z tymi ostatnimi z wykorzystaniem jednego połączenia sieciowego. Podzespoły dostępne są w różnych wykonaniach - z wejściami i wyjściami cyfrowymi, jak też analogowymi, przeznaczonymi do podłączania określonych czujników, liczników, napędów, itd.

Oprócz wersji kablowych dostępne są urządzenia z interfejsem WLAN. Ich funkcjonalność jest podobna jak opisanych wyżej, z tym że łącze ethernetowe realizowane jest bezprzewodowo, ze wszystkimi popularnymi usługami związanymi z komunikacją za pomocą protokołu TCP/IP. Komunikacja ta może bazować na paśmie 2,4/5 GHz lub pasmach licencjonowanych, np. 400-470 MHz.