Wiedza, a w zasadzie problem, gdy jej brakuje

Bezsprzecznie, w obecnych czasach trzeba mieć wiedzę na temat zjawisk fizycznych związanych z badaniami, przynajmniej podstawowe kompetencje metrologiczne, a najlepiej też doświadczenie wynikające z wcześniejszych projektów. W ten sposób staje się wiadome, co trzeba kontrolować, jakie są limity, gdzie mogą się pojawić problemy. Jeśli firma ma taką wiedzę, uzyskanie zgodności z wymaganiami dyrektyw i normami jest łatwiejsze, gdyż większość środków ochronnych można zrealizować na etapie projektowania. Gdy rozeznania brakuje, wówczas projektowanie wiąże się z większą niepewnością co do wyników pomiarów oraz ryzykiem, że ewentualny problem trzeba będzie rozwiązać w kosztowny sposób. Na przykład za pomocą drogich materiałów ekranujących lub przez przeprojektowanie układu i płytki. Potem oczywiście trzeba będzie wykonać następne badania, co dodatkowo będzie kosztować i zabierze czas.

Jak sygnalizowano nam w komentarzach do ankiety, w kraju prowadzonych jest za mało szkoleń uświadamiających realny wpływ wyniku negatywnego badań na poziom generowanego zagrożenia podczas użytkowania takich urządzeń elektronicznych. Zdecydowanie najtrudniejszym zagadnieniem jest kompatybilność elektromagnetyczna, w obrębie której zjawiska nie są możliwe do zaobserwowania gołym okiem, stąd też dużo trudniejsze w zrozumieniu pryncypiów rządzących polem elektromagnetycznym i zaburzeniami.

Najważniejsze cechy, jakie biorą pod uwagę firmy zlecające badania swoich wyrobów

W tym roku w zestawieniu najważniejszych cech laboratoriów badawczych, które rozważają klienci, na szczycie jest wygoda. Firmy chcą mieć wykonany komplet oceny w jednym miejscu i jak najkrótszym czasie. Zapewne oferta kompleksowych badań w jednym miejscu też wiąże się z szybkością, stąd te dwa kryteria można w tym kontekście traktować łącznie. Na dalszych pozycjach uplasowały się tradycyjne wartości, jak posiadanie akredytacji, duże kwalifikacje kadry, która nie tylko sprawdzi, jak jest, ale też pomoże znaleźć przyczynę problemów. Znaczenie tego czynnika potwierdzają dodatkowo wysoko notowane konsultacje projektowe i godziny inżynierskie, możliwość uczestniczenia w badaniach i badania prototypów. Charakterystyczną cechą wykresu jest też to, że poza pierwszymi trzema górnymi polami i ostatnim na dole, cała reszta ma podobną wielkość.

Walka o koszty prowadzi do działania "na krawędzi"

Ogólną regułą w projektowaniu elektroniki jest uzyskanie jak najlepszego balansu między kosztami oraz uzyskiwanym efektem. Odnosząc tę ogólną regułę do np. badań związanych z kompatybilnością elektromagnetyczną, można powiedzieć, że projektant będzie się starał zastosować w urządzeniu filtr sieciowy po to, aby ograniczyć przenikanie zaburzeń do sieci zasilającej. Niemniej skuteczność takiego filtru, a więc wielkość i koszt, trzeba dobrać tak, aby zmieścić się w narzuconym limicie z minimalnym zapasem (marginesem). Rozbudowany, skuteczny i drogi filtr zapewni oczywiście duży margines, ale nie będzie on wówczas opłacalny z punktu widzenia kosztu BOM. Stąd potrzebny jest taki element, aby zbić zaburzenia minimalnie poniżej limitu normy.

W efekcie walki o koszty wiele urządzeń jest zgodnych z wymaganiami, ale niekoniecznie z zapasem. Często ocena zgodności jest robiona na początku produkcji, a potem następuje kilkanaście zmian konstrukcyjnych i modernizacji. Trudności z dostępnością podzespołów nasiliły to zjawisko, że część hardware się często zmienia (są nowe rewizje) i jego skutkiem jest to, że często sprzęt nie spełnia wymagań. Bo był zaprojektowany na krawędzi, a potem przestał być kontrolowany. Stąd często biorą się problemy ze zgodnością w urządzeniach, które były badane i przeszły ścieżkę akceptacji.

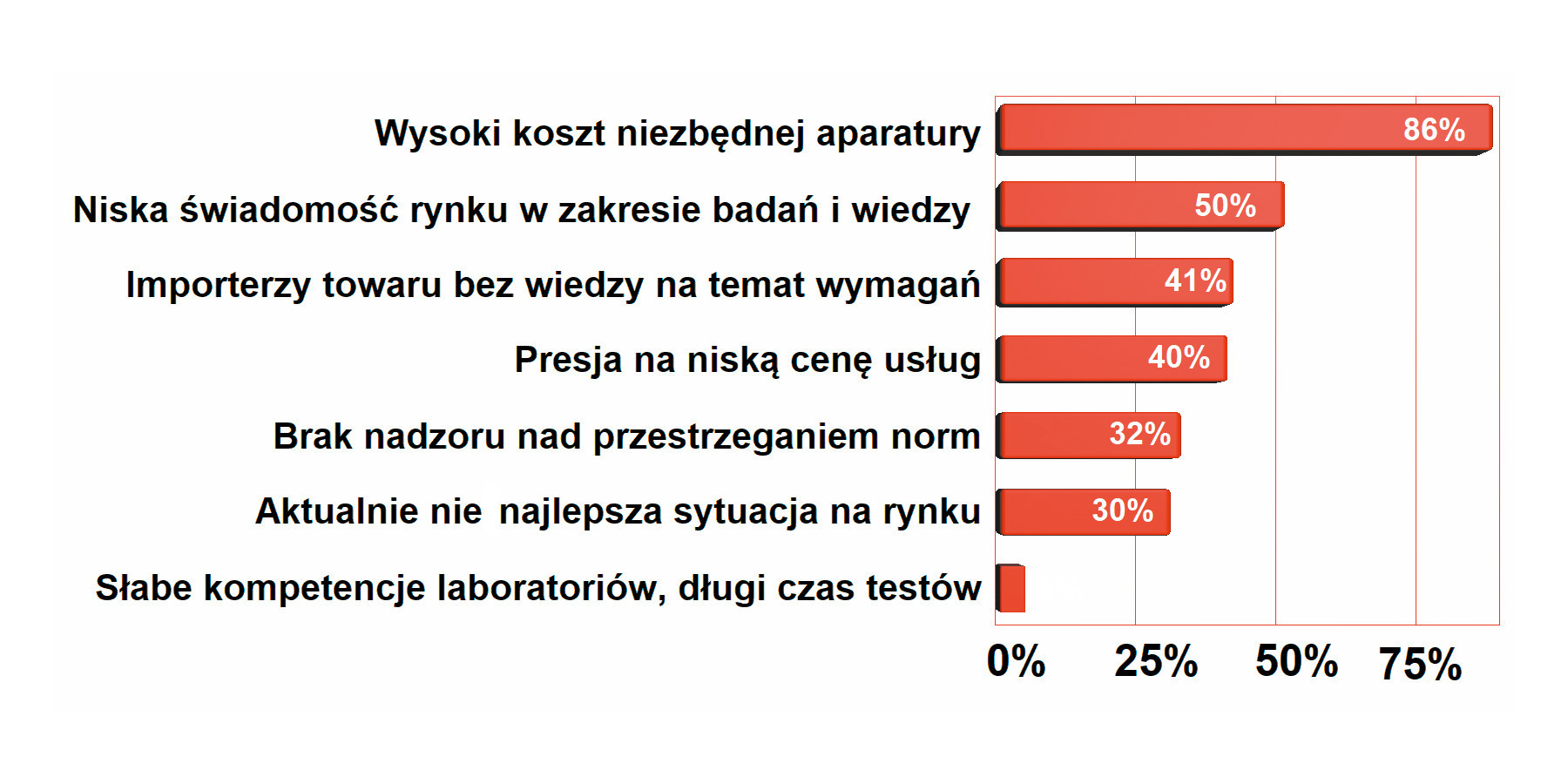

Główne czynniki oddziałujące negatywnie na rozwój rynku usług badawczych

Wysoki koszt aparatury pomiarowej niezbędnej do badań od lat jest na szczycie zestawienia najważniejszych czynników negatywnie oddziałujących na rozwój rynku usług badawczych. Zaawansowana aparatura jest bardzo kosztowna, wymaga okresowej kalibracji, a wyniki badań muszą być porównywane z innymi placówkami, co też jest kosztem. Ponieważ klienci żądają kompleksowości, sprzętu pomiarowego trzeba mieć na stanie dużo i stale w coś inwestować, aby dotrzymać kroku konkurencji, zmieniającym się normom i postępowi w technice. Z tej przyczyny najlepszy sprzęt mają placówki rządowe i uczelniane.

Warto dodać, że inżynierowie także za bardzo wierzą w to, co widzą na ekranie, zapominając o niepewności pomiaru, dokładności przyrządów oraz samej specyfice realizowania badań. Potem często okazuje się, że u nich "jest dobrze", że sprzęt "w quasi-peakach przechodzi", a nadzór rynku ma inne zdanie. Czemu tak się dzieje, można opisać na przykładzie komory bezechowej.

Grzegorz Modrykamień

dyrektor sprzedaży, członek zarządu EMC-FORTO

- Jakie zmiany w podejściu firm do badań urządzeń elektronicznych warto zauważyć?

Odpowiedź na to pytanie zależy jak długi czas przyjmiemy do analizy. Z mojej obserwacji jako konstruktora elektroniki w latach 2000-2007, z dzisiejszej perspektywy zmieniło się wszystko. Zarówno wyposażenie laboratoriów, dostępność, lista oferowanych badań w jednym miejscu i kompetencje zespołów oraz rozumienie potrzeby wykonywania testów uległo całkowitej zmianie. Charakterystyczne dla dawnych czasów wyobrażenie, że badanie musi być zrobione, "bo będzie kontrola" – wyewoluowało. Dziś rozumiane jest jako jeden z filarów wiedzy o własnej konstrukcji, jest istotnym składnikiem zapewnienia jakości, a także elementem walki konkurencyjnej. Innym aspektem zachodzących zmian jest konieczność dobrego przygotowania badań ze względu na złożoność sprzętu i oprogramowania firmware, a także to, że za uzyskanie zgodności jest odpowiedzialny cały zespół. Dziś trudno uwierzyć, że w przeszłości za wszystkie badania środowiskowe funkcjonalne i "zgodnościowe" bywał odpowiedzialny tylko konstruktor elektroniki.

- Jak wyglądają możliwości badawcze laboratoriów w kraju dla firmy, których produkty można określić mianem high-end?

Zauważalny jest trend rozwijania wysokiej specjalizacji laboratoriów w Polsce. Temu celowi służył też projekt Lab-Net realizowany przez zespół laboratoriów w Polsce. Ale nawet placówki, które nie brały udziału w tej inicjatywie, ze względu na rosnącą konkurencję, potrzeby swoich klientów oraz na istotny fakt że firmy zlecające badania, najczęściej posiadają nieduży zestaw narzędzi podstawowych do badań odporności i emisji przewodzonej do celów wewnętrznych badań konstrukcyjnych – poszerzają swoją ofertę.

Oddzielną grupą klientów są firmy motoryzacyjne oraz związane z przemysłem obronnym. Z różnych powodów mają one przekrojowe możliwości wykonania badań. Zatrudniają kilkuset inżynierów testów, posiadają często po kilkadziesiąt komór termicznych, kilkanaście komór EMC wyposażonych w aparaturę i emulatory obciążenia.

- Jakie obszary oferty Polskich laboratoriów są jeszcze niezagospodarowane lub trudno znaleźć w Polsce/Europie stanowisko dla jakiejś branży?

Dziś czołowe laboratoria badawcze uzupełniają ostatnie luki w niszach jak np. max wartość szczytowa surge, zakresy częstotliwości w testach odporności na pola o częstotliwościach radiowych 40 GHz 200V/m, czy też maksymalna moc symulatora sieci zasilania dla EVSE. Ale myślę, że w niedalekiej przyszłości, ze względu na dynamikę rozwoju elektroniki, możliwość wykonania badań kombinowanych to znaczy np. RED+EMC+AI (od prostych asystentów wspierających nasze codzienne czynności do autonomicznych urządzeń powszechnego użytku z rozpoznawaniem danych cech) będzie poszukiwana. Wierzę, że Polskie laboratoria świetnie dostosują ofertę, a mają przewagę w Europie ze względu na dobre wykształcenie inżynierów, co akurat w badaniach np. EMC jest wielkim atutem. Ogólne perspektywy dla rynku badań w Polsce są bardzo dobre.

|