Rynek komputerów jednopłytkowych jest bardzo rozproszony i podzielony między licznych producentów skupionych wokół branżowych organizacji zajmujących się promocją i rozwijaniem standardów (wymiary, złącza, konfiguracje), jak PICMG. Konsolidacje i akwizycje ostatnich lat także zmieniają krajobraz, a nierzadko przetasowania wynikają także z tego, że na rynku pojawiają się nowi gracze. Lista producentów jest w tym przypadku bardzo długa (blisko 40 firm), co powoduje, że konkurencja jest silna, a tempo zmian i ewolucji technicznej produktów relatywnie szybkie. Takie firmy to m.in. Digi, VersaLogic, Wandboard, Eurotech, Advantech, Kontron, Adlink, Radisys, Mercury Systems, Winsonic, Syslogic, Qbic, American Portwell, Arbor Solutions, Aaeon, Diamond Systems, iEi, Avalue, Variscite, DFI, Congatec, iBase, MPL, Protech i wiele innych. Mamy też krajowe firmy, które projektują i produkują takie jednostki, jak na przykład Grinn i SomLabs.

Bezsprzecznie sektor komputerów jednopłytkowych z każdym kolejnym rokiem staje się coraz bardziej otwarty dla przeciętnego konstruktora, a coraz niższe ceny i większa dostępność sprawiają, że dostęp do tych rozwiązań jest praktycznie nieograniczony. Rynek SBC przenika się ponadto ze światem tradycyjnych pecetów, z których rozwiązania w postaci nowych wersji miniaturowych płyt głównych stają się bazą dla komputerów przemysłowych, jak na przykład Pico-ITX (100×72 mm).

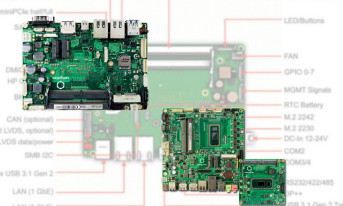

Oprócz nastawienia na coraz większą miniaturyzację, producenci zwracają uwagę głównie na możliwości rozbudowy komputera o kolejne interfejsy we/wy. Poprzez specjalizowane złącze (np. na spodzie płytki SMARC) tworzą w ten sposób rozwiązania podobne do kanapki, które do tej pory były wykorzystywane w rzadziej już stosowanych komputerach PC/104. Wprowadzanie kolejnych generacji energooszczędnych procesorów Intel Atom, Celeron czy Pentium spowodowało, że producenci wypuszczają na rynek nowe modele komputerów SBC z interfejsami do tej pory niewystępującymi, jak np. dla pamięci dyskowej w postaci złączy M2.

Konkurencja ze strony platform open source

Na rynku elektroniki profesjonalnej zawsze dało się wyróżnić trend polegający na używaniu sprzętu o gorszych parametrach w wymagających aplikacjach. Najczęściej dotyczyło to zakresu temperaturowego i urządzeń przeznaczonych do pracy na zewnątrz budynków, także tych działających w trudnych warunkach przemysłowych, systemach monitoringu i bezpieczeństwa oraz podobnych zastosowaniach.

Komputery, nośniki pamięci, kamery, sprzęt infrastruktury sieciowej i telekomunikacyjny do takich aplikacji musi mieć możliwość pracy w zakresie temperatur od –40 do +70ºC i za ten szeroki zakres trzeba było zapłacić dużo więcej niż za równoważne rozwiązania konsumenckie (0–40ºC). Przebitka była na tyle duża, że plagą rynku było aplikowanie sprzętu konsumenckiego w takich zastosowaniach, całkowicie bezmyślnie, a więc ze złudną nadzieją, że będzie mimo to działać lub ze wspomaganiem w postaci np. termostatu, dodatkowego chłodzenia itd. To samo dotyczyło nośników pamięci Flash, gdzie tanie produkty konsumenckie trafiały do wymagających rozwiązań profesjonalnych. Podobne działania miały miejsce w urządzeniach wojskowych, gdzie mówiło się o produktach COTS, a więc właśnie zmodernizowanych, ulepszonych urządzeniach komercyjnych, które przystosowano do pracy w sprzęcie wojskowym. To dostosowanie polegało na rozbudowie chłodzenia, hermetyzacji itd. Tematy te były bardzo nośne jeszcze dekadę temu, ale obecnie kompletnie zeszły na margines.

Powody mają charakter ekonomiczny i techniczny. Ten pierwszy wiąże się z tym, że większa konkurencja, szersza oferta rynku, większa liczba producentów i dystrybutorów aktywnych w temacie komputerów jednopłytkowych zmniejszyła różnicę między produktami różnych typów. Można powiedzieć, że to te profesjonalne są dzisiaj relatywnie tańsze, zwłaszcza w odniesieniu do zarobków, poziomu cen innego sprzętu technicznego itd. Sam rynek elektroniki jest dzisiaj znacznie większy i stąd wolumeny sprzedaży są większe, dzięki czemu koszty stałe przedsiębiorstw rozkładają się na większą liczbę sztuk.

Druga przyczyna ma charakter techniczny i wiąże się ze wzrostem zaawansowania technologii półprzewodnikowej. Nawet tanie chipy działają w szerokim zakresie temperatur i granice między tymi do zastosowań profesjonalnych i konsumenckimi nie są tak wyraźnie rozdzielone. Procesory nie zawsze są też wydzielonymi chipami, a więc wykonywanymi w osobnym procesie i zamykane w obudowach. Wiele produktów ma je zintegrowane w ramach układu SoC razem z pamięcią, pomocniczą logiką itp. Jest to możliwe, ponieważ procesor można kupić jako kod VHDL w postaci bloku IP i zintegrować go z niezbędną resztą na jednym płatku krzemu. Takie SoC produkowane są na tych samych urządzeniach co inne i stąd zwykle mają doskonałe parametry temperaturowe.

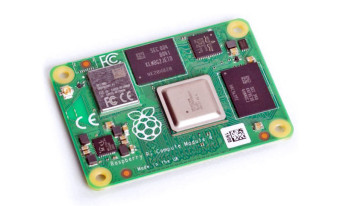

Skutkiem tych procesów jest to, że tanie i popularne komputery jednopłytkowe, czego doskonałym przykładem może być Raspberry Pi, mają całkiem dobre parametry środowiskowe i są z powodzeniem aplikowane w aplikacjach komercyjnych, odbierając rynek rozwiązaniom specjalizowanym (dedykowanym).

Platformom open source najbardziej brakuje wieloletniej dostępności, przez co ich możliwości aplikacyjne sięgają jedynie obszaru półprofesjonalnego, a więc takiego o łagodnych wymaganiach.