Sztuczna inteligencja to odpowiedź na wyzwania, jakie dla biznesu prezentuje efektywne wykorzystanie coraz większego strumienia danych generowanych przez konsumentów każdego dnia. Zadanie to jest trudne nie tylko z uwagi na ilość danych, ale także ponieważ informacja wejściowa może mieć różną formę, natomiast ostateczny wynik musi brać pod uwagę każdy jej typ. To nie tylko tekst, dźwięk i obraz, ale w przyszłości również coraz więcej danych z urządzeń w sieci Internetu Rzeczy (IoT). Według prognoz, ilość danych generowanych przez systemy AI w 2025 roku przekroczy 160 zetabajtów, z czego 80% będą to dane nieustrukturyzowane (surowe).

Technologie sztucznej inteligencji pozwalają doposażyć systemy elektroniczne w procesy poznawcze, które umożliwiają im podejmować prawidłowe decyzje nawet w warunkach niepewności. Faza uczenia się obejmuje analizę dużych zbiorów danych i poznawanie zasad i zależności opisujących studiowany model. Dzięki temu aplikacja nabiera zdolności do podejmowania decyzji i rozwiązywania problemów bez ingerencji człowieka. W większości przypadków jest to jedna określona funkcja, jak rozpoznawanie mowy czy autonomiczne prowadzenie samochodu.

Sprzęt jest kluczem do AI

Rozwój sztucznej inteligencji wiąże się nieodłącznie z inwestowaniem w nowoczesne technologie. Mimo że dyskusja w tym temacie często koncentruje się na warstwie software, część sprzętowa jest równie ważna. Aplikacje AI operują na gigantycznych zbiorach informacji, wykorzystując skomplikowane algorytmy i zależności. W wielu przypadkach, jak autonomiczne auta czy systemy bezpieczeństwa, szybkość działania systemu jest kluczowa. Aby więc w pełni rozwinąć potencjał AI, potrzebne są innowacje w zakresie zbierania, przesyłu, przechowywania i analizy ogromnych ilości danych. Oznacza to potencjalnie duże inwestycje w infrastrukturę komunikacyjną, centra danych i moc obliczeniową.

O dużym potencjale rynku półprzewodników do zastosowań w AI i do uczenia maszynowego informują analitycy firmy Allied Market Research, prognozując wzrost w okresie od 2017 do 2025 r. w średnim tempie ponad 40% rocznie. Tak szybki rozwój rynku będzie napędzany coraz szerszym użyciem narzędzi AI w różnych obszarach biznesowych. Scenariusz optymistyczny zakłada, że po sukcesie pierwszych komercyjnych realizacji stopniowo coraz więcej firm o różnym profilu działalności będzie wykorzystywać te narzędzia do osiągnięcia przewagi nad konkurencją. Rozwój technologii zwiększy też jej dostępność.

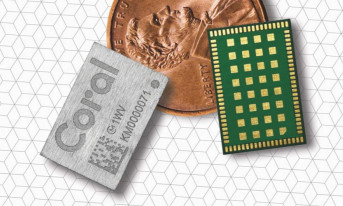

Aplikacje bazujące na metodach sztucznej inteligencji mają podwyższone wymagania co do mocy obliczeniowej i pamięci, aby pomieścić i przetworzyć ogromne ilości danych. Rozpowszechnienie się tych rozwiązań ma szansę być więc impulsem do gwałtownego wzrostu zapotrzebowania na półprzewodniki. Obecnie rozwój i komercyjne wdrożenia rozwiązań sztucznej inteligencji są głównie domeną wielkich firm, które mogą sobie pozwolić na inwestycje w potrzebną infrastrukturę. W pierwszej kolejności inwestycje te będą obejmować centra danych. W większości aplikacji duża część intensywnych obliczeń realizowana jest w chmurze, a do urządzenia użytkownika przesyłany jest ostateczny wynik. Tak działają m.in. coraz popularniejsze usługi wirtualnych asystentów. Wraz ze wzrostem mocy obliczeniowych dostępnych w elektronice konsumenckiej część zadań związanych z AI będzie mogła być realizowana na poziomie indywidualnego urządzenia. Nie chcąc ryzykować oddania pola na tak obiecującym rynku, czołowi producenci półprzewodników już ogłaszają produkty do tych zastosowań.

CPU czy GPU?

Nowe technologie w początkowej fazie adaptacji na rynku zwykle cechuje brak standardów i mnogość testowanych rozwiązań. W przypadku AI branża nadal szuka optymalnej architektury sprzętowej. W dużym uproszczeniu najczęściej stosowane rozwiązanie opiera się na przeniesieniu najintensywniejszych obliczeń do dedykowanego układu, odciążając centralny procesor. Układ ten może być typu ASIC, FPGA lub GPU, jednak to, które z tych rozwiązań ostatecznie uzyska dominację, nie jest jeszcze przesądzone. Duże znaczenie będzie miało, który z czołowych projektów AI najlepiej przyjmie się na rynku.

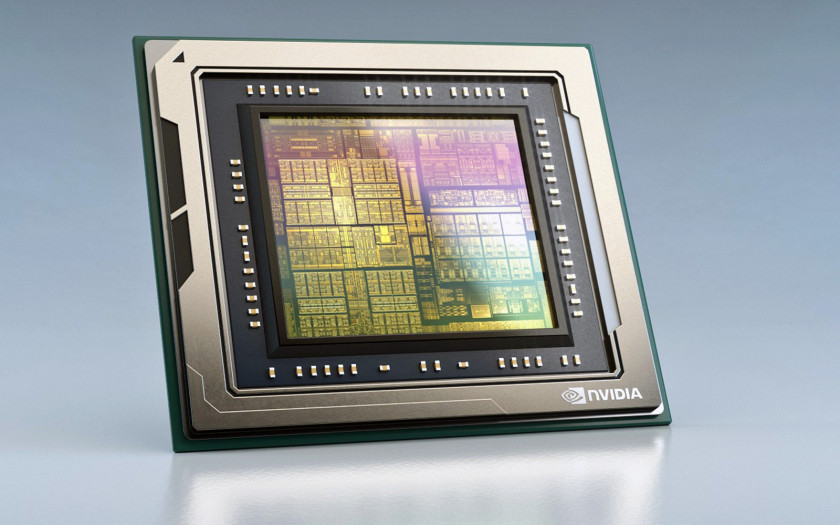

Obecnie większość firm, budując infrastrukturę do AI, decyduje się na układy GPU, przede wszystkim produkcji Nvidii. Wybór ten jest motywowany specyfiką pracy tych układów. Układy graficzne pierwotnie przeznaczone były do wykonywania obliczeń na potrzeby grafiki komputerowej, w której dominują operacje macierzowe. Różnią się one od tradycyjnych CPU, które realizują porcje kodu liniowo, że obliczenia są wykonywane równolegle. Układ GPU składa się z dużej liczby bloków wykonawczych o uproszczonej logice i o wyspecjalizowanych zadaniach. Dla porównania, najnowsze układy GPU Nvidii wyposażone są w ponad 10 tys. rdzeni, podczas gdy najbardziej zaawansowane procesory Intela mają ich co najwyżej kilkadziesiąt. Oczywiście, w przypadku GPU są to jednostki o uproszczonej architekturze, optymalizowane do wykonania jednocześnie wielu prostych i podobnych do siebie operacji. Wysoka wydajność GPU w równoległym przetwarzaniu danych jest szczególnie przydatna podczas fazy uczenia się aplikacji AI, kiedy to system korzystając z dużych zbiorów danych, uczy się swoich funkcji, analizując rzeczywiste przykłady.

Jak ostatecznie będzie wyglądała sytuacja na rynku, nie jest przesądzone, ponieważ zarówno producenci CPU, jak i GPU intensyfikują prace nad dostosowaniem swoich produktów do wyśrubowanych wymagań technologii AI. W segmencie GPU potentatem jest Nvidia, która przedstawiła platformę CUDA, czyli architekturę obliczeniową typu równoległego o dużej wydajności. Flagowym produktem firmy jest architektura Ampere wykorzystująca rdzenie Tensor, akcelerator obliczeniowy zoptymalizowany pod kątem aplikacji AI i uczenia maszynowego. Strategia firmy zakłada rozszerzenie zakresu zastosowań jej układów poza tradycyjne funkcje procesora graficznego. Tesla zyskała popularność wśród klientów z takich branż jak farmaceutyczna czy finansowa z uwagi na wysoką wydajność przy stosunkowo niskim koszcie i małym poborze mocy. Jednym z klientów Nvidii jest GE Healthcare, który korzysta z układów firmy m.in. w inteligentnych systemach tomografii. W 2019 roku Nvidia przedstawiła układ typu system-on-chip o nazwie Drive AGX Orin do projektów AI, przede wszystkim autonomicznych aut. Układ, który ma trafić do produkcji w 2022 roku, oparty będzie na nowej architekturze Ampere iGPU i zawierał będzie dwanaście rdzeni Arm Hercules, co ma przełożyć się na imponującą wydajność 2000 TOPS.

Obok Nvidii czołowym dostawcą GPU do ogólnego zastosowania jest AMD, natomiast konkurencja w tym obszarze znacznie się zintensyfikowała w 2021 r., kiedy to swoje układy GPU o nazwie Iris Xe wypuścił Intel. Niezależnie od tego, Intel nadal koncentruje się na swoim głównym biznesie. Według przedstawicieli firmy, sprzedaż procesorów do zastosowań w AI i związanych z tym usług w 2019 r. przekroczyła 3,8 mld dolarów. Jak przekonują, inżynierom Intela udało się zmodyfikować architekturę układów Xeon, dzięki czemu proces uczenia się systemów AI opartych na tym procesorze stał się 200 razy wydajniejszy. Rozwój oferty w zakresie AI jest dla firmy kluczowy, jako że z uwagi na stagnację na rynku komputerów osobistych jest ona zależna od sektora centrów danych. A to jest obszar, w którym wdrażanie rozwiązań AI, jak np. rozpoznawanie mowy, następuje najszybciej.

Wyzwanie dla innowacji

Układy GPU nie są jednak idealne. Po pierwsze, są koprocesorem dla CPU, same nie są w stanie uruchomić i obsługiwać systemu operacyjnego. Dodatkowo, to co świadczy o ich głównej zalecie, czyli obliczenia równoległe, sprawia, że tylko doświadczony programista jest w stanie wykorzystać w pełni ich potencjał. GPU dobrze spełniają swoją funkcję podczas etapu uczenia się AI, jednak kiedy ten etap dobiega końca i aplikacja ma zacząć realizować swoją funkcje, nie są one tak wydajne. Jak wynika z raportu firmy McKinsey, w większości aplikacji serwerowych obliczenia te są realizowane przez układy CPU. W najbliższych latach na popularności będą zyskiwać alternatywne rozwiązania, przede wszystkim wyspecjalizowane układy ASIC.

Część firm, prowadzących zaawansowane prace nad AI, inwestuje w rozwój sprzętu we własnym zakresie. Widać to w działaniach internetowych gigantów jak Google, Facebook czy Microsoft. Jest to obszar, gdzie algorytmy sztucznej inteligencji i uczenia maszynowego są dynamicznie rozwijane. Każda z tych firm buduje własną platformę usług i produktów opartych na AI, a co najważniejsze dla branży półprzewodników, prace te obejmują także infrastrukturę sprzętową. Facebook korzysta z układów ASIC dostarczanych przez Intel, platforma Project Brainwave Microsoft u oparta jest na FPGA od Altery (należącej do Intela), natomiast Google wytwarza układy ASIC o nazwie Tensor Processing Unit (TPU) we własnym zakresie. Amazon oferuje usługi uczenia maszynowego w ramach platformy Amazon Web Services, a serwery wspierające pracę wirtualnej asystentki Aleksy korzystają z układów Inferentia, zaprojektowanych przez firmę Annapurna Labs, którą gigant e-commerce przejął w 2015 r. Firma analityczna IDC szacuje, że w 2020 wartość dedykowanego do AI sprzętu zainstalowanego w serwerowniach wyniosła 13,4 mld dolarów.

Niezależnie od stosownej technologii, osiągi nawet najbardziej zaawansowanych układów nadal nie są w stanie zapewnić mocy obliczeniowej, która w pełni pozwoliłaby rozwinąć skrzydła AI. Wyzwanie to najlepiej obrazuje fakt, że superkomputer Summit, zbudowany przez IBM i wykorzystywany do badań nad AI korzysta z 9216 procesorów i 27 648 układów GPU Nvidii, zajmuje powierzchnię dwóch boisk do tenisa i wymaga zasilania równoważnego małemu miastu. Przypomina to sytuację z połowy ubiegłego wieku, kiedy to podobnej wielkości komputery wykorzystywane były do obliczeń, które dzisiaj nie sprawiłyby problemów zwykłemu smartfonowi. Sprzęt do AI będzie więc wymagał od dostawców elektroniki szukania nowych rozwiązań w zakresie produktów, materiałów, technologii wytwarzania i metod projektowania układów.

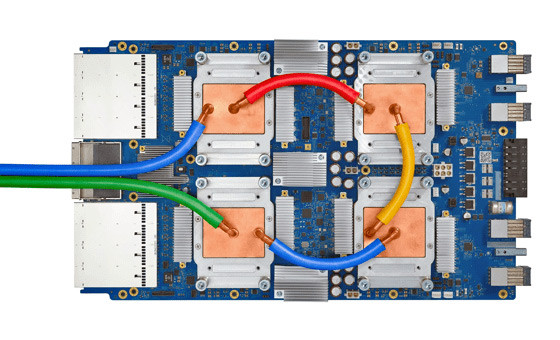

Układ Cloud TPU v3 Beta firmy GoogleGoogle w 2016 przedstawiło Tensor Processing Unit (TPU), układ typu ASIC wykonany w procesie 28 nm, który osiąga wydajność 92 trylionów operacji na sekundę przy poborze mocy zaledwie 75 W. Projekt ten kosztował ponad 300 mln dolarów Kolejne generacje TPU były ogłaszane przez Google w rocznych odstępach, przy czym według przedstawicieli firmy każda z nich oznacza przynajmniej dwukrotny wzrost wydajności. Pierwsza była przeznaczona tylko do kalkulacji w procesie wnioskowania, natomiast kolejne wspierają również proces uczenia się systemu. Układy te są używane w większości kluczowych usług firmy, np. do rozpoznawania tekstu w Google Street View, przetwarzania obrazu w Google Photos czy opartemu na sztucznej inteligencji systemu Rankbrain będącego kluczowym składnikiem algorytmu wyszukiwania Google. |

Szansa dla nowych graczy

W odróżnieniu od rynku komputerów czy smartfonów, gdzie nowi gracze nie mają szans zagrozić dominacji takich gigantów jak Intel czy Qualcomm, AI to nowy obszar, gdzie nie wszystkie karty zostały jeszcze rozdane. Poza gigantami, coraz więcej jest startupów pracujących nad półprzewodnikami do AI. Według analiz, liczba takich przedsięwzięć to ponad 45 firm, którym w 2017 r. udało się zebrać ponad 1,5 mld dolarów wsparcia od inwestorów. Przykładowo, chiński Cambricon, który pracujące nad rozwojem układów do AI, oficjalnie uzyskał status jednorożca, czyli startupu, którego wycena przekroczyła 1 mld dolarów Chińskie firmy pracujące nad technologiami AI korzystają z aktywnego wsparcia rządu, jako że Państwo Środka ma ambicje zdobycia roli światowego lidera w tej dziedzinie.

W 2016 Intel za kwotę 400 mln dolarów kupił Nervana Systems, młodą firmę założoną przez byłych inżynierów Qualcomma zaangażowaną w rozwój układów do deep learningu. Inny startup, Cerebras, uzyskał łączne dofinansowanie ponad 100 mln dolarów na rozwój układów zoptymalizowanych do wspierania procesu uczenia się aplikacji AI. Co ciekawe, firma przyciągnęła 5 inżynierów z Nervana, kiedy ten już został przejęty przez Intela. Innowacje powstają też w Europie. Brytyjski Graphcore uzyskał dotychczas łączne dofinansowanie ponad 682 mln na rozwój układów do AI. Pomysł firmy na przyspieszenie działania systemów AI to m.in. wyposażenie układu w większą ilość pamięci podręcznej w celu eliminacji opóźnień w przesyle danych.

Punktem wspólnym nowych graczy jest opracowanie układu dedykowanego do aplikacji AI, który zastąpi powszechnie stosowane do tego celu układy GPU. Siłą napędową tych nowatorskich przedsięwzięć jest przekonanie, że technologia AI nadal czeka na odpowiednie rozwiązania sprzętowe. Układy GPU szybko wypełniły lukę na rynku, jednak pierwotnie były one stworzone do innych zadań, a stosowane w AI wymuszają na użytkownikach pewne kompromisy. Branża nadal czeka na układy scalone budowane od podstaw z myślą o AI, przystosowane do pracy z dużymi i zmiennymi zbiorami danych, o szybkim działaniu i małym poborze mocy.

Jacek Dębowski